AMD vs NVIDIA: cuál es la mejor marca de GPUs y por qué

Desde 2016, hemos visto un gran progreso en la lucha de AMD vs NVIDIA, por lo que hemos querido recopilar las últimas luchas con el objeto de ver cuál es la mejor marca de tarjetas gráficas.

Nos gusta tirar de hemeroteca para ver cómo ha progresado la lucha en determinados mercados, y es que AMD vs NVIDIA es una guerra total. NVIDIA ha sido intratable durante la última década, y AMD solo ha podido aspirar a la relación calidad-precio, mientras que el equipo verde lideraba en la gama alta. Los diablos rojos han despertado yendo con todo, por lo que es el mejor momento para traeros esta lucha.

Índice de contenidos

Tarjetas gráficas AMD y NVIDIA: contexto histórico y novedades

Para no irnos muy atrás, hemos querido partir desde 2016 para dar una visión algo más actual de lo que AMD y NVIDIA han conseguido. Comentaremos todas las novedades que trajeron cada una de las arquitecturas y generaciones de tarjetas gráficas de cada equipo.

2016-2017, la era Pascal con GTX 1000 vs RX 400 y 500 con Vega

Empezamos con la arquitectura Pascal y con Solaris por parte de AMD, dos arquitecturas que tenían targets distintos porque el equipo rojo presentó mucha memoria VRAM, pero poca potencia.

Pascal y RX 400

En NVIDIA, veníamos de Maxwell (GTX 900), pero Pascal fue un cambio generacional brutal porque se aumentaban los CUDA Cores y, especialmente, la memoria VRAM. Todavía vemos GTX 1060 y 1080 Ti en muchos equipos como muestra de que fue una GPU de 6 GB (aunque con variante de 3 GB).

Respecto a NVIDIA, veíamos una mejora en el proceso de fabricación FinFET de 14 y 16 nm para reducir el consumo de energía y mejorar la optimización del tamaño de la GPU. Para esta tarea se contó con TSMC, y el objetivo era eliminar el cuello de botella junto con la reducción de consumo.

A partir de este año, NVIDIA apostó por la IA en su plataforma HPC para empresas (centros de datos, servidores, etc.). En generaciones anteriores, vimos que había una gran diferencia entre Fermi y las soluciones HPC, pero con Pascal la GTX 1080 no eran mucho menos potente de lo que veíamos en el ámbito profesional.

Para que os hagáis una idea, la GTX 1080 venía con 2560 CUDA Cores y, por aquel entonces, tenía motores PolyMorph. Vimos un gran salto en esta GPU, la cual venía con 8 GB GDDR5X, llegando a tener 11 GB GDDR5X la variante Ti. Una de las grandes novedades fue la inclusión del GDDR5X para abordar el problema de ancho de banda, ya que las GTX 900 venían con GDDR5.

No te pierdas nuestra entrada sobre la Historia de NVIDIA

Básicamente, NVIDIA sacaba unas GPUs cuyo aumento de rendimiento oscilaba entre un 60-70% respecto a Maxwell. Gran parte de este logro se debe a todo lo comentado, incluyendo un aumento de frecuencia en las GPUs Pascal.

¿Qué ofrecía AMD para parar a NVIDIA? AMD lanzó las Radeon RX 400, también llamada la familia Polaris y que venían con un proceso de 14 nm desarrollado por Samsung y GlobalFoundries. Gran fama tuvo la RX 480 de 8 GB GDDR5, que fue un modelo que se encasilló en la gama media-alta, compitiendo con la GTX 1060 y GTX 1070.

El equipo rojo atacó la calidad-precio y fue una lucha bonita entre AMD vs NVIDIA, ya que su RX 480 de 8 GB costaba unos 250€. También lanzaron una versión de 4 GB que se posicionaba por los 180-220€, la cual fue muy vendida por 2016.

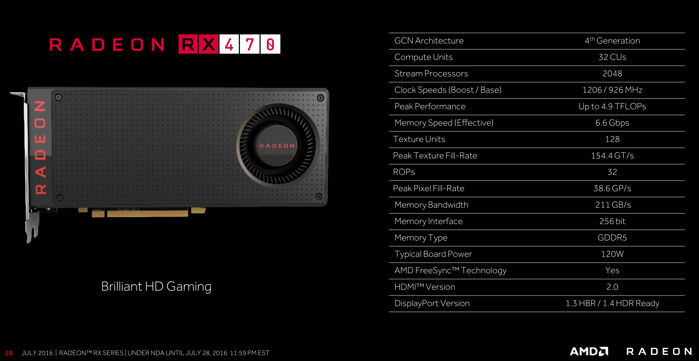

La gama baja fue el punto fuerte de Polaris, con las RX 460 a un precio tirado por los suelos y una RX 470 que era menos potente que el buque insignia, pero que ofrecía un rendimiento muy interesante. Decimos esto porque también tuvo sus variantes de 4 y 8 GB, aunque las de 4 GB fueron más vendidas por razones lógicas.

Fue Raja Koduri (ahora es el jefe en Intel) quien estuvo al frente del proyecto Polaris, haciendo énfasis en la máxima potencia al menor consumo, por lo que pusieron mucho ímpetu en el proceso de fabricación. Se adaptaron a las necesidades del mercado, con puertos HDMI 2.0a, DisplayPort 1.3 y codificador/descodificador h.265.

Añadieron una caché L2, un controlador de memoria, motores de computación, procesador de comandos, GCN de 4ª generación (Graphics Core Next), etc. AMD era una empresa que había dado mucha importancia al hardware, pero fue con las RX 400 cuando empezaron a trabajar muy fuerte en arquitecturas.

Estábamos en una era en la que el HDR se empezaba a implementar y a compatibilizar en tarjetas gráficas, había configuraciones multi-gpu (AMD Crossfire en este caso), y la realidad virtual estaba creciendo.

Eso sí, ninguna Polaris pudo competir de tú a tú con las GTX 1080, mucho menos con la TITAN GTX. En aquel momento, AMD solo se enfocaba en la gama media porque los costes de convencer y traer un producto de gama alta en GPUs… era muy arriesgado porque NVIDIA dominaba dicho terreno.

Contraataque con las RX 500

Para reforzar su catálogo y propuesta de Polaris, AMD decidió lanzar en todo 2017 tarjetas gráficas basadas en Polaris, pero ligeramente más potentes: las RX 500. No dejaron de ser un refrito por estar basadas en las RX 400,

Se les dice Polaris Refresh porque eran GPUs basadas en dicha arquitectura, pero con un proceso de 12 nm y con mejoras en el hardware. Venían con GCN de 4ª generación y con el mismo proceso de Samsung/Global Foundries de 14 nm. Las más compradas fueron las RX 580 y RX 570, las cuales no mejoraban mucho lo que ofrecían sus antecesoras.

Ligeramente por encima, teníamos la RX 590, pero fue presentada en 2018 como último coletazo de Polaris, trayendo como novedad más núcleos y un proceso de 12 nm por parte de Samsung y GlobalFoundries.

No fueron pequeños los esfuerzos de AMD, pero insuficientes para ganar a la propuesta de NVIDIA porque el modelo más potente (RX 590) podía competir ligeramente con las GTX 1070/1070 Ti. Decimos ligeramente porque no podían hacer mucho.

Todo al rojo: AMD RX Vega 56 y 64 para la gama alta

Mientras que en 2016-2017, NVIDIA iba con sus GTX 1000, AMD decidió dar un paso a la gama alta y presentar las Radeon RX Vega. Las primeras GPUs fueron las RX Vega 56 y RX Vega 64, ambas fueron las primeras tarjetas gráficas de escritorio de la historia en incorporar memoria HBM2.

La teoría decía que la memoria HBM2 era muchísimo más rápida que la GDDR5, GDDR5X e, incluso, que la GDDR6. Sin embargo, no vimos esto trasladado a la práctica: seguían siendo inferiores a las GTX 1080 y 1080 Ti. Es más, la Radeon RX Vega 64 no era nada barata: costaba más de 500€, y no fue un éxito en ventas.

HBM2 es más rápido que GDDR6, pero lo cierto es que una buena arquitectura es el pilar de un buen rendimiento. En este sentido, AMD no estaba al nivel de NVIDIA, de ahí que el equipo verde ganase al equipo rojo con GDDR5 y GDDR5X: Pascal era brillante.

Respecto a la arquitectura Vega, estaba pensada para trabajar con conjuntos de datos muy grandes, lo que era ideal para ámbitos empresariales. Otra de las claves fue su subida en la frecuencia, pero hubo un problema: se recomendaba 750 W de fuente de alimentación en la RX Vega 64.

Consumían muchísima energía y no valían lo suficiente para jugar a videojuegos, algo que fue muy criticado para AMD. Su rendimiento se situaba entre la GTX 1070 y GTX 1080, pero no lograba superar a NVIDIA.

Este era el proyecto de gama alta de AMD: arriesgaron y fallaron.

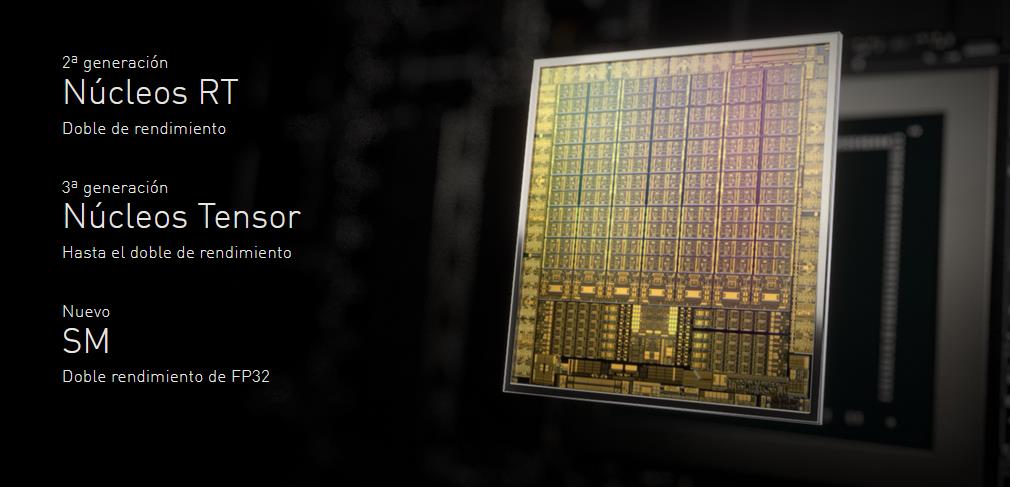

2018-2019, Turing vs RDNA

Turing se recuerda como una de las obras de arquitectura gráfica más importantes de la última década, trayendo conceptos como Inteligencia Artificial, Deep Learning y el famoso Ray Tracing. En este sentido, NVIDIA estaba a años luz de AMD, y es que tardaron 7 años en desarrollar el Ray Tracing en colaboración varias universidades del mundo (la de Barcelona, entre ellas).

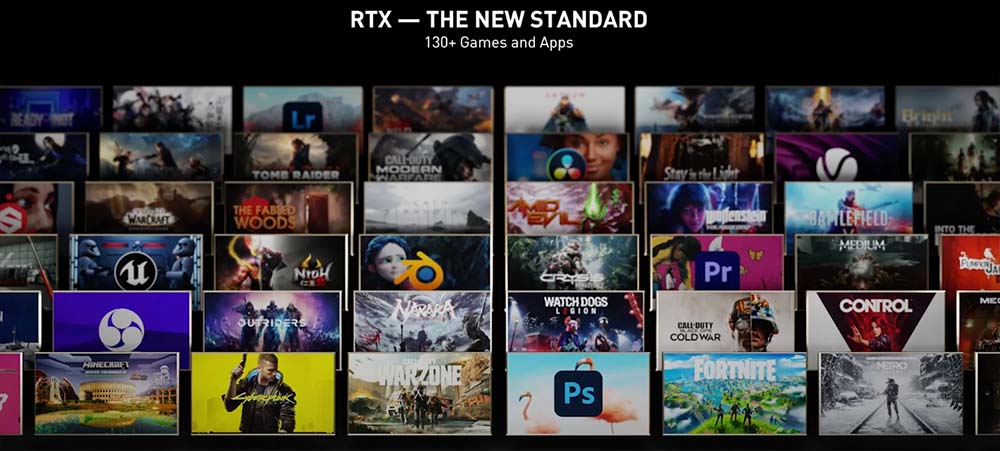

NVIDIA presenta una arquitectura marcada por un aumento de los CUDA Cores, pero con nuevas piezas hardware: Tensor Cores y RT Cores. Los primeros estaban enfocados en la realización de tareas relacionadas con la IA o el Deep Learning, siendo vitales para el DLSS. Los segundos eran componentes enfocados para renderizar y calcular los rayos y sus rebotes; es decir, todas las operaciones que tuviesen que ver con el Ray Tracing.

Nacen así las RTX 2000, liderando en gaming la RTX 2080 Ti, así como la RTX Titan en plataformas súper exigentes. Si la GTX 1080 nos parecía brutal, la RTX 2080 le dejaba enterrada en cenizas con un aumento de rendimiento del 125%.

Las GTX 1000 fueron las últimas tarjetas gráficas «asequibles», ya que las RTX 2000 vinieron con un gran aumento de precio: la RTX 2080 Ti costaba más de 1200€. A pesar del gran funcionamiento del DLSS, NVIDIA tuvo serios problemas con el Ray Tracing:

- Las GPUs no eran lo suficientemente potentes para manejar este escenario por encima de los 60 FPS cuando subíamos 1440p o 4K.

- Muy poco catálogo de juegos con soporte Ray Tracing, ya que los desarrolladores tenían que trabajar en él.

- DLSS funcionaba para 1440p en adelante, aunque llegaría su actualización y podría ser usado en 1080p.

- Aunque todas las RTX 2000 llevaban Ray Tracing, solo se podía esperar una experiencia «grata» a partir de la RTX 2060 Super.

- La RTX 2060 no se vendió tanto como se esperaba, siendo la GTX 1060 mucho más usada en Steam.

AMD criticaba el Ray Tracing, asegurando que las tecnologías Anti-Aliasing eran mejores por aquel momento. Más adelante, veréis que rectificó su opinión o postura con toda su arquitectura RDNA2.

Para reforzar su propuesta, NVIDIA lanzaría más tarde los modelos vitaminados: RTX 2060 Super, 2070 Super y 2080 Super. Curiosamente, vimos 3 variantes en la gama alta: RTX 2080, 2080 Super y 2080 Ti. La más vendida fue la RTX 2080 Super, y no os creáis que la RTX 2080 fue un éxito rotundo, sino que mucha gente decidió apostar por la RTX 2070 Super, la cual sí fue un trato justo.

¿Qué hizo AMD? Aguantar con Polaris y esperar hasta 2019 para presentar sus tarjetas gráficas RDNA, también reconocidas como Navi. Efectivamente, hacemos referencia a las RX 5000, las cuales venían sin Ray Tracing, pero su rendimiento fue espectacular.

Las primeras RX 5000 fueron las RX 5700 y 5700 XT, llegadas en julio de 2017 a unos precios de mercado que oscilaban entre los 350 y 550€. Mientras que la primera superaba a la RTX 2060 y ligeramente a la RTX 2060 Super, la segunda igualaba e, incluso, superaba a la RTX 2070.

El problema fue que vinieron con un problema de optimización de drivers, provocándose muchos crasheos en videojuegos. Una vez arreglado, y sin Ray Tracing de por medio, las RX 5700 fueron las más vendidas por parte de AMD; incluso los mineros las querían por su rentabilidad/consumo.

Fue la RX 5700 XT el modelo más vendido, siendo un auténtico quebradero de cabeza para NVIDIA, la cual bajó el precio de la RTX 2060 a 299€. Más tarde, en octubre y diciembre, llegaron las RX 5500 y RX 5500 XT respectivamente. El objetivo era ganar a las GTX 1650 y 1050, un objetivo que consiguieron, pero no por una ventaja aplastante.

RDNA sentó varias bases importantes que le hacían muy competitiva frente a Turing:

- Proceso de 7 nm con un consumo bastante ligero.

- Mejora en el IPC.

- Jerarquía de caché multi-level.

- Memoria GDDR6 con 8 GB en las RX 5700 y en una variante de la RX 5500 XT.

- Se amplía el ancho de los SIMD de 16 ranuras a 32 (SIMD32).

- Compatibilidad con FP16.

- Sombreador primitivo heredado de Vega, que sufrió ciertos cambios para hacerlo más útil de cara al rendimiento.

- Soporte PCI-Express 4.0.

- Compatible con DisplayPort 1.4 para jugar a 4K y 144 Hz.

En nuestra opinión, las RX 5600 XT llegaron tarde (2020) para competir contra las RTX 2060. No lo hicieron nada mal, pero, salvo que tuvieses el Ray Tracing en mente, la gente prefería el modelo de AMD porque las podías comprar por unos 260-270€. Todo esto sin llegar el COVID-19, por supuesto.

Terminando con las conclusiones de esta etapa, AMD asestó un golpe muy fuerte en la gama media de Turing, pero seguían sin Ray Tracing. Finalmente, el equipo rojo se rendiría a esta tecnología, pero tarde: NVIDIA ya tenía una arquitectura preparada para destrozar a su enemigo en dicho escenario. Llega el AMD vs NVIDIA de verdad.

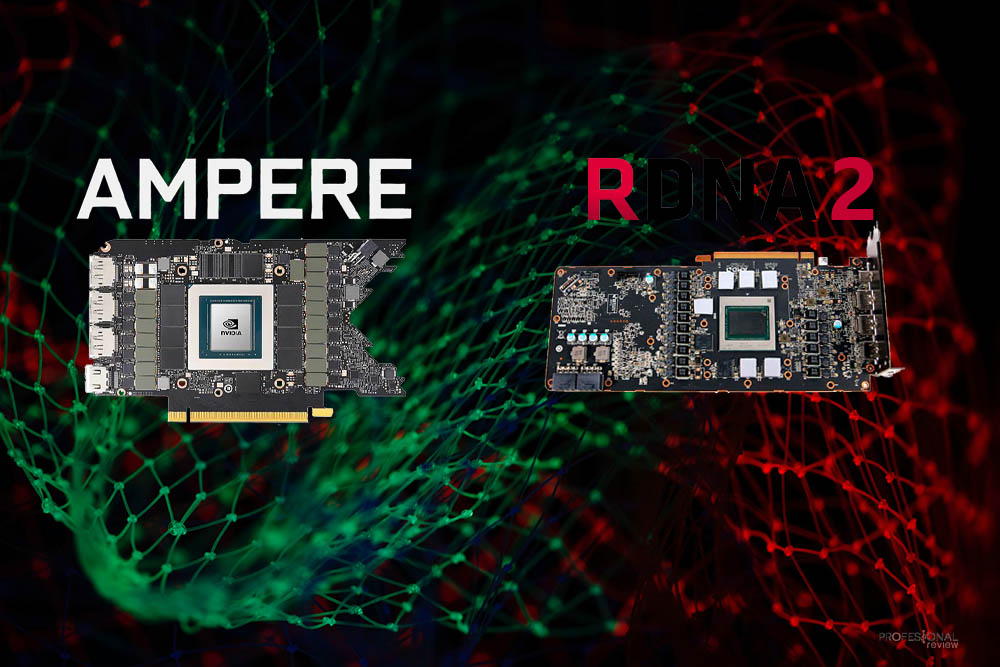

2020, RDNA 2 y Ampere

Brota el COVID-19 en marzo de 2020, pero las presentaciones de AMD vs NVIDIA todavía estaban pendientes: llegaba la guerra de verdad. Decimos esto porque habían desafíos por delante:

- Escasez de componentes.

- Fábricas paradas por la pandemia.

- Auge de minería por la subida de Ethereum y otras criptomonedas.

- Lanzamientos de muchas GPUs.

- Cuello de botella en la producción de semiconductores: Samsung y TSMC no daban a basto ante tantos pedidos.

En definitiva, 2020 fue un caos en todos los aspectos: muertes, contagios, UCIs llenas, y el sector de la tecnología muy tocado. Dejando el resumen del año a parte, vimos las presentaciones de AMD vs NVIDIA en los últimos meses del año.

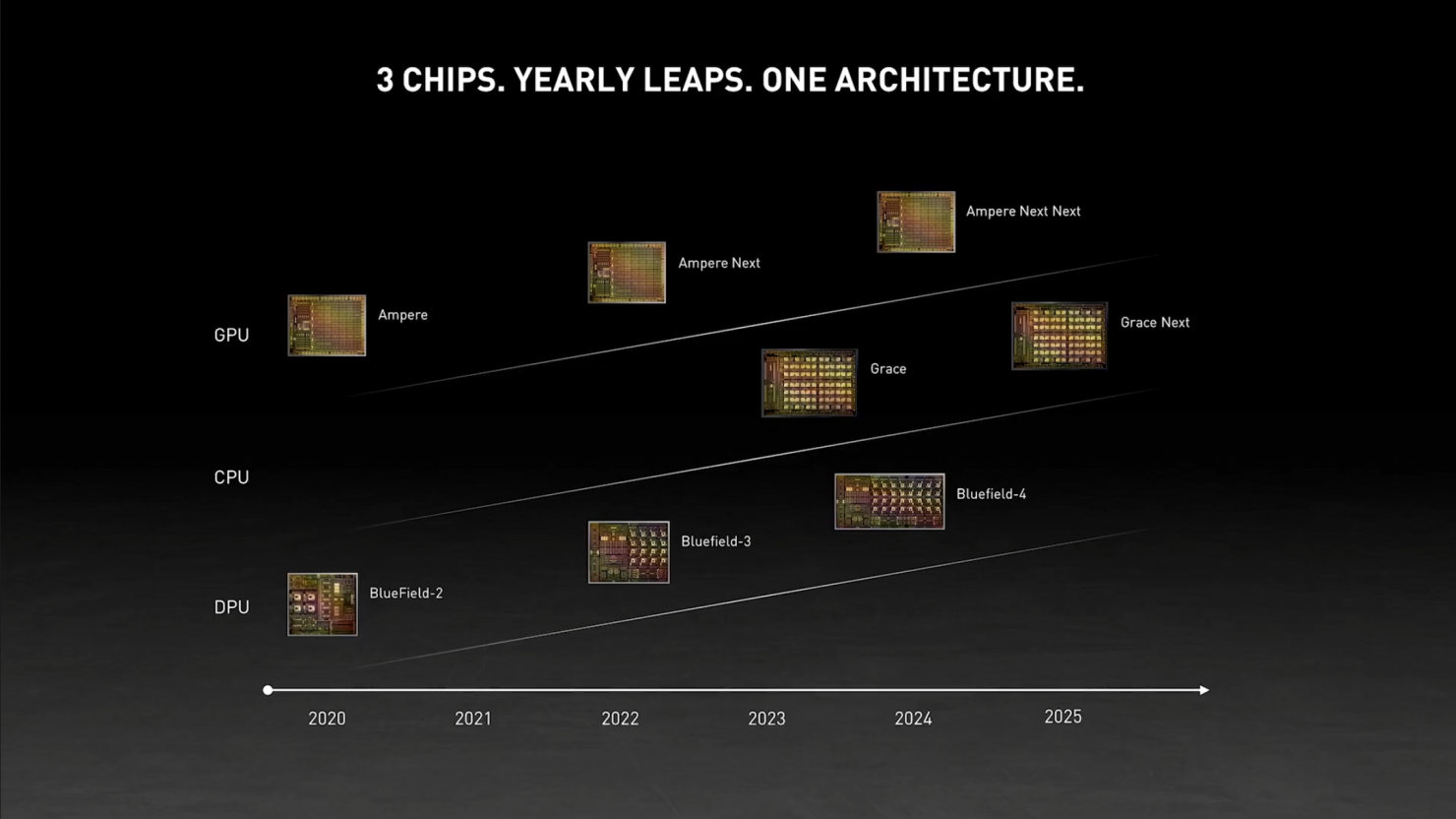

Primero, supimos de Ampere por el GTC de 2020 de NVIDIA, un evento dirigido a profesionales y empresas. Desde Pascal, vemos que NVIDIA comparte arquitecturas con sus gamas profesionales, a las cuales da más prioridad porque les genera más ingresos (según los balances publicados por la marca).

Así que, la gama GeForce se estrenó con las RTX 3090 y RTX 3080, presentadas conjuntamente, pero salieron en fechas distintas: 17 de septiembre la RTX 3080 y 24 de septiembre la RTX 3090. Las novedades fueron:

- Más CUDA Cores, RT y Tensor Cores.

- Más consumo.

- Memoria GDDR6X.

- Proceso de 8 nm por Samsung.

- Nuevo diseño en el disipador de los Founders Edition (ventilador a cada lado).

- 80% más rendimiento que las RTX 2080 Super.

- NVIDIA Reflex.

- Vuelven los modelos Ti.

- RTX 3060 muy justa, siendo superada por la RTX 2070 Super en algunos títulos Ray Tracing.

- NVLink de 3ª generación.

- Adiós a SLI.

- DLSS para herramientas profesionales.

- Mejoras en NVIDIA Broadcast.

En términos generales, vimos un rendimiento Ray Tracing espectacular, haciendo viable dicha tecnología en QHD y 4K. Sin Ray Tracing, la lucha AMD vs NVIDIA se ponía súper interesante, pero esto lo comentaremos más a fondo abajo.

RDNA2 fue la sorpresa de 2020: una arquitectura gráfica multiplataforma que funcionaba en escritorio, portátiles y en las consolas PS5 y Xbox Series. Una apuesta muy ambiciosa por parte de AMD, que ofrecía Ray Tracing y GPUs para todas las gamas.

Era un golpe en la mesa en toda regla, y es que las RX 6000 trajeron todo esto:

- Presencia en todas las gamas desde la RX 6500 XT hasta la RX 6900 XT.

- Proceso de 7 nm fabricado por TSMC.

- Soporte en Ray Tracing a través de los Ray Accelerators y del DirectX Ray Tracing.

- Infinity Cache en todas las gamas.

- GDDR6 de alta velocidad, viendo frecuencias súper altas.

- Smart Access Memory, una tecnología basada en ReBar que obligó a NVIDIA a sacar su análoga Resizable BAR. Se necesita placa, CPU y GPU AMD.

- Rage Mode, que es un ajuste de perfil de overclock muy interesante y rápido de configurar.

- FidelityFX Super Resolution, la rival del DLSS, pero que fue lanzada definitivamente en 2021.

- Modelos de gama alta con 16 GB GDDR6.

Veíamos que, sin Ray Tracing, ganaban a muchas NVIDIA RTX 3000, pero en Ray Tracing se quedaban muy atrás si no usaban FSR. La RTX 3090 era la dominante en 4K, seguida por las RX 6900 XT y RTX 3080 Ti, pero por considerando todo: la mejor GPU fue la RTX 3080. Ofrecía un overrall brutal e inigualable en términos de calidad-precio, por lo que siempre fue la ganadora de casi todas las comparativas.

Vimos que la memoria GDDR6X (exclusiva entre Micron y NVIDIA) ofrecía la posibilidad de hacer el doble que GDDR6 a menos frecuencia, algo que se traducía en más FPS sin duda. Todo este abanico de novedades se vio ensombrecido por 2 cosas:

- Escasez de tarjetas gráficas.

- Auge de minería.

Los precios de mercado doblaban y triplicaban el precio oficial de salida fijado por AMD y NVIDIA. Solo unos pocos afortunados consiguieron una unidad a un precio oficial, pagando la mayoría un sobreprecio fuera de toda lógica o razón.

Si con la crisis del Bitcoin de 2017-2018 nos quedamos boquiabiertos, lo de 2020-2021 no tiene nombre. Literalmente, NVIDIA lanzó sus CMP, una serie de GPUs enfocadas plenamente para minería, basándose la mayoría en arquitectura Turing.

Desesperada por la situación, decidió limitar las capacidades de minería de sus RTX 3000 a través de NVIDIA LHR: vía software y hardware (silicio). La inestabilidad en el mercado fue brutal, todo ello viendo granjas de minería con RTX 3000 de gama alta funcionando 24/7.

Respecto a AMD, no se hizo ningún movimiento respecto a ello: fueron las que más escasez sufrieron y las que más sobreprecio llevaban.

2022, RDNA 3 vs Ada Lovelace (RX 7000 vs RTX 4000)

Dejamos este apartado pendiente de actualización, ya que las RX 7000 y las RTX 4000 no han salido todavía al mercado en el momento de redactar este artículo. Sabemos que lo harán en 2022, concretamente a finales del año.

Las posibles novedades (según los rumores) que veremos serán las siguientes:

- AMD:

-

- Presentación entre octubre y diciembre.

- Arquitectura RDNA3.

- Navi 33, 32 y 31 como primeras GPUs.

- Posible proceso de 5 nm.

- Módulo GCD y MCD presentes.

- Navi 31 con más de 15.000 Stream Processors, Navi 32 con más de 10.000 y Navi 33 con unos 5.000.

- Podríamos ver cachés de hasta 512 MB.

- Se espera un diseño MCM.

-

- NVIDIA:

-

- Trabajan en Ada Lovelace para escritorio y Hopper para profesionales.

- También se espera un proceso de 5 nm.

- Su presentación podría estar entre agosto y septiembre.

- Arquitectura MCM pospuesta para 2023-2024.

- Casi 20.000 núcleos CUDA (casi el doble que la RTX 3090).

- Se baraja con unos aumentos de rendimiento de hasta el 78%, lo que es una bestialidad.

- El consumo será una barbaridad: necesitaríamos 1200W para alimentar GPUs de gama alta.

- La GPU AD102 será el buque insignia y se espera 24 GB GDDR6X en la RTX 4090.

-

Recopilación de comparativas y rendimiento AMD vs NVIDIA

En Profesional Review hemos trabajado duro para todos los duelos NVIDIA vs AMD, haciendo comparativas en todas las gamas existentes. Por ello, os dejamos todas las comparativas aquí, como el resumen que extraemos de ellas.

Pulsad CTRL + F para buscar la que más os interese.

- GTX 1650 vs RX 570

- GTX 1650 vs RX 470

- GTX 1660 Ti vs GTX 1060

- GTX 1660 Super vs RTX 2060

- GTX 1660 Ti vs RTX 2060

- GTX 1660 vs GTX 1660 Super vs GTX 1660 Ti

- GTX 1060 vs GTX 1060 3 GB

- RX 480 vs GTX 1060

- RX 580 vs RX 570 vs RX 480 vs GTX 1060

- RTX 2060 vs GTX 1060 vs GTX 1070 vs GTX 1080

- GTX 1070 vs GTX 1070 Ti vs GTX 1080

- RTX 2080 vs GTX 1080 Ti

- GTX 1080 Ti vs GTX 1080

- RX Vega 64 vs GTX 1080

- Radeon VII vs RTX 2080 vs GTX 1080 Ti vs RTX 2070

- RX 5500 XT vs 6500 XT

- RX 5500 XT vs GTX 1650 Super

- RTX 2060 vs 2070 vs 2080 vs 2080 Ti

- RTX 3060 vs 2060 Super vs 2060

- RX 5600 XT vs GTX 1660 Ti vs RTX 2060

- RTX 2060 Super vs RX 5700

- RTX 2060 Max-Q vs RTX 2070

- RTX 2070 Super vs GTX 1080 Ti

- Radeon VII vs RTX 2080 vs GTX 1080 Ti vs RTX 2070

- RTX 2070 Super vs RX 5700 XT

- RTX 2080 Super vs RTX 2070 Super

- RTX 3000 vs 2000

- RTX 2080 Super vs RTX 3080

- RTX 3080 vs 2080 Ti

- RTX 2080 Super vs RX 5700 XT

- RTX 2080 vs RTX 2080 Ti

- RTX 3000

- RX 6000

- RX 6000 vs RTX 3000

- RTX 3060 vs RTX 3060 Ti

- RX 6600 XT vs RTX 3060 vs 3060 Ti

- RTX 3060 vs 2060 Super vs 2060

- RX 6700 XT vs RTX 3070 vs 3060 Ti

- RX 6800 XT vs RTX 3080 vs RTX 3070

- RX 6900 XT vs RTX 3090 vs 3080 Ti

- RX 6900 XT vs RTX 3090

- RX 6900 XT vs RTX 3080

De todas las comparativas que os hemos expuesto, consideramos muy útiles revisar las que os hemos destacado en negrita porque nos parecen la más globales y amplias. Conforme fueron salieron los modelos, trabajamos en traer comparativas más específicas.

A modo de resumen, podemos concluir lo siguiente:

- Las RTX 2000 fueron las primeras tarjetas gráficas con Ray Tracing del mercado, pero su rendimiento ha quedado en una anécdota tras salir las RTX 3000.

- NVIDIA es mucho más potente que AMD en Ray Tracing.

- Las RTX 2060 Super y RTX 2070 Super fueron los modelos más aclamados, junto con la RTX 2080 Super. Fue un acierto por parte de NVIDIA lanzar estos modelos vitaminados que tenían una relación rendimiento-precio bastante buena.

- Las RX 6000 dan la cara a partir de las RX 6700 XT, siendo las RX 6600 XT peores que las RTX 3060 o 3060 Ti, como las RX 6500 XT no plantan cara a las RTX 3050.

- Para 2K y 4K, recomendamos las RX 6800, 6800 XT y 6900 XT por parte de AMD, así como las RTX 3070 Ti, 3080 y 3080 Ti por parte de NVIDIA. Dejamos la RTX 3090 para los más entusiastas, profesionales y apasionados de la marca porque es prohibitiva.

- Los modelos que más han convencido de las RTX 3000 son la RTX 3060 Ti, la RTX 3080 y 3080 Ti por ser la GPU más rápida en gaming.

- Para los interesados en generaciones anteriores, las RX 5500 XT no rendían mal, pero tampoco eran «un chollo», siendo más interesantes las RX 5600 XT de 6 GB y las RX 5700 XT como los mejores modelos de RDNA. Si buscas jugar a 1080p o 1440p sin Ray Tracing, nos parecen dos GPUs excelentes.

- Respecto a la RTX 3060, dejó un muy buen sabor de boca, aunque en Ray Tracing pierde bastante rendimiento.

Overclock

Conforme han ido pasando las generaciones de tarjetas gráficas, hemos visto tarjetas gráficas más calientes y con más dificultades de overclock. Igualmente, hay modelos muy interesantes para este fin, especialmente si elegimos una variante custom con buena refrigeración.

Por ejemplo, las últimas generaciones de RDNA2 y Ampere ya venían bastante apretadas de serie, por lo que se podía subir la frecuencia algo, pero no demasiado. Incluso, AMD lanzó un modelo limitado con refrigeración líquida de la RX 6900 XT que completaba el naming con «LC» (Liquid Cooling). Sin embargo, tampoco era un salto importante y el precio era prohibitivo (como si no lo fuese ya el modelo normal).

Desde la serie GTX 700 el voltaje está bloqueado, pudiéndose desbloquear en algunos casos por la VBIOS, pero no merecería mucho la pena. Tirando de hemeroteca podemos decir lo siguiente:

- Las RX 400 y RX 500 de AMD sí que ofrecieron posibilidades de overclock, incluso habían modelos interesantes como la Nitro con memoria de SK Hynix que daba ciertas posibilidades de subir el Memory Clock. De hecho, salieron muchas guías para estas generaciones.

- Las NVIDIA Pascal (GTX 1000) venían con módulos de memoria Samsung que se podían subir fácilmente 400-600 MHz, pero otros vinieron con módulos Micron cuyas capacidades de overclock eran menores (100-300 MHz). Veíamos subidas de hasta 2088 MHz en las GTX 1060 en el Core Clock, como 9.4 GHz memory clock fácilmente.

- A pesar de los primeros fallos en las RX 5700 XT, la diferencia estaba en el silicio que te tocase. Podías subir el power limit hasta un 70% con Softmods, así como llegar a 2100 MHz en el Core Clock. También hubo modelos con Micron y Samsung GDDR6, siendo muy parejos en términos de overclock.

- En la NVIDIA RTX 3080 se vio que estaba apretada de casa, por lo que se podían ver subidas de 145 MHz en el Core Clock o 750 MHz en el Memory Clock, todo ello sin merecer mucho la pena.

Al final, ha dependido mucho de qué silicio te tocase en la GPU, la generación que hayas usado o la marca, siendo AMD mucho más favorable de cara al overclocking. En la era de las RX 400 y 500 habían muchos PCs con éstas overclockeadas porque se les sacaba mucho rendimiento, y eso que no consumían poco. Se puede decir que el AMD vs NVIDIA en overclock se lo lleva el equipo rojo.

La llegada del Ray Tracing, ¿cuál es mejor?

No hay que olvidar que el Ray Tracing llega con NVIDIA Turing y las GeForce RTX 2000, pero no lo hace de forma contundente: todavía no había suficiente potencia hardware para mover juegos en Ray Tracing.

El RTX de NVIDIA era un bebé que todavía tenía que crecer, ser optimizado, ser desarrollado y trabajado por las desarrolladoras y mucho más. El equipo verde no se rindió cuando casi nadie apostaba por esta tecnología: ni AMD, ni desarrolladoras.

Con mucha crítica detrás por darle «demasiado bombo», NVIDIA empezó a cerrar acuerdos con desarrolladoras y llegaron los primeros juegos: Battlefield V, Wolfenstein Youngblood, Tomb Raider, Metro Exodus, etc. El Battlefield V era un juego poco optimizado que consumía muchos recursos, por lo que sigue siendo un título que está en nuestro banco de pruebas como «la prueba de fuego».

Resumiendo, las RTX 2000 lo tenían muy complicado para dar más de 60 FPS con todo Ultra y Ray Tracing activado, siendo clave para ello NVIDIA DLSS:

- La RTX 2060 fue la GPU de menor gama que manejaba Ray Tracing, pero la experiencia que ofrecía era demasiado justa. Así que, si querías una GPU para jugar en Ray Tracing, tenías que partir de la RTX 2060 Super.

- Las RX 5000 (RDNA) venían sin Ray Tracing, lo que considero que fue un fallo por parte de AMD.

- Con la llegada de Ampere, el Ray Tracing se ha hecho una tecnología más que viable en las RTX 3000.

- AMD ha incorporado Ray Tracing en todo RDNA2: GPUs y los SoCs de las consolas PS5 y Xbox Series.

- El Ray Tracing inicial de las RX 6000 fue nefasto, algo que se ha mejorado con FidelityFX Super Resolution, pero sigue estando por debajo de NVIDIA tras llegar una generación tarde.

- Destacar como modelo muy interesante en relación calidad-precio la RTX 3070 Ti, la cual se comporta fenomenalmente en Ray Tracing a 1440p, dando más de 60 FPS de promedio.

Este escenario es muy exigente para las tarjetas gráficas, pero lo que está claro es que es el futuro porque cada vez apuestan más empresas por él. Ya no solo en escritorio, sino en consolas, existiendo la posibilidad de que la futura Nintendo Switch equipada con un SoC NVIDIA venga con Ray Tracing y DLSS.

Indudablemente, el NVIDIA vs AMD se lo lleva el equipo verde.

Disponibilidad y soporte ¿Mejor AMD o Nvidia?

Sobre este tema podríamos hacer un artículo a parte porque el mercado de las tarjetas gráficas ha sido una montaña rusa en la última década. Centrándonos en la disponibilidad y soporte, hay que hacer referencia a 2 períodos en los que AMD y NVIDIA han visto tambalear su disponibilidad.

- Auge del Bitcoin y las criptomonedas (2017). El primer coletazo vino con las NVIDIA Pascal y AMD Polaris en el mercado, viendo GTX 1060 de 3 GB GDDR5 por más de 350€. Se empezaron a crear granjas de minería para extraer todo el bitcoin posible y venderlo a un precio que hoy es una locura. Esto provocó una escasez tremenda en el mercado de tarjetas gráficas, subiendo el precio de producto una barbaridad. Dicho esto, fue temporal, y todo volvió a la normalidad con las RTX 2000 y RX 5000.

- COVID-19 en 2020-2021. Estamos escribiendo esta entrada en 2022, por lo que no sabemos si se extenderá la escasez a 3 años, siendo la etapa más crítica de la historia de la disponibilidad de tarjetas gráficas. Esta etapa es peor que la anteriormente descrita, debido a que no solo no hay producto, sino que el sobreprecio es incluso más insano: GPUs de gama baja por 300-400€, gama media por 500-800€, gama alta por más de 1000€. No obstante, AMD ha sido más crítica, lanzando modelos que ni se han dejado ver por el mercado.

El AMD vs NVIDIA en disponibilidad se lo lleva el equipo verde, pero por los pelos porque no ha ofrecido una disponibilidad tremenda.

Pasando al aspecto del soporte, ambas marcas han dado un soporte de drivers y controladores bastante longevo a generaciones bastante más antiguas. Por ejemplo, NVIDIA ha abandonado el soporte de Kepler en 2021, siendo unas tarjetas gráficas que se lanzaron en 2012. Prácticamente, nadie tenía GPUs de esta generación, por lo que no nos parece una mala gestión.

AMD también es muy benévola con los drivers y generaciones anteriores, así que nada más que objetar en este aspecto.

Cosa diferente es el soporte de tecnologías en GPUs anteriores, y AMD es mucho más abierta de mente o comercialmente hablando. FreeSync, FidelityFX Super Resolution, Radeon Super Resolution; la mayoría de sus soluciones software son retrocompatibles o están en código abierto. NVIDIA es más cerrada de mente para eso, cosa respetable, pero también valorable en esta situación.

Podríamos decir que la batalla del soporte entre AMD vs NVIDIA podría decantarse para el equipo rojo, pero no queda claro del todo.

Precio de las AMD vs Nvidia

Hemos recopilado los precios de salida que se han ido fijando por ambas marcas en sus respectivos lanzamientos para hacer un AMD vs NVIDIA a la altura en tarjetas gráficas. Recalcar que hemos incluido las GTX 1660 en Pascal por cuestiones de rendimiento-precio, ya que pertenecen a Turing.

|

Pascal |

Polaris y GCN (Vega) |

| GTX 1050 ($110) |

RX 460 2 GB ($109) |

|

GTX 1050 TI ($140) |

RX 550 ($79) |

| GTX 1060 3 GB ($200) |

RX 460 4 GB ($139) |

|

GTX 1060 6 GB ($250) |

RX 560 ($99) RX 570 ($169) RX 470 ($179) RX 480 4 GB ($199) |

| GTX 1660 ($219) |

RX 480 8 GB ($239) RX 580 4 GB ($199) RX 580 8 GB ($229) |

|

GTX 1660 Super ($229) |

RX 590 8 GB ($279) |

|

GTX 1660 Ti ($279) |

|

| GTX 1070 ($379) |

RX Vega 56 ($399) |

|

GTX 1070 Ti ($449) |

RX Vega 64 ($499) Radeon VII ($699) |

|

GTX 1080 ($599) |

|

|

GTX 1080 Ti ($700) |

Tenemos que decir que la gama baja de AMD ganó por relación calidad-precio, pero la gama media y alta de NVIDIA fueron más potentes que las del equipo rojo. Vimos 2 arquitecturas contemporáneas en AMD: Polaris y GCN, pero lo cierto es que la gama alta fue GCN.

Las RX Vega surgieron para competir con las GTX 1070 a 1080 y fueron un fracaso, ya que la RX Vega 64 costaba más que la Ti y no rendía igual de bien. Vimos ciertos juegos parejos entre la GTX 1070 y RX Vega 56, pero lo cierto es que en la mayoría sacaba más FPS la GPU de NVIDIA. En definitiva, fue un mal negocio para AMD adentrarse en la gama alta y le vio las orejas al lobo.

|

Turing |

RDNA |

| GTX 1650 ($149) Cuidado con las versiones GDDR6 que lanzó posteriormente NVIDIA que son mucho mejores y a un mismo precio (las lanzó en 2020). |

RX 5500 XT 4 GB RX 5500 XT 8 GB |

|

RTX 2060 ($329) |

RX 5600 XT |

| RTX 2060 Super ($399) |

RX 5700 ($349) |

|

RTX 2070 ($499) |

RX 5700 XT ($399) |

|

RTX 2070 Super ($499) |

|

| RTX 2080 ($799) |

Sin competencia |

|

RTX 2080 Super ($699) |

|

|

RTX 2080 Ti ($1199) |

Pasamos a 2018-2019 (aunque en la tabla anterior habían GPUs de 2019), siendo una generación en la que NVIDIA se encontró con una arquitectura muy peleona: RDNA, aunque sin Ray Tracing. No fue tan malo sacar GPUs sin Ray Tracing por entonces porque tampoco había un soporte en videojuegos brutal, por lo que la estrategia de AMD no fue del todo desacertada.

Vimos rendimientos muy parejos, y tengo que decir que la RX 5700 XT fue el modelo calidad-precio del mercado en aquel momento: tanto para gaming, como para minería. Eso sí, las RX 5500 XT no convencían del todo y la GTX 1650 era guerrera, mostrándose pareja. La RX 5700 XT costaba 200-300€ menos que la RTX 2070 Super, una GPU fantástica de la que vimos muchos modelos. Sin Ray Tracing, la RX 5700 XT ofrecía guerra.

En la gama alta, AMD aprendió la lección y fue conservadora: no lanzó ningún modelo y las RTX 2080 lideraron en solitario.

|

Ampere |

RDNA2 |

|

RTX 3050 ($249) |

RX 6500 XT ($199) |

| RTX 3060 ($329) |

RX 6600 XT ($379) |

|

RTX 3060 Ti ($399) |

RX 6700 XT ($479) |

| RTX 3070 ($499) |

RX 6800 ($579) |

|

RTX 3070 Ti ($599) |

RX 6800 XT ($649) |

|

RTX 3080 ($699) |

|

|

RTX 3080 Ti ($1199) |

RX 6900 XT ($999) |

|

RTX 3090 ($1499) |

De todas las generaciones que hemos visto, esta es nuestra favorita por lo ajustadas que estuvieron las comparativas entre ambas. Al contrario que su historia, el AMD vs NVIDIA estaba ahora en las gamas medias y altas, no en las bajas.

Es más, la RTX 3050 ganó por goleada a la RX 6500 XT, así como la RTX 3060 era superior a la RX 6600 XT. Sin embargo, la cosa se ponía interesante en las gamas superiores: la RX 6700 XT fue buen producto, pero la RX 6800 sorprendió a muchos. A pesar de esto, había un problema: el precio de mercado doblaba al oficial por culpa de la escasez.

Además, los precios de AMD eran superiores a los de NVIDIA sin convencer en absoluto en los videojuegos, por no hablar de que el Ray Tracing de NVIDIA fue demoledor.

El resumen de AMD vs NVIDIA en precio sería el siguiente:

- Polaris fue mucho más barata en gamas bajas y medias, siendo más interesante.

- RDNA fue más interesante en gamas bajas y medias.

- Ampere era más barata, tenían más modelos en stock y daban más rendimiento.

AMD Radeon: pros y contras

Enfocándonos más en cada marca, todo producto tiene su luces y sombras, por lo que podemos resumir las ventajas y desventajas en las siguientes:

|

Ventajas |

Desventajas |

| AMD FreeSync como tecnología más presente en monitores |

Le falta una tecnología equiparable a NVIDIA DLSS, siendo FSR insuficiente |

|

Precios competitivos en gamas bajas y medias |

Los precios en gamas media-alta y altas no son competitivos; de hecho son más caros que la competencia sin dar mejor rendimiento |

| Plataforma AMD aprovechable con Smart Access Memory |

Stock insuficiente y ciertos lanzamientos han sido “paper lunch” |

|

Soporte longevo de drivers |

A la cola del Ray Tracing |

| Buenas capacidades de overclock |

Teniendo mejor nodo que NVIDIA no ha sido capaz de ganarle con solidez |

|

Mucha memoria VRAM en RDNA2 |

NVIDIA: pros y contras

Hacemos lo mismo en este AMD vs NVIDIA con el equipo verde, destacando sus puntos fuertes y débiles en tarjetas gráficas.

|

Ventajas |

Desventajas |

| Máximo rendimiento en Ray Tracing, siendo la impulsora de esta tecnología |

Precios no tan competitivos, pero siempre garantizan el máximo rendimiento |

|

Competencia en todas las gamas |

Sus productos de gama baja y media pueden no ser los mejores |

| Innovación a nivel software muy potente, con DLSS, Reflex y otras tecnologías |

Tecnología cerrada y de pago, dejando poca libertad de desarrollo a la comunidad |

|

Soporte longevo en drivers |

Un overclock no tan disparatado como el de AMD |

| Buen rendimiento en overclock |

Consumo disparatado en comparación con AMD |

|

NVIDIA G-SYNC es una gran tecnología VRR, yendo algo más allá que FreeSync |

Menor stock de monitores G-SYNC, teniendo un precio superior porque los fabricantes deben pagar royalties por incorporar este chip. |

| Memoria GDDR6X y GDDR5X, trabajando mucho cada generación |

Menor oferta de ecosistema, al contrario que AMD. |

|

Liderando los aumentos de memoria VRAM (gamas altas) |

|

|

Stock algo bajo, pero más accesible que el de AMD |

Conclusiones AMD vs NVIDIA, ¿cuál es mejor?

Llegamos a las conclusiones de este AMD vs NVIDIA, así que debemos dar nuestro veredicto sobre cuál es la mejor marca de tarjetas gráficas del mercado. En nuestra opinión, ambas marcas han dado un rendimiento brillante a lo largo de los años, y eso que NVIDIA también tuvo sus batacazos en el pasado.

Fijamos la fecha de la resurección de AMD en 2019, con la llegada de las RX 5000 y una arquitectura RDNA que hizo temblar a NVIDIA. No tenían Ray Tracing, pero sin ese escenario se llevaron algún que otro susto porque se preveía lo que podía venir en el futuro.

NVIDIA mejoró mucho en Turing y Ampere, pero parte del mérito se debe a la presión ejercida por AMD durante 2018 y 2021. Igual que los Ryzen «pusieron las pilas» a los Intel Core en 2017, NVIDIA se vio forzada a mejorar mucho más su hardware porque, a nivel de arquitecturas, no le bastaba con tener una buena optimización.

Tanto fue así, que NVIDIA ha traído con Ampere unas GPUs con más memoria VRAM, equipando con 8 GB a la RTX 3050 o 12 GB a la RTX 3060. Nos encantan ambas marcas, pero tenemos que elegir una, así que nuestro veredicto va para NVIDIA. Este veredicto es susceptible de cambiar, y eso que ha sido promulgado el 27 de enero de 2022, por lo que AMD tiene una oportunidad de oro con sus RX 7000 y RDNA3 para darle la vuelta al partido.

Te recomendamos las mejores tarjetas gráficas del mercado

¿Qué opináis sobre las tarjetas gráficas AMD y Nvidia? ¿Te parece