In-/Near memory es un nuevo paradigma de la computación que llega para mejorar las prestaciones de los sistemas convencionales de memoria. Un cambio en la arquitectura para mejorar la forma en la que las unidades de procesamiento acceden a la memoria con una menor latencia para así paliar uno de los cuellos de potencia más importantes de la actualidad.

Este paradigma será cada vez más usado en los nuevos equipos que están llegando, y por eso merece que le dediquemos este artículo para dar a conocer esta nueva tecnología.

Índice de contenidos

In-memory computing

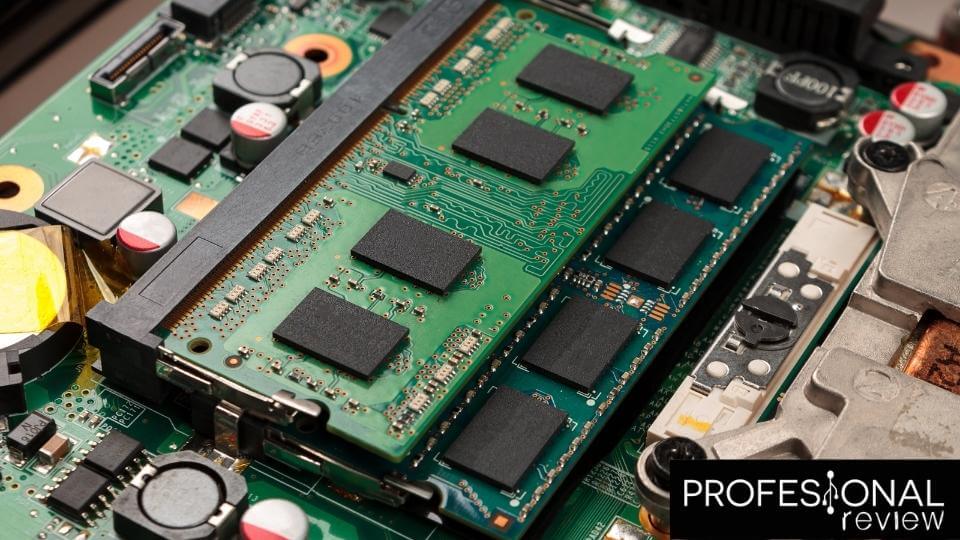

La computación en memoria (o in-memory computing) se refiere a la ejecución de cálculos informáticos completamente en la memoria del ordenador (por ejemplo, en la RAM). Este procedimiento es factible gracias al uso de software de sistemas especializado que se ejecuta en los ordenadores de un clúster. Cuando los ordenadores ponen en común sus recursos de RAM, los cálculos se ejecutan en todos ellos y se aprovechan las cantidades colectivas de RAM de todos los ordenadores. La computación en memoria es esencialmente lo mismo que el procesamiento en memoria y la computación en memoria, con la posible excepción de un pequeño matiz, ya que se refiere específicamente a los cálculos.

Si te preguntas cómo funciona la computación en memoria, aquí la veremos. Al eliminar los accesos lentos a los datos y basarse exclusivamente en los datos almacenados en la RAM, la computación en memoria aumenta el rendimiento general de los cálculos. Para aumentar el rendimiento general del cálculo y eliminar la latencia al acceder a las unidades de disco duro o SSD, el software de uno o más ordenadores gestiona el cálculo y los datos en la memoria. Varios ordenadores contribuyen al cálculo dividiéndolo en tareas más pequeñas, que se reparten a cada ordenador para que las ejecute en paralelo. La computación en memoria se realiza con frecuencia utilizando redes de datos en memoria (IMDG). Un ejemplo es Hazelcast IMDG, que permite a los usuarios realizar cálculos sofisticados en grandes conjuntos de datos a través de un clúster de servidores de hardware, manteniendo una alta velocidad.

Near-memory computing

Mientras que la innovación de los procesadores ha superado a la de las memorias en cuanto a latencia y consumo energético, lo que se conoce como el muro de la memoria, la tecnología de las memorias no lo ha hecho. Anteriormente, los arquitectos de sistemas intentaron salvar esta brecha utilizando jerarquías de memoria para mitigar algunos de los inconvenientes de las DRAM. Sin embargo, el limitado número de pines de los paquetes de memoria es incapaz de satisfacer las demandas de ancho de banda de los procesadores multinúcleo. Además, el rendimiento de los ordenadores de silicio oscuro ha llegado a un punto muerto debido a la desaparición del escalado de Dennard, la ralentización de la ley de Moore y la desaparición de los ordenadores de silicio oscuro.

La jerarquía de la memoria contemporánea incluye varios niveles de caché, memoria principal y almacenamiento. En la computación en memoria cercana, los datos se llevan a la caché desde el almacenamiento y se procesan allí mismo. Con la computación en memoria cercana, se utilizan técnicas centradas en los datos para procesarlos cerca de donde viven. En cambio, la computación en memoria cercana busca procesar los datos lo más cerca posible de su ubicación. Además de estar centrada en los datos, la computación en memoria cercana acopla las unidades de cálculo cerca de los datos para minimizar las costosas transferencias de datos, como los paquetes 3D, apilando los chips de memoria y de cálculo. El procesamiento en memoria cercana es posible apilando la lógica y la memoria en una vía de silicio (TSV) que minimiza la latencia de acceso a la memoria, el consumo de energía y el ancho de banda.

Conclusión acerca de In-/Near memory

En definitiva, la In-memory y la near-memory computing pretenden eliminar las barreras actuales de la jerarquía de memoria actual, ya que el cuello de botella entre la memoria y las unidades de procesamiento (cada vez más rápidas), es uno de los lastres del paradigma computacional actual. Por tanto, con estos cambios en la arquitectura, se podrían obtener grandes ganancias, y eso combinado con otras tecnologías como los FPGA o con los DSA, harán una informática mucho más eficiente, con menor consumo, más rendimiento, y más inteligente gracias a la incorporación de las tecnologías de IA.