Existe una gran confusión, o mejor dicho desconocimiento sobre la alta definición y qué implica que un monitor la tenga. Por eso hemos hecho nuestro mejor esfuerzo en explicar las diferencias entre DisplayHDR vs HDR10. Una especificación de rendimiento que asegura que nuestro monitor es capaz de mostrar contenido en HDR frente a un protocolo que compresión que se puede interpretar de distintas formas. ¿Confundido? Nos parece perfectamente normal, y no es tarea sencilla explicarlo, pero ahora nuestro mejor esfuerzo.

Índice de contenidos

Que es el HDR en un monitor

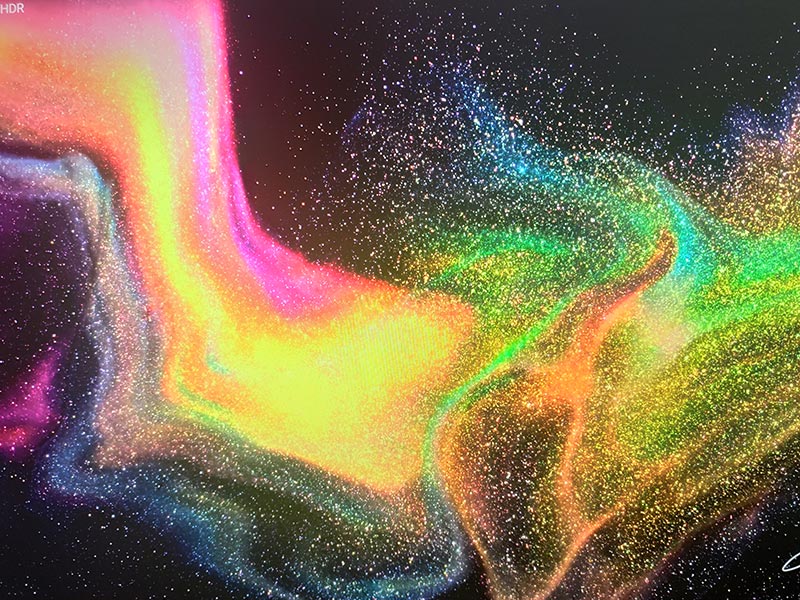

Sus siglas significan High Dynamic Range o Alto Rango Dinámico, y se trata de una tecnología implementada en muchos monitores capaz de generar imágenes con contraste realzado. Esto significa que la imagen mostrada debe ofrecer una gran diferencia entre las zonas brillantes y oscuras, superando al contraste típico del monitor en cuestión.

El objetivo de HDR es mostrar imágenes más realistas sin renunciar a ningún detalle, y para ello será indispensable una conexión digital como HDMI y DisplayPort. Actualmente tanto la versión 2.1 de HDMI como DisplayPort 1.4 soportarán HDR en frecuencias de refresco superiores a los 60 Hz.

Claro que no todos los monitores que admiten tener HDR o HDR Ready (preparados para HDR) serán capaces de mostrar el contenido realmente en alta definición. De hecho a veces ni tan siquiera tenemos un modo HDR definido en el OSD, y otras veces la imagen HDR mostrada es de tan mala calidad que las escenas iluminadas parecen sumamente quemadas y ausentes de detalle.

Mas adelante veremos que VESA, creadora del DisplayHDR determinó que HDR pasa a ser notable a partir de los 400 nits (cd/m2) de brillo en el panel. Así que aquellos monitores que afirmen ser HDR y su brillo esté por debajo de esta cifra, solamente venderán humo a los usuarios. Ni 200 ni 350 nits son suficiente para HDR, así que debéis tenerlo muy presente a la hora de comprar un monitor.

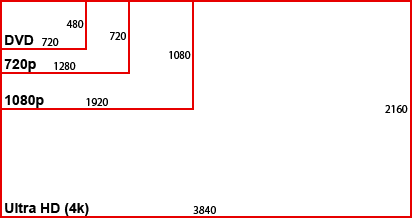

Por otro lado, tener un monitor HDR no implica que sea UHD, QHD o FHD, pues este protocolo es independiente a la resolución de monitor. La resolución nos indica la cantidad de píxeles disponibles para formar una imagen (1920x1080p, 2650x1440p o 3840x2160p y así sucesivamente), mientras que las pulgadas miden la diagonal de dicho panel. Claro que mientras mayor sea la resolución y mayor sea la densidad de píxeles en una pantalla, mejor definición de imagen tendremos y más partido se le sacará.

HDR vs SDR

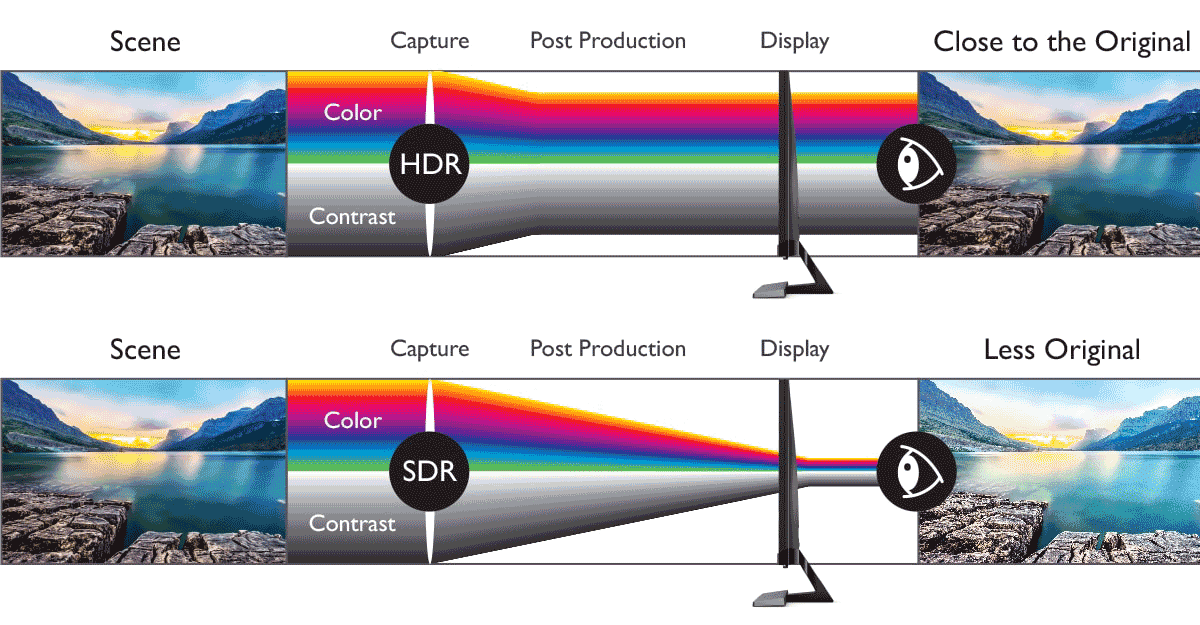

Al contrario que HDR, SDR significa Rango Dinámico Estándar, siendo un protocolo que utilizará un menor ancho de banda a la hora de transportar y mostrar la imagen en pantalla. Está orientado a su uso en interfaces de bajo ancho de banda en donde HDR no es capaz de operar o en monitores incapaces de ofrecer los estándares de calidad y contraste propios de la alta definición.

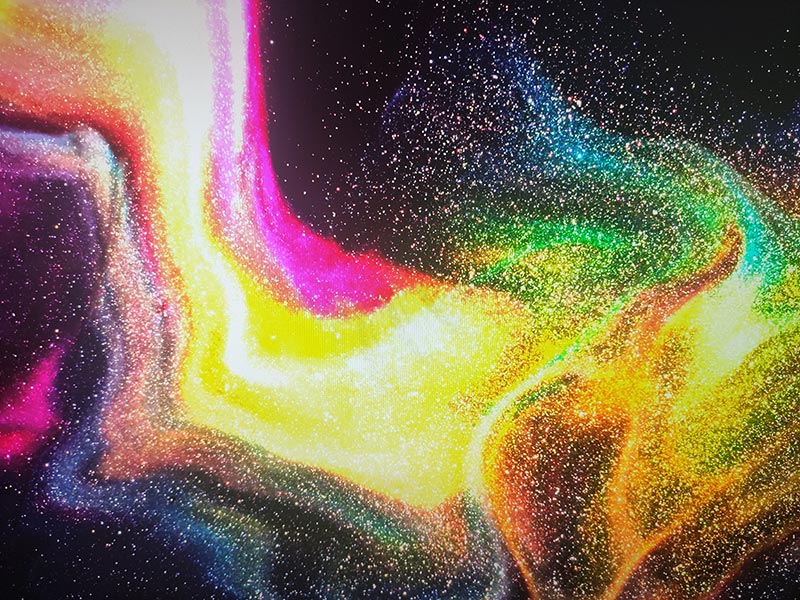

Una imagen SDR suele mostrarse con colores generados de forma artificial distantes a los que la escena realmente tiene. Generalmente podremos encontrar en los monitores un modo de imagen SDR que nos dejará clara esta diferencia frente a los modos que sí utilizan HDR. Por lo general, SDR debería de ofrecer un brillo más pobre, pérdida de detalles en la imagen y un color no natural.

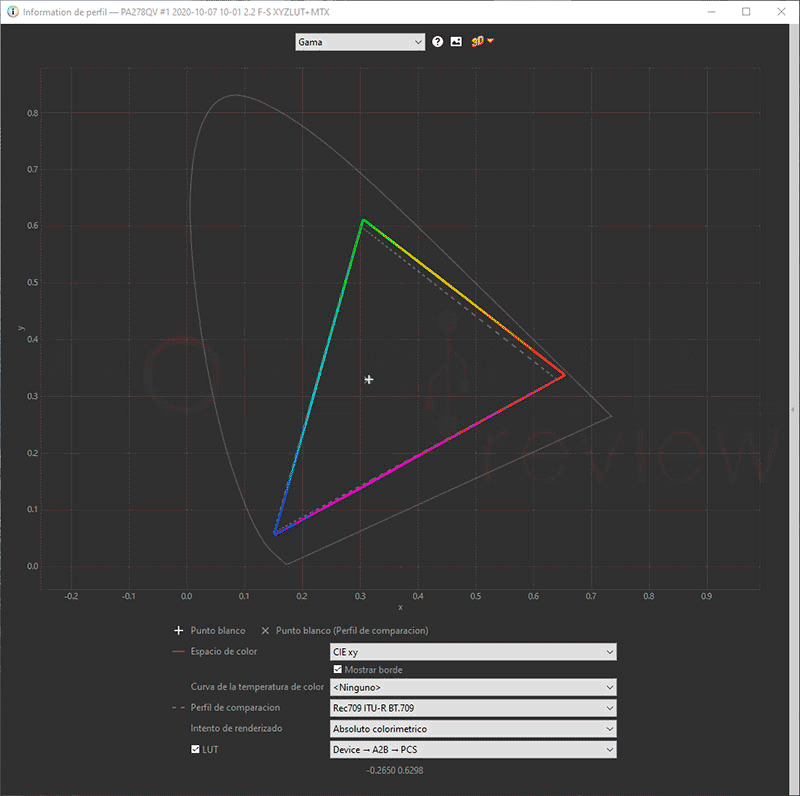

La tecnología HDR también está claramente asociada con el espacio de colores de un monitor. Este espacio determina la cantidad de colores que un panel es capaz de mostrar combinando los colores básicos Red-Green-Blue. El espacio de referencia obviamente es el espectro visible por el ser humano, y dentro de este, tendremos representaciones de triángulos que abarcan más o menos área dentro del espectro. En SDR tendremos una gama limitada a Rec.709 utilizada por el formato HDTV antiguo, mientras que en HDR se extiende hasta DCI-P3, el formato actual para cine y televisión en 4K.

HDR vs HDR10

Antes de ver la diferencia entre DisplayHDR vs HDR10, habrá que saber qué es el HDR10 y por qué precisamente lleva ese 10 al final. Se trata nada menos que de un estándar abierto del protocolo encargado de admitir la transmisión de contenido de vídeo en HDR comprimido. Fue adoptado en 2015 por la CEA, definido antes por UHD Association, Blue-Ray Association y HDMI Forum.

Entonces, un monitor que soporte imagen en HDR deberá ser capaz de decodificar archivos en formato HDR10, que por otro lado está adoptado en la gran mayoría de marcas de monitores del mercado actual. El distintivo “10” hace principal referencia a que dichos archivos de imagen deberán de tener una profundidad de 10 bits, tanto si se reproducen en un monitor de 10 bits como si no. Además, se deben reunir otros requisitos más técnicos como tener un color primario ITU-R BT.2020, o soportar submuestreo 4:2:2/4:2:0.

El estándar HDR no solo incluirá HDR10, sino que también deriva en otros formatos bastante conocidos como:

- HDR10+: seguramente lo hayamos visto mucho en las especificaciones de pantalla de smartphone, y tendrá todo el sentido al estar impulsado por Samsung junto a Amazon. Esta variante adopta la tecnología Dynamic Tone Mapping, una serie de metadatos que controlan la imagen HDR escena a escena o incluso frame a frame. Así se mejora el uso del color y brillo en pantallas compatibles.

- Dolby Vision: esta tecnología será el formato HDR por excelencia dentro de la industria, el más avanzado y el más potente en cuanto a la gestión de brillo, color y nitidez de cada fotograma de imagen. Éste ya incluye Dynamic Tone Mapping mucho antes que HDR10+, y ahora se actualiza a Dolby Vision IQ que optimiza el contenido a función de la luz ambiental. De esta forma mejora las escenas oscuras en habitaciones iluminadas son sobreexponer las zonas brillantes.

- HLG: otro formato de imagen será Hybrid Log Gamma desarrollado por BBC y NHK para crear monitores HDR menos costosos al ser compatible con los estándares de transmisión en la región de SDR. La idea es aplicar más detalle a una imagen SDR sin costo adicional utilizándose con el espacio Rec.2020.

En resumidas cuentas, HDR se trata de la tecnología de imagen en alta definición, y HDR10 el formato y protocolo que decodifica dichos archivos para que sean mostrados. Fácil y sencillo.

DisplayHDR vs HDR10

Una vez tenemos claro qué es el HDR y HDR10 ya tenemos lo necesario para saber el enfoque del DisplayHDR. Es un concepto totalmente distinto que nace de la necesidad de medir qué rendimiento de imagen es capaz de dar un monitor con HDR. Esto surgió por la escasez de información sobre la imagen que se genera con HDR, pues solo explica la forma en la que se procesan y reciben los datos de imagen.

Ya hemos mencionado antes que hay monitores HDR y HDR Ready que dejarán mucho que desear en la realidad, degradando mucho la categoría o imagen que realmente debería significar ser HDR. Así que VESA decidió inventar un mecanismo que midiera el brillo máximo de un panel, así como los niveles de negros para determinar qué calidad de HDR va a tener cada monitor. Actualmente el estándar se encuentra en la versión DisplayHDR CTS v1.1.

Así que DisplayHDR no es un estándar HDR, servirá como punto de referencia en la calidad del HDR que tendrá un monitor. En paneles basados en LCD/LED como los IPS el mecanismo sirve para medir el brillo máximo que se alcanza, mientras que en paneles OLED medirá también los niveles de negros, habiendo sacado dos certificaciones específicas para ellos. La medida que siempre será sobre el brillo máximo, y para cumplirse de forma efectiva, el monitor debe asegurar este brillo durante largos períodos de tiempo. Por ahora, solamente se trabaja con certificaciones en monitores de PC y pantallas de portátiles, aún no se ha metido en el mundo de televisores.

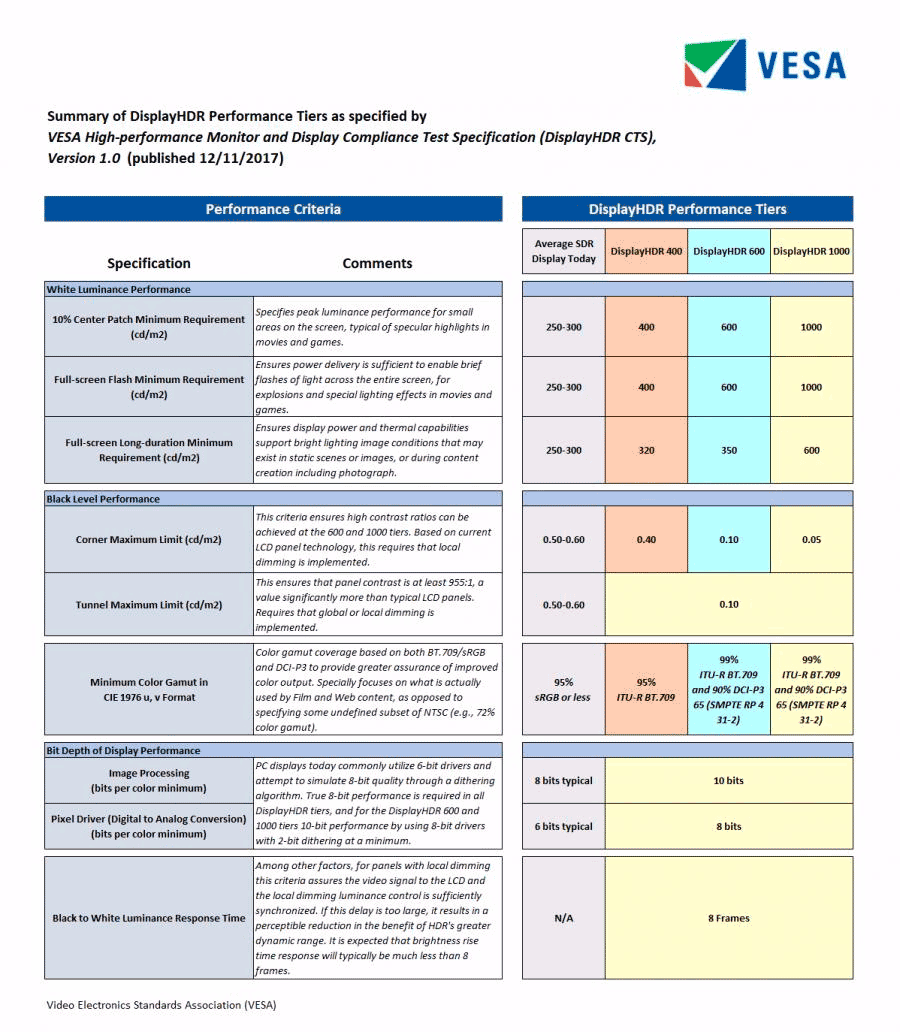

Cuando un monitor cumple con las exigencias de la prueba se le aplicará una certificación clasificada en distintos niveles en función del brillo, siendo:

- DisplayHDR 400, 500, 600, 1000, 1400

- DisplayHDR 400 True Black

- DisplayHDR 500 True Black

De esta forma los valores coinciden con el brillo máximo que deberá de mostrar el panel a la hora del análisis, midiéndose en nits o candelas por metro cuadrado cd/m2. Además de cumplir con las exigencias de brillo, DisplayHDR también exige otra serie de especificaciones a cumplir:

- Admitir todo el espacio de color sRGB cuando será DisplayHDR 400

- Tener una profundidad de color de 8 bits realmes como mínimo (no vale 6 bits + FRC), siendo esto 16,7 millones de colores.

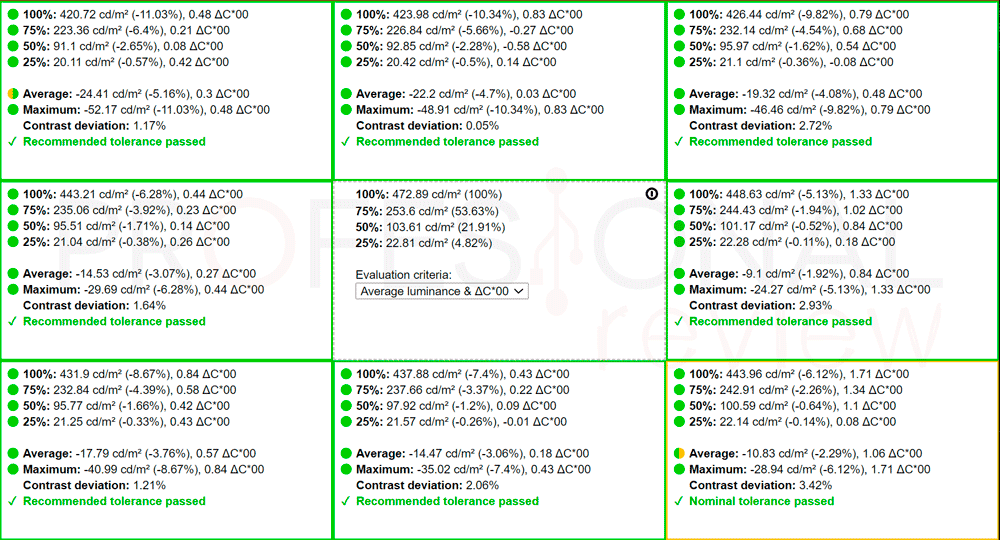

- Capacidad de atenuación global de la pantalla, es decir, que el panel pueda cambiar de negro a blanco de forma uniforme. De hecho, nosotros solemos medir la uniformidad en nuestro análisis por este motivo.

- En el caso de paneles Mini LED o Qantum Dot con atenuación local, es un factor a tener en cuenta en la prueba a partir de DisplayHDR 500 hasta 1400. Mientras mayor sea la certificación, mayor atenuación local y relación de contraste dinámico deberá tener el monitor.

- Desde DisplayHDR 500 a 1400 los monitores deben admitir WCG (Wide Color Gamut), siendo alguno de los espacios P3, DCI-P3 o Adobe RGB que superan la cantidad de colores de sRGB. A partir de HDR 1400 deberá tener al menos un 95% DCI-P3.

- Desde la certificación 500 a 1400 también se exige que el monitor sea capaz de procesar imágenes de 10 bits

- En cuanto a las certificaciones para paneles OLED, se exigen niveles de negros inferiores a 0,0005 nits y un rango dinámico hasta 50 veces superior

¿Merece la pena tener un monitor certificado DisplayHDR?

Con el alto nivel que tienen los monitores actuales y la gran cantidad de contenido en HDR que hay en el mercado, incluidos los videojuegos, creemos que lo más recomendable sería comprar un monitor que soporte HDR con al menos certificación DisplayHDR 400.

Con facilidad superarán los 350 euros este tipo de monitores, una cifra relativamente elevada para aquellos que simplemente necesiten un monitor para trabajar. Por este motivo llagará a merecer la pena si planeamos utilizarlo activamente para ver contenido multimedia y otra jugar. Prácticamente todos los juegos cuentan con capacidad HDR, y elegir un buen monitor será clave para disfrutar al máximo de su contenido.

Como antes hemos mencionado, lo más recomendable será elegir una unidad con certificación, pues los modelos que simplemente son HDR o HDR Ready no suelen dar los estándares de calidad suficientes para notar una mejora visual en el contenido.

Como saber si mi monitor es HDR

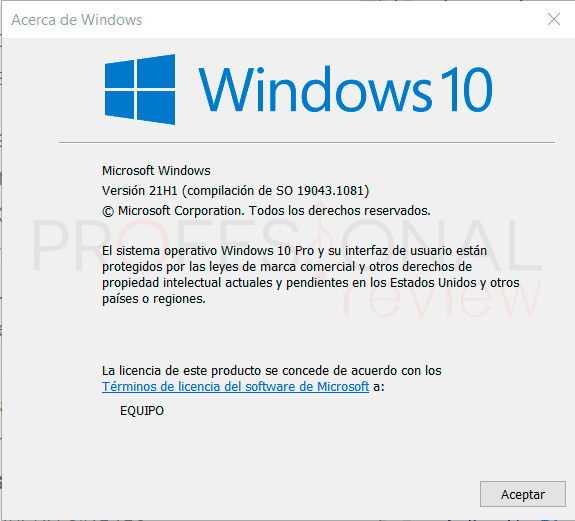

Antes de verificar esto, debemos tener en cuenta que Windows es compatible con HDR a partir de la versión 1803, algo que podremos descubrir simplemente abriendo la herramienta Ejecutar (Windows + R) y escribiendo el comando “winver”

Los controladores de la tarjeta gráfica también deberán de estar actualizados para evitar posibles problemas de compatibilidad.

Lo más evidente para saber si nuestro monitor es HDR es conocer sus especificaciones técnicas, algo que aparecerá en la documentación de soporte o directamente en la página web del fabricante.

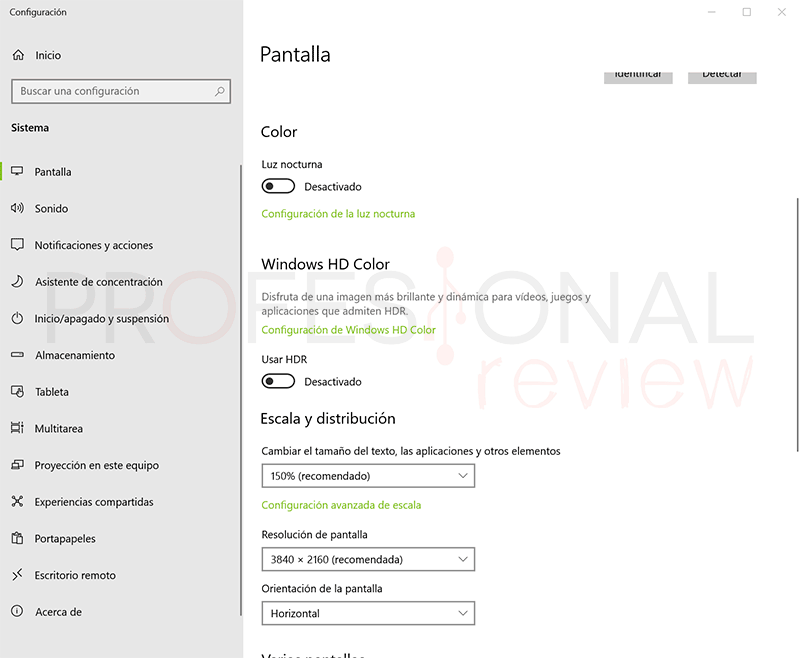

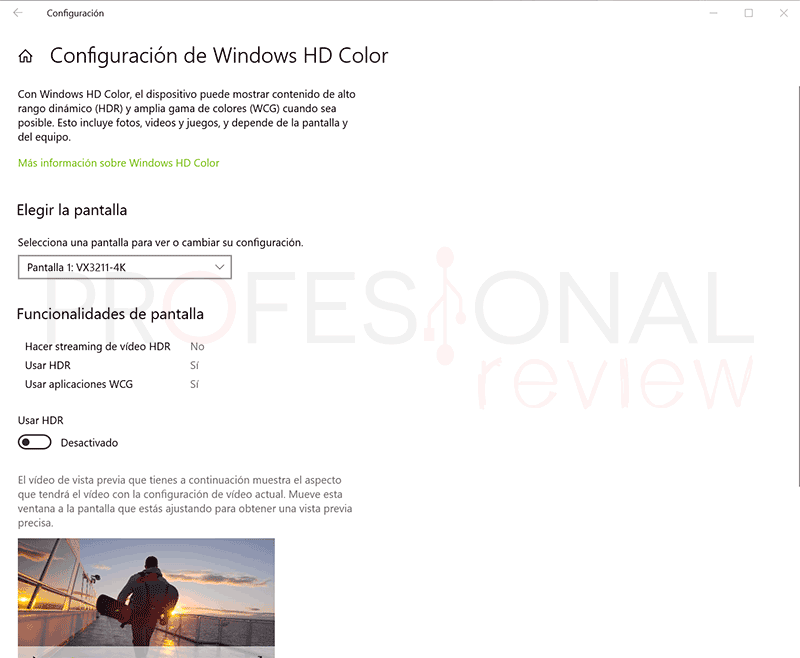

La opción para activar el HDR en Windows aparecerá pulsando botón derecho sobre escritorio y entrando en Configuración de pantalla. En la lista de elementos debería aparecer la opción Windows HD Color.

El modo HDR lo aplicaremos activando el botón Usar HDR situado más abajo. En caso de que no aparezca esta opción, significará que el monitor no reproduce contenido HDR, pues actualmente todas las GPU incluso integradas admiten HDR desde los procesadores Intel de 7ª Gen.

En este punto seguramente tendremos que entrar el en OSD del monitor y activar el modo HDR o un perfil de imagen HDR que haya disponible. En caso contrario, podremos resetear el monitor y probar de nuevo.

Cuando entremos en las opciones de Windows HD Color aparecerán dos opciones en el apartado Capacidades de pantalla que podremos activar para reproducir el contenido en HDR. En esta sección se mostrarán las capacidades disponibles en la pantalla, y en caso de que todas o parte estén como “No” significará que el monitor no tiene activo el HDR o que no es compatible.

Tras esto, sería buena idea verificar que efectivamente se puede mostrar contenido en HDR, notándolo claramente en la potencia de brillo cuando reproduzcamos algo en HDR y SDR, en donde el brillo será más y menos potente. Podremos por ejemplo abrir Paint o el Bloc de notas que funcionan en SDR, y por otro lado algún vídeo en HDR como los de este canal de YouTube.

En última instancia podremos hacer la prueba con un colorímetro o con la aplicación DisplayHDR Test disponible en Microsoft Store que tiene una serie de pruebas con las que podemos determinar que efectivamente estamos viendo en HDR.

Conclusiones

Seguramente ahora DisplayHDR vs HDR10 sean conceptos que nos queden más claro, especialmente importantes si planeamos comprar un buen monitor para juegos o para un setup de creación de contenido. El estándar se irá actualizando al ritmo que la tecnología de los monitores avanza. Con paneles Mini LED, Micro LED, AMOLED y Quantum Dot como los mejores actualmente, con contrastes increíbles y brillos aún más potentes para pronto ver seguramente un DisplayHDR 1500.

Os dejamos con algunos tutoriales relacionados con el tema de monitores, y por supuesto con nuestra guía actualidad en donde recogemos lo mejorcito: