El HDR vs SDR es algo que hacemos todos cuando vamos a comprar un monitor o TV, y es que hay que saber exprimir cada euro. Por tanto, aquí tenéis la comparativa que busca esclarecer todas las dudas sobre ambas tecnología.

Con la llegada del HDR, muchos nos preguntamos si merece la pena invertir más dinero para disfrutar de esta tecnología. Gracias al HDR, el televisor puede mostrar el contenido de forma más precisa, pero veremos que dicha especificación no es lo todo en términos de calidad de imagen. Así que, la comparativa de HDR vs SDR busca disipar dudas y concluir qué es mejor.

Qué es el HDR

Se trata de una abreviación de High Dynamic Range, o Alto Rango Dinámico, una tecnología que permite a la pantalla mostrar más detalles en cada imagen. El HDR viene de la fotografía tradicional, dando el salto a monitores, smartphones, etc. En la práctica, una foto con HDR suele tener más detalle, una gama de colores más amplia y un aspecto más realista, ¿verdad?

Para entenderlo bien, hay que hablar de los metadatos HDR, que son información adicional caracterizada por enviarse por la señal de vídeo para que el panel muestre detalles adicionales.

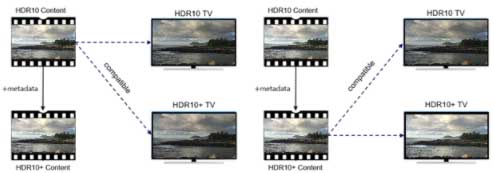

Todos los metadatos se distribuyen usando un estándar: HDR10, HDR10+, Dolby Vision, HLG, etc. Así que, dicho de forma popular, los metadatos HDR ordenan al panel a mostrar ciertos detalles, pero, ¿y si el panel no puede mostrarlos? Aquí está una de las claves: el HDR no lo es todo.

Lo que diferencia al HDR del SDR (Standard Dynamic Range), es que el HDR funciona de forma más precisa, mientras que el SDR es menos específico. De este modo, ya vamos adelantando que el HDR se aprovechará cuando el panel reúna unas prestaciones mínimas.

Con los paneles SDR (o sin HDR), tenemos el problema de que el contraste es bajo o que los colores no den tanto detalle. Esto significa que los metadatos no son tan precisos, por lo que no podremos apreciar ciertos detalles en la imagen que sí ha captado la cámara.

Dolby Vision

Famoso por estar presente en toda la gama LG OLED, se trata de una norma HDR que pide que el monitor o TV equipe el chip Dolby Vision. Dolby cobra por la licencia, y se trata de unos metadatos HDR que usan colores de 12 bits y un brillo máximo de 10.000 nits.

Habéis supuesto bien, no hay ningún panel con tantos nits, pero lo que singulariza a Dolby Vision son sus altos requisitos hardware. Por ello, solo lo veremos en la gama alta, aunque podemos ver algunas excepciones.

HDR10

Se ha hecho muy famoso por los discos Blu-Ray, como en el mundo de la telefonía. Esta norma HDR es más fácil adoptar porque es libre y no hay que pagar ninguna tarifa. El 10 del final hace referencia a que usa 10 bits de profundidad de color y llega hasta los 1000 nits de brillo.

Es mucho más usado en todas las gamas, especialmente por Sony y Microsoft, que adaptaron este HDR para sus Xbox y PlayStation.

HDR10+

Por último, tenemos uno de los HDR más famosos en televisores, especialmente Samsung, ya que la marca coreana lo desarrolló junto con Amazon Prime Video. Viene como especificación estrella en las Tvs QLED y en sus smartphones de gama alta.

Lierto es que Google Play streaming y las televisiones Vizio lo incluyen; posiblemente, Netflix se una a este formato en el futuro.

HDR vs SDR

A nosotros nos interesa el HDR en vídeo, y es que se puede decir que es una mezcla de 3 cosas: una gama de colores más amplia, profundidad de color y tanco dinámico. Por tanto, vamos con la comparativa de HDR vs SDR en estos 3 aspectos.

Gama de colores

En primer lugar, para disfrutar del HDR en un buen televisor o monitor, tenemos que optar a uno que tenga una gama de colores amplia. Con gama de colores hacemos referencia al nivel de saturación. En los televisores, el espacio de color más utilizado es DCI-P3, y hay que decir que con HDR mejora bastante la saturación del color.

Dicho esto, cuidado con comparar un panel SDR vs otro HDR y que tengan un espectro de color distinto. En el caso de que tengan una cobertura de color similar, no veremos apenas diferencia en la imagen. Por este motivo, los HDR de gama baja no suelen ofrecer esas mejoras de calidad de imagen que muchos se creen.

Profundidad de color

Pasamos a la profundidad de color, la cual se refiere a la cantidad de información de color que hay disponible por cada píxel. Esta cantidad es medida por bits, de ahí que veamos pantallas con profundidades de 8, 10, 12, 14 y 16 bits.

En este caso, la profundidad de color determina cuántos colores vamos a ver (8 bits, 256 tonos; 16 bits, 65.536 tonos, etc.). Por tanto, un televisor con una profundidad de 8 bits mostrará unos 16 millones de colores, mientras que uno de 10 bits llegará a más de 1000 millones de colores.

¿Cómo se aprecia? En los degradados, pero no creáis qué veremos grandes diferencias de 10 a más bits, aunque sí que se nota el cambio de 8 a 10 bits. Relacionándolo con el HDR y el SDR, los cielos y mares suelen ser los protagonistas en en estos puntos.

En este caso, el HDR gana de todas todas, incluso en gamas bajas, ¿por qué? Básicamente, porque un panel con HDR partirá de los 10 bits, mientras que un panel SDR puede ser de 8 bits perfectamente.

Rango dinámico

Llegamos al último punto en discordia, el cual deja como ganador al HDR como era de esperar; eso sí, siempre y cuando el contenido sea HDR. En un panel SDR veremos un rango dinámico muy limitado: no puede mostrar mucha luz y elementos oscuros al mismo tiempo.

Por el contrario, un monitor con HDR puede hacer ambas tareas sin ningún problema, mostrando una imagen final más precisa, con más detalle y mucho más realista. Volvemos a hacer hincapié en que el HDR no es magia, sino que depende de las características del panel, y en este caso hablamos del brillo y el contraste.

Por mucho HDR que tengamos, necesitaremos un brillo alto y un contraste a la altura. El resultado es brutal en un panel de gama alta, pero en un panel con HDR de gama baja no se ven tan nutridos los colores y las sombras no se ven tan bien como en gama alta.

SDR vs HDR, ¿cuál es el ganador?

Con todo analizado, solo queda dejar claros ciertos puntos:

- No sirve cualquier panel con HDR. El panel tiene que reunir unas prestaciones base de gama de colores, profundidad de color, contraste y brillo.

- El SDR pierde potencia en la mayoría de ocasiones, pero puede tener grandes bondades si las prestaciones del panel son buenas.

- El SDR no puede reproducir contenido HDR.

- Cuidado con los paneles de gama baja y con HDR.

Nuestro veredicto es claro, es mejor el HDR que el SDR, pero siempre que el panel merezca la pena. Esperamos que os haya sido útil este contenido, si tenéis alguna duda dejadla abajo y os las responderemos en breve.

Te recomendamos los mejores monitores del mercado

¿Vuestra pantalla tiene HDR? ¿Aprovecháis esta tecnología o no merece la pena?