Intel Pentium 4 supuso un cambio radical en el mundo del PC y es que con el final de toda una década acechando tras la esquina, este es un momento idóneo dentro de un portal como Profesional Review para hacer un balance de qué nos ha llevado hasta donde nos encontramos hoy.

El vehículo para hacer este viaje será el salto de Netburst a Nehalem en los procesadores Intel; o lo que es lo mismo, la despedida de los procesadores Pentium 4, pasando por los Core 2 (y Core 2 Quad) antes de los Intel Core actuales. Un viaje de más de dos décadas y cuyas bases posiblemente dejemos de ver dentro de no mucho. No en vano, se dice que la historia es un incensare volver a empezar.

Índice de contenidos

Intel Pentium 4: El fin de una década

El lanzamiento de Conroe (2007) fue un auténtico hito para Intel. Supuso la despedida en sobremesa de Netburst (micro-arquitectura), que hasta ahora había articulado al mítico Pentium 4; así como la vuelta (en cierto modo) a la micro-arquitectura P6, en la que se basarían los primeros Intel Core. Aunque el salto ocurriera antes a través de Pentium M en portátiles.

El abandono de Netburst trajo consigo el abandono de sus altas frecuencias, así como las tecnologías desarrolladas para ella (como el Hyper-Threading) en el corto plazo; pero esta no fue una decisión arbitraria.

Las bondades de los Pentium 4 se ahogaban a través de sus serios problemas de temperatura y escalabilidad, que hacían a la micro-arquitectura Netburst poco viable para portátiles y servidores, dos mercados tan potentes en la época como hoy día.

Intel Pentium 4 con Netburst y la segmentación de datos

Estos problemas que presentaba Netburst derivaban en su mayoría de la enorme data pipeline a través de la cual operaba la micro-arquitectura y de los problemas con la predicción de instrucciones.

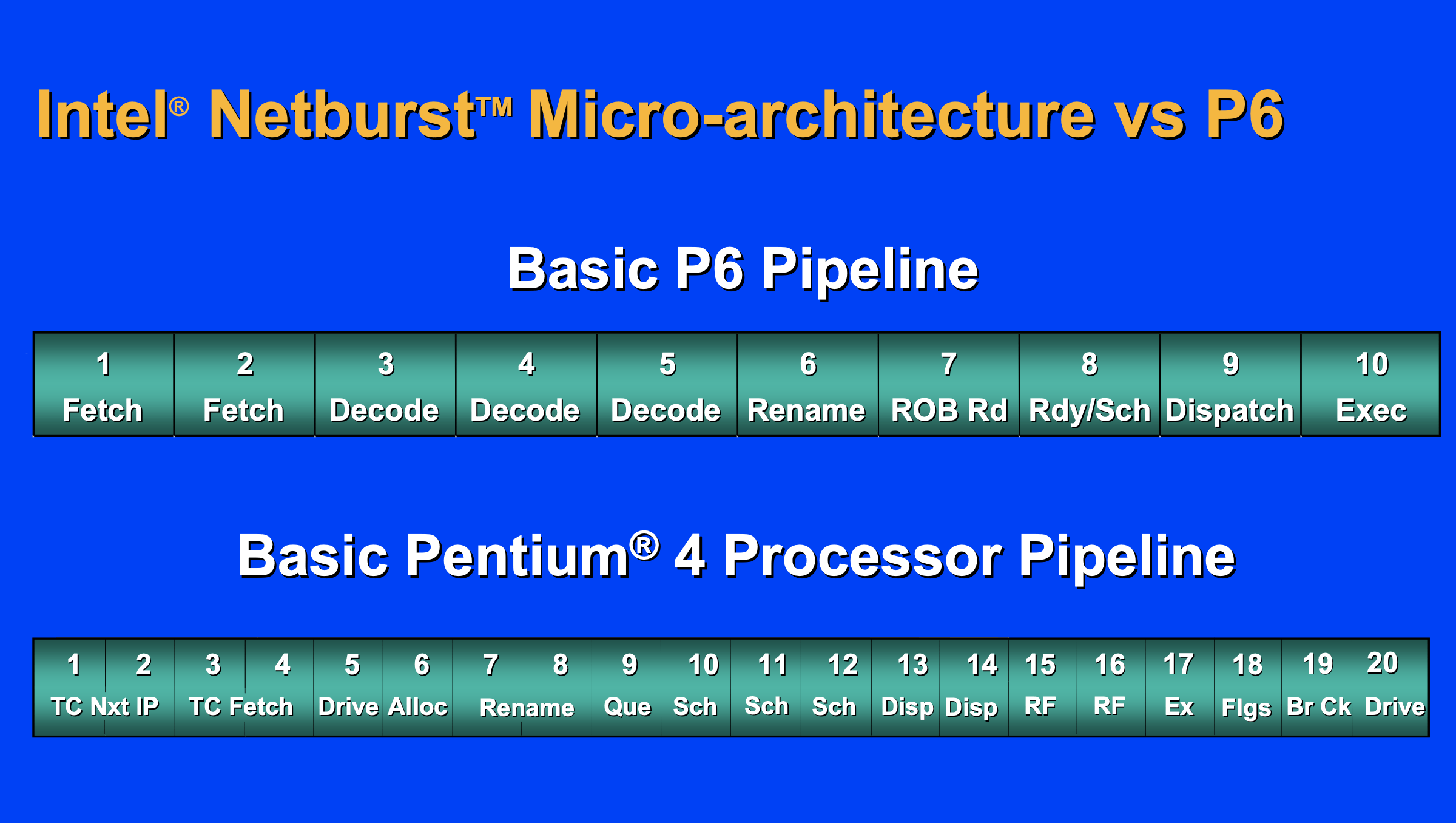

Groso modo, la segmentación de instrucciones (data pipeline en inglés) es un método para descomponer en etapas la ejecución de una instrucción del procesador y así aumentar su velocidad. Sin esta segmentación tendríamos que esperar a terminar la ejecución de una instrucción antes de empezar la siguiente, un proceso muy lento. Con dicha segmentación podemos empezar cada etapa conforme se termina.

Netburst tenía una pipeline de instrucciones de más de 20 segmentos (31 en revisiones posteriores) manteniendo constantemente ocupado al procesador y dando pie a las grandes frecuencias que hicieron famosos a los Pentium 4.

Por desgracia, una línea tan larga era muy perjudicial para la ya nombrada predicción de instrucciones, ya que si esta predicción fallaba, el número de etapas que el procesador debía rehacer era enorme. Además, mantener frecuencias tan altas de forma poco eficiente traía consigo un serio problema de temperatura. Intel se topó con un muro físico que era incapaz de saltar con esta arquitectura.

La arquitectura Core a través de Conroe

Fue a raíz de estos problemas que vimos el nacimiento de la micro-arquitectura Core. Intel dio un paso atrás y replanteó su estrategia de desarrollo; ya no buscarían las mayores frecuencias posibles, si no la máxima eficiencia a través de un set pequeño y funcional.

Encontraron esta eficiencia desarrollando el experimento realizado con el procesador Pentium M, derivada de la ya nombrada micro-arquitectura P6, predecesora de Netburst.

Pentium M comparte muchas similitudes con lo que después sería Core, como el set de 12 etapas para instrucciones (aumentadas a 14), o la distribución de la memoria L2 (aumentada posteriormente). Además, aumentaba el número de unidades de ejecución a cuatro, e introducía nuevas tecnologías centradas en su escalabilidad, como Micro-Core.

Intel lanzó bajo Conroe en 2007 a los procesadores Intel Core 2 Duo, destacando los modelos E6400, E6600 y X6800 en la gama extrema; así como diferentes iteraciones de la arquitectura para diferentes propósitos, donde destacan Merom para el mercado portátil y Kentsfield para sus procesadores de cuatro núcleos, los Core 2 Quad (destacando el Q6600).

Nehalem: el “tac” tras el “tic”

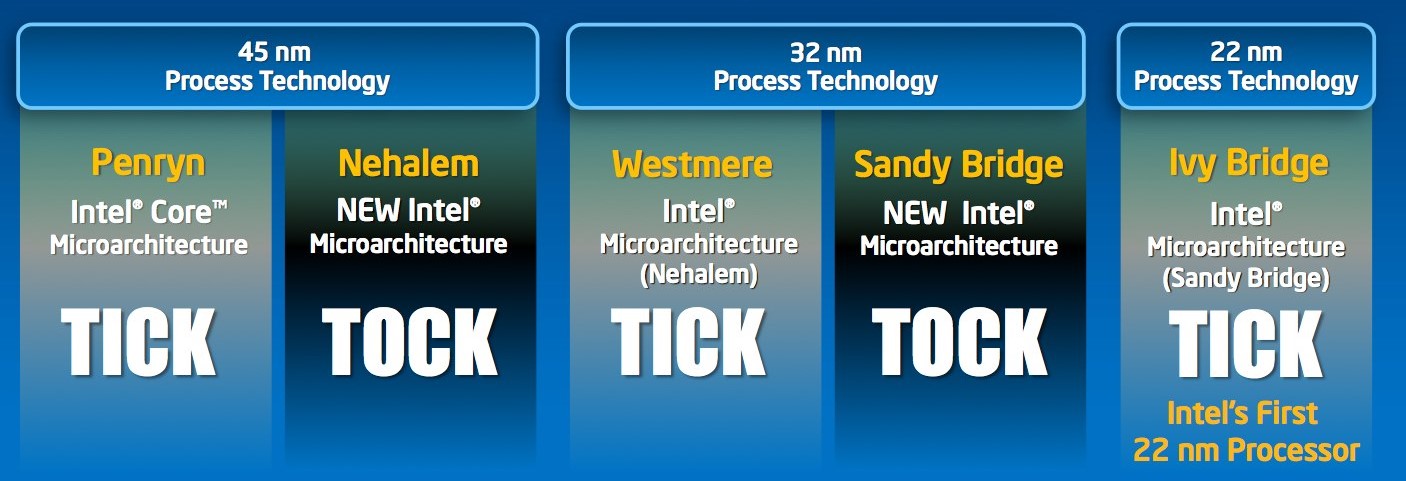

En 2007 Intel presentó el curioso modelo de “tic-tac”. Una planificación a largo plazo (los comúnmente llamados roadmaps) para el desarrollo y lanzamiento de sus arquitecturas. En este modelo, el “tic” corresponde a la mejora en el proceso de fabricación (reducción del DIE), mientras que el “tac” se le atribuye a los cambios de arquitectura.

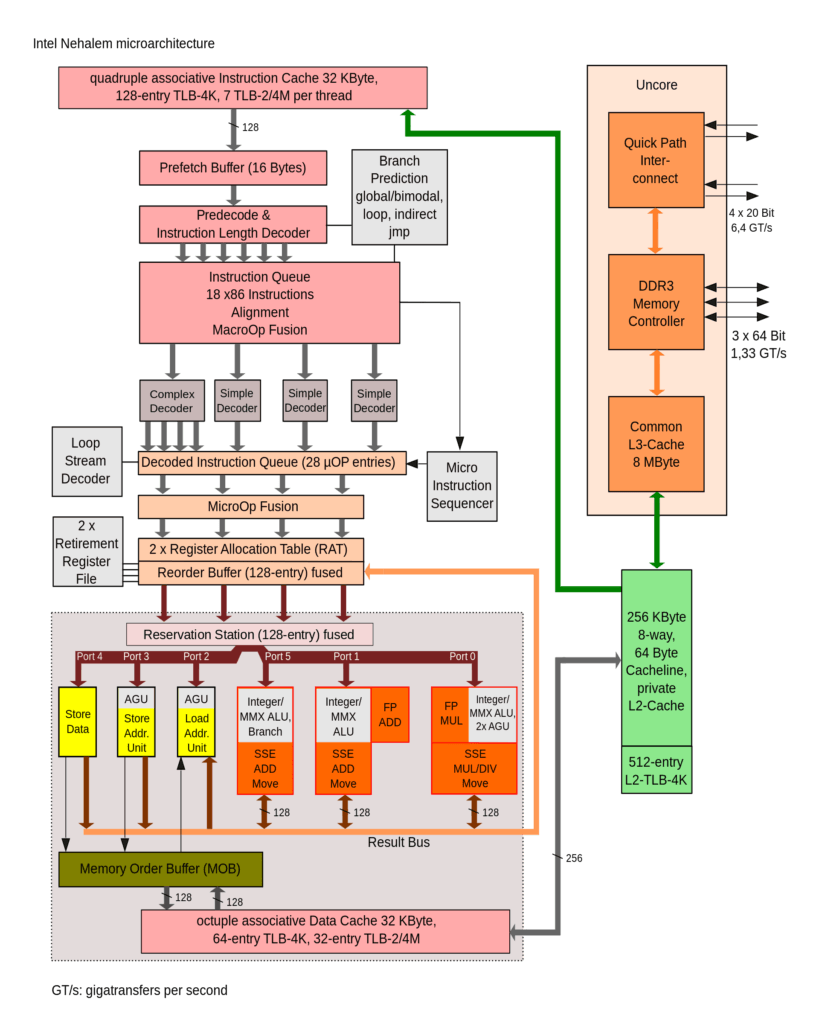

El “tac” tras el lanzamiento de Conroe fue Nehalem, la arquitectura que daría vida a los primeros procesadores Intel Core modernos, así como la bienvenida a las marcas i3, i5 e i7.

Un salto generacional en la serie Intel

Conroe vivió diversas revisiones a lo largo de sus dos años de vida: Wolfdale, Yorkfield o Woodcrest son algunos ejemplos, pero el primer salto salto generacional dentro de Intel Core sería Nehalem.

Esta arquitectura seguía los mismos principios de eficiencia y escalabilidad que Intel buscaba tras alejarse de Netburst, pero rescató algunas de las características que definieron a esta micro-arquitectura.

Intel Pentium dentro de Nehalem

Con Nehalem volverían las pipelines de más de veinte etapas, así como tecnologías como el Hyper-Threading; pero también desaparecían los problemas de predicción, gracias al uso de un predictor de segundo nivel y la mejora de otras tecnologías relacionadas, como el detector de loops. Además se mantenían algunas de las características que definían a Conroe, al arrastras consigo las bases de esta arquitectura.

Para evitar los problemas del pasado, Intel comenzó a aplicar una regla de proporción desde el propio desarrollo de la arquitectura, todas las características de la arquitectura que aumentaran el consumo del procesador deberían tener el doble de repercusión en su rendimiento.

Además, se trataba de una arquitectura desarrollada con la modularidad en mente. Los núcleos que formaban cada chip eran independientes y replicables, por lo que era fácil crear procesadores con diferentes configuraciones de núcleos y expandir la arquitectura al mercado portátil o al mundo de los servidores.

Te recomendamos la lectura de las siguientes guías y tutoriales:

Con Nehalem, Intel estaba concienciada de no caer en los mismos problemas de Netburst. Un objetivo que creemos que fue capaz de conseguir.