Ya hemos hablado sobre la tecnología DLSS de las tarjetas gráficas GeForce RTX y como es su funcionamiento en un artículo especial, y ahora que el lanzamiento de la nueva generación Turing está llegando a los compradores, comienzan a surgir las primeras comparativas sobre esta tecnología.

Por fin vemos la tecnología Nvidia DLSS en acción

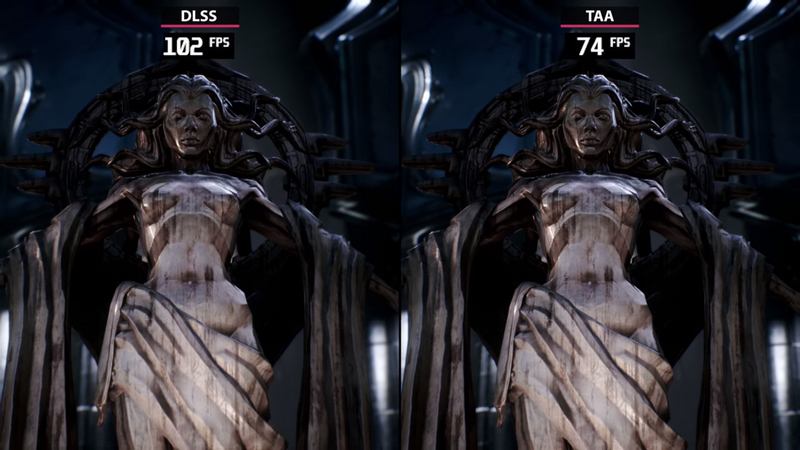

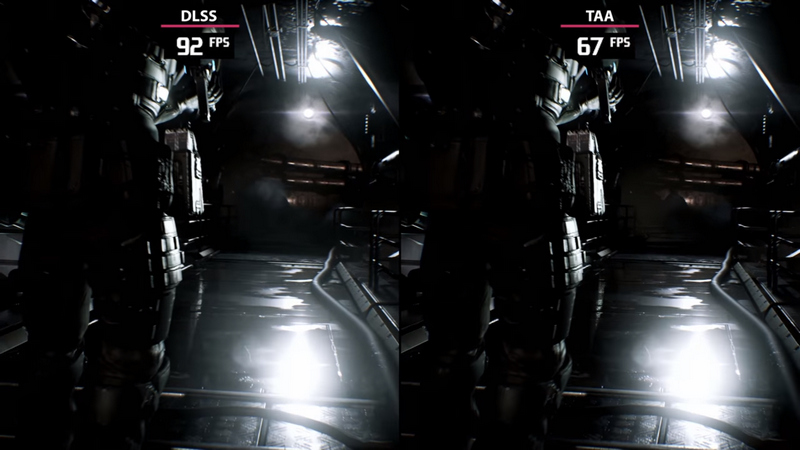

El canal de YouTube Candyland, tiene en sus manos una RTX 2080 Ti, con la que hizo la comparativa de imagen y rendimiento ofrecida por la tarjeta bajo la demo Infiltrator en Unreal Engine 4. La comparativa se hizo con la tecnología DLSS activa frente al mismo juego con antialiasing TAA (y DLSS desactivado, por supuesto).

El juego se ejecutó en resolución 4K con un sistema i7 6700K overclockeado a 4.0 GHz, 16 Gb de memoria RAM y una GeForce RTX 2080 Ti.

Por los resultados que se ven durante la demostración, la eficacia de la tecnología DLSS mejora sustancialmente el rendimiento dependiendo de la escena, manteniendo una nitidez similar en la imagen. Aunque aquí hay que decir que la compresión del video que hace YouTube puede engañar un poco, pero poniendo el video en 4K no se nota diferencias sustenciales en la calidad de imagen.

La mayor parte del tiempo la mejora en el rendimiento es importante, pero en otros trayectos de la demostración, la mejora es mucho menor.

[irp]Nvidia anuncio que la tecnología DLSS (Deep Learning Super-Sampling) utiliza los nuevos núcleos Tensor de la serie RTX 20, por lo que no se podrá utilizar en tarjetas gráficas de la serie GTX. Posiblemente, muchos juegos en el futuro terminen implementando DLSS para mejorar el rendimiento en general, a costa de perder un poco de calidad de imagen.