Nvidia 【 TODA LA INFORMACIÓN 】

Nvidia Corporation, más comúnmente conocida como Nvidia, es una compañía de tecnología estadounidense constituida en Delaware y con sede en Santa Clara, California. Nvidia diseña unidades de procesamiento de gráficos para los mercados de videojuegos y profesionales, así como sistema en unidades de chip (SoC) para el mercado de computación móvil y automotriz. Su línea principal de productos, GeForce, está en competencia directa con los productos Radeon de AMD.

Te recomendamos la lectura de nuestras mejores guías de hardware y componentes para PC:

Además de la fabricación de GPUs, Nvidia proporciona en todo el mundo capacidades de procesamiento en paralelo a investigadores y científicos, que les permiten ejecutar de manera eficiente aplicaciones de alto rendimiento. Más recientemente, se ha trasladado al mercado de la informática móvil, donde produce procesadores móviles Tegra para consolas de videojuegos, tablets y sistemas de navegación autónoma y entretenimiento para vehículos. Esto ha llevado a que desde 2014, Nvidia se ha transformado en una compañía enfocada en cuatro mercados: juegos, visualización profesional, centros de datos e inteligencia artificial y automoviles.

Índice de contenidos

Historia de Nvidia

Nvidia fue fundada en 1993 por Jen-Hsun Huang, Chris Malachowsky, y Curtis Priem. Los tres cofundadores de la compañía plantearon la hipótesis de que la dirección correcta para la informática pasaría por el procesamiento acelerado por gráficos, pues creían que este modelo de computación podría resolver problemas que la informática de propósito general no podía resolver. También observaron que los videojuegos son algunos de los problemas más desafiantes desde el punto de vista computacional, y que tienen un volumen de ventas increíblemente alto.

De una pequeña empresa dedicada a los videojuegos a un gigante de la inteligencia artificial

La compañía nació con un capital inicial de 40,000 dólares, inicialmente no tenía nombre y los cofundadores nombraron todos sus archivos NV, como en «próxima versión». La necesidad de incorporar a la compañía hizo que los cofundadores revisaran todas las palabras con esas dos letras, lo que las llevó a «invidia», la palabra latina que significa «envidia».

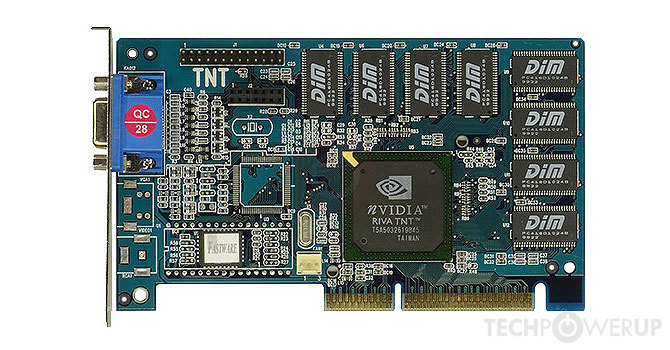

El lanzamiento de RIVA TNT en 1998 consolidó la reputación de Nvidia para desarrollar adaptadores de gráficos. A fines de 1999, Nvidia lanzó la GeForce 256 (NV10), que más notablemente introdujo la transformación e iluminación (T & L) a nivel de consumidor en hardware 3D. Funcionando a 120 MHz y presentando cuatro líneas de píxeles, implementó aceleración avanzada de video, compensación de movimiento y fusión de sub-imagen de hardware. GeForce superó a los productos existentes por un amplio margen.

Debido al éxito de sus productos, Nvidia ganó el contrato para desarrollar el hardware de gráficos para la consola de juegos Xbox de Microsoft, lo que le valió a Nvidia un avance de $ 200 millones. Sin embargo, el proyecto se llevó a muchos de sus mejores ingenieros de otros proyectos. A corto plazo, esto no importó, y el GeForce2 GTS se envió en el verano de 2000. En diciembre de 2000, Nvidia llegó a un acuerdo para adquirir los activos intelectuales de su único rival 3dfx, un pionero en tecnología gráfica 3D para el consumidor que lideraba el campo desde mediados de la década de 1990 hasta 2000. El proceso de adquisición finalizó en abril de 2002.

En julio de 2002, Nvidia adquirió Exluna por una cantidad de dinero no revelada. Exluna era responsable de la creación de varias herramientas de representación de software. Más tarde, en agosto de 2003, Nvidia adquirió MediaQ por aproximadamente 70 millones de dólares. Y también adquirió iReady, un proveedor de soluciones de descarga TCP / IP e iSCSI de alto rendimiento el 22 de abril de 2004.

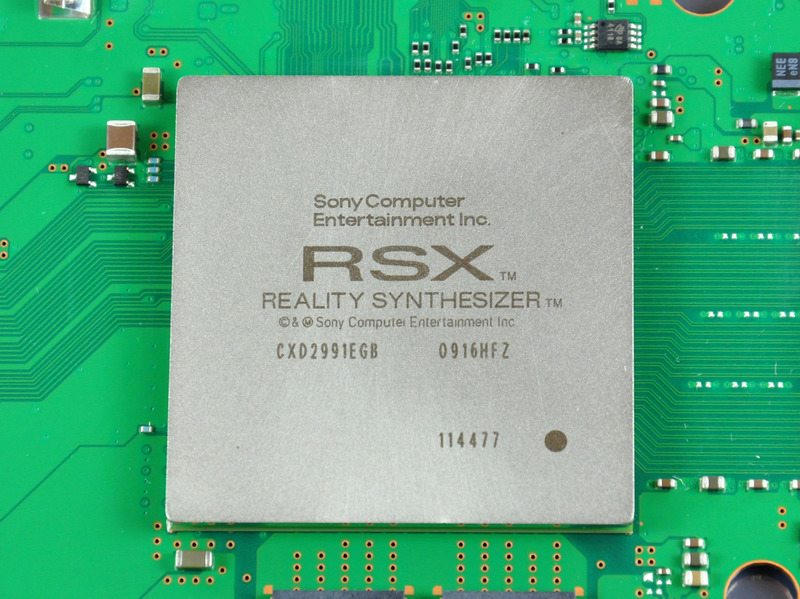

Tan grande era el éxito de Nvidia en el mercado de los videojuegos, que en diciembre de 2004 se anunció que ayudaría a Sony con el diseño del procesador de gráficos RSX de la PlayStation 3, la consola de videojuegos de nueva generación de la firma japonesa que tenía la difícil tarea de repetir el éxito de su predecesora, la más vendida de la historia.

En diciembre de 2006, Nvidia recibió citaciones del Departamento de Justicia de EE. UU con respecto a posibles violaciones antimonopolio en la industria de las tarjetas gráficas. En aquel momento AMD se había convertido en su gran rival, después de la compra de ATI por parte de esta última. Desde entonces AMD y Nvidia han sido los únicos fabricantes de tarjetas gráficas para videojuegos, sin olvidar los chips integrados de Intel.

Forbes nombró a Nvidia como la mejor compañía del año 2007 citando los logros que obtuvo durante los cinco años anteriores. El 5 de enero de 2007, Nvidia anunció que había completado la adquisición de PortalPlayer, Inc, y en febrero de 2008 Nvidia adquirió Ageia, desarrollador del motor de física PhysX y la unidad de procesamiento de física que ejecutaba este motor. Nvidia anunció que planeaba integrar la tecnología PhysX en sus futuros productos de GPU GeForce.

Nvidia se enfrentó a una gran dificultad en julio de 2008, cuando recibió una reducción en sus ingresos de aproximadamente 200 millones luego de informarse que ciertos conjuntos de chips y GPU móviles producidos por la compañía tenían tasas de fallos anormales debido a defectos de fabricación. En septiembre de 2008 Nvidia se convirtió en el sujeto de una demanda colectiva por los afectados, alegando que las GPU defectuosas se habían incorporado a ciertos modelos de portátiles fabricados por Apple, Dell y HP. El culebrón finalizó en septiembre de 2010, cuando Nvidia llegó a un acuerdo por el que se reembolsaría a los propietarios de los portátiles afectados el importe de las reparaciones o, en algunos casos, el reemplazo del producto.

En noviembre de 2011, Nvidia lanzó su sistema de chip ARG Tegra 3 para dispositivos móviles después de presentarlo inicialmente en el Mobile World Congress. Nvidia afirmó que el chip presentaba la primera CPU móvil de cuatro núcleos. En enero de 2013, Nvidia presentó el Tegra 4, así como la Nvidia Shield, una consola de juegos portátil basada en Android que funciona con el nuevo procesador.

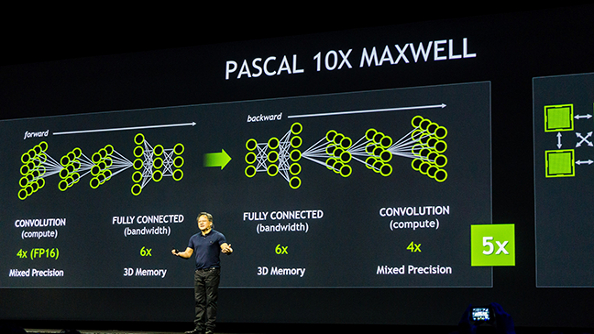

El 6 de mayo de 2016 Nvidia presentó las tarjetas gráficas GeForce GTX 1080 y 1070, las primeras basadas en la microarquitectura Pascal. Nvidia afirmó que ambos modelos superaron a su modelo Titan X basado en Maxwell. Estas tarjetas incorporan memoria GDDR5X y GDDR5 respectivamente, y usan un proceso de fabricación de 16 nm.

El 6 de mayo de 2016 Nvidia presentó las tarjetas gráficas GeForce GTX 1080 y 1070, las primeras basadas en la microarquitectura Pascal. Nvidia afirmó que ambos modelos superaron a su modelo Titan X basado en Maxwell. Estas tarjetas incorporan memoria GDDR5X y GDDR5 respectivamente, y usan un proceso de fabricación de 16 nm.

En mayo de 2017 Nvidia anunció una asociación con Toyota Motor Corp por la cual esta última utilizará la plataforma de inteligencia artificial Drive serie X de Nvidia para sus vehículos autónomos. En julio de 2017 Nvidia y el gigante de búsqueda chino Baidu, Inc. anunciaron una asociación de gran alcance de inteligencia artificial que incluye computación en la nube, conducción autónoma, dispositivos de consumo y el framework de inteligencia artificial de Baidu, PaddlePaddle.

Te recomendamos la lectura del por qué elegir una tarjeta gráfica Nvidia.

Nvidia GeForce y Nvidia Pascal, dominando el gaming

GeForce es la denominación comercial de las tarjetas gráficas basadas en las unidades de procesamiento gráfico (GPU) creadas por Nvidia a partir del año 1999. Hasta la actualidad, la serie GeForce ha conocido dieciséis generaciones desde su creación. Las versiones enfocadas a usuarios profesionales de estas tarjetas vienen bajo la denominación Quadro, e incluyen algunas características diferenciadoras a nivel de controladores. La competencia directa de GeForce es AMD con sus tarjetas Radeon.

GeForce es la denominación comercial de las tarjetas gráficas basadas en las unidades de procesamiento gráfico (GPU) creadas por Nvidia a partir del año 1999. Hasta la actualidad, la serie GeForce ha conocido dieciséis generaciones desde su creación. Las versiones enfocadas a usuarios profesionales de estas tarjetas vienen bajo la denominación Quadro, e incluyen algunas características diferenciadoras a nivel de controladores. La competencia directa de GeForce es AMD con sus tarjetas Radeon.

Pascal es el nombre en clave de la antepenúltima microarquitectura de GPU desarrollada por Nvidia que ha llegado al mercado de los videojuegos, como sucesora de la anterior arquitectura Maxwell. La arquitectura Pascal se presentó por primera vez en abril de 2016 con el lanzamiento de la Tesla P100 para servidores el 5 de abril de 2016. Posteriormente, Pascal se usó principalmente en la serie GeForce 10, siendo las GeForce GTX 1080 y GTX 1070 las primeras tarjetas para videojuegos lanzadas con esta arquitectura, el 17 de mayo de 2016 y el 10 de junio de 2016 respectivamente. Pascal se fabrica utilizando el proceso FinFET de 16nm de TSMC, lo que le permite ofrecer una eficiencia energética y un rendimiento muy superiores en comparación a Maxwell, que se fabricaba a 28 nm FinFET.

La arquitectura Pascal se organiza de forma interna en lo que se conoce como streaming multiprocessor (SM), unas unidades funcionales que están formadas por 64 CUDA Cores, los cuales a su ves se dividen en dos bloques de procesamiento de 32 CUDA Cores cada uno de ellos y acompañados de un búfer de instrucciones, un planificador de warp, 2 unidades de mapeo de texturas y 2 unidades de despacho. Estas unidades SM son las equivalentes a los CU de AMD.

La arquitectura Pascal de Nvidia ha sido diseñada para ser la más eficiente y avanzada del mundo gaming. El equipo de ingenieros de Nvidia ha puesto mucho esfuerzo en crear una arquitectura de GPU que sea capaz de alcanzar unas velocidades de reloj muy elevadas, a la vez que se mantiene un consumo de energía ajustado. Para conseguirlo, se ha optado por un diseño muy cuidado y optimizado en todos sus circuitos, dando como resultado que Pascal es capaz de alcanzar una frecuencia un 40% más elevada que Maxwell, una cifra muy superior a lo que habría permitido el proceso a 16 nm sin todas las optimizaciones a nivel de diseño.

La memoria es un elemento clave en el rendimiento de una tarjeta gráfica, la tecnología GDDR5 fue anunciada en el año 2009, por lo que ya se había quedado obsoleta para las tarjetas gráficas más potentes del momento. Por ello Pascal da soporte a las memorias GDDR5X, el que era el estándar de interfaz de memoria más rápido y avanzado de la historia en el momento del lanzamiento de estas tarjetas gráficas, alcanzando velocidades de transferencia de hasta 10 Gbps. La memoria GDDR5X también permite que la tarjeta gráfica consuma menos energía en comparación con la GDDR5, ya que el voltaje de funcionamiento es de 1,35V, en comparación con los 1,5V o incluso más que necesitan los chips GDDR5 más rápidos. Esta reducción de voltaje se traduce en una frecuencia de funcionamiento un 43% superior con e mismo consumo de energía.

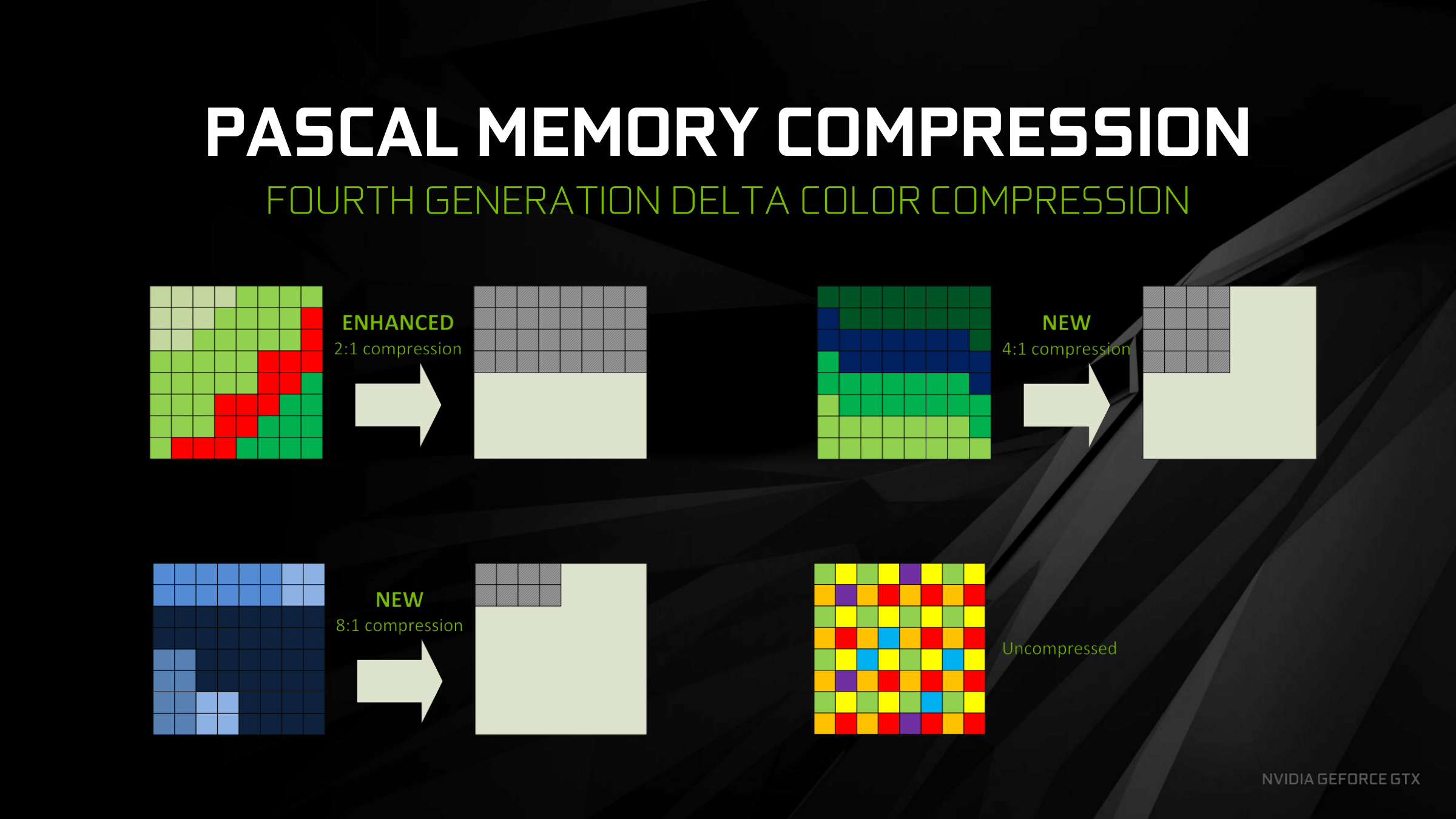

Otra importante innovación de Pascal viene de la mano de las técnicas de compresión de memoria sin perdida de rendimiento, lo que permite reducir la demanda de ancho de banda por parte de la GPU. Pascal incluye la cuarta generación de la tecnología de compresión de color delta. Con la compresión de color delta, la GPU analiza las escenas para calcular los píxeles cuya información puede ser comprimida sin sacrificar la calidad de la escena. Mientras que la arquitectura Maxwell no era capaz de comprimir datos relacionados con algunos elementos, como la vegetación y partes del coche en el juego Project Cars, Pascal es capas de comprimir la mayor parte de la información de estos elementos, siendo así mucho más eficiente que Maxwell. Como consecuencia de ello, Pascal es capaz de reducir significativamente el numero de bytes que tienen que ser extraídos de la memoria. Esta reducción en bytes se traduce en un 20% adicional de ancho de banda efectivo, haciendo que se entregue un aumento de 1.7 veces el ancho de banda con el uso de memorias GDDR5X respecto a las GDDR5 y la arquitectura Maxwell.

Otra importante innovación de Pascal viene de la mano de las técnicas de compresión de memoria sin perdida de rendimiento, lo que permite reducir la demanda de ancho de banda por parte de la GPU. Pascal incluye la cuarta generación de la tecnología de compresión de color delta. Con la compresión de color delta, la GPU analiza las escenas para calcular los píxeles cuya información puede ser comprimida sin sacrificar la calidad de la escena. Mientras que la arquitectura Maxwell no era capaz de comprimir datos relacionados con algunos elementos, como la vegetación y partes del coche en el juego Project Cars, Pascal es capas de comprimir la mayor parte de la información de estos elementos, siendo así mucho más eficiente que Maxwell. Como consecuencia de ello, Pascal es capaz de reducir significativamente el numero de bytes que tienen que ser extraídos de la memoria. Esta reducción en bytes se traduce en un 20% adicional de ancho de banda efectivo, haciendo que se entregue un aumento de 1.7 veces el ancho de banda con el uso de memorias GDDR5X respecto a las GDDR5 y la arquitectura Maxwell.

Pascal también ofrece importantes mejoras en relación con el Computo Asincronico, algo muy importante ya que actualmente las cargas de trabajo son muy complejas. Gracias a estas mejoras la arquitectura Pascal es más eficiente a la hora de repartir la carga entre todas sus diferentes unidades SM, lo que hace que apenas queden núcleos CUDA sin utilizar. Esto permite que la optimización de la GPU sea mucho mayor, haciendo que se aprovechen mejor todos los recursos que tiene.

La siguiente tabla resume las características más importantes de todas las tarjetas GeForce basadas en Pascal.

|

TARJETAS GRÁFICAS NVIDIA GEFORCE PASCAL |

||||||

| CUDA Cores | Frecuencias (MHz) | Memoria | Interfaz de la memoria | Ancho de banda de la memoria (GB/s) | TDP (W) | |

| NVIDIA GeForce GT1030 | 384 | 1468 | 2 GB GDDR5 | 64 bit | 48 | 30 |

| NVIDIA GeForce GTX1050 | 640 | 1455 | 2 GB GDDR5 | 128 bit | 112 | 75 |

| NVIDIA GeForce GTX1050Ti | 768 | 1392 | 4 GB GDDR5 | 128 bit | 112 | 75 |

| NVIDIA GeForce GTX1060 3 GB | 1152 | 1506/1708 | 3 GB GDDR5 | 192 bit | 192 | 120 |

| NVIDIA GeForce GTX1060 6 GB | 1280 | 1506/1708 | 6 GB GDDR5 | 192 bit | 192 | 120 |

| NVIDIA GeForce GTX1070 | 1920 | 1506/1683 | 8 GB GDDR5 | 256 bit | 256 | 150 |

| NVIDIA GeForce GTX1070Ti | 2432 | 1607/1683 | 8 GB GDDR5 | 256 bit | 256 | 180 |

| NVIDIA GeForce GTX1080 | 2560 | 1607/1733 | 8 GB GDDR5X | 256 bit | 320 | 180 |

| NVIDIA GeForce GTX1080 Ti | 3584 | 1480/1582 | 11 GB GDDR5X | 352 bit | 484 | 250 |

| NVIDIA GeForce GTX Titan Xp | 3840 | 1582 | 12 GB GDDR5X | 384 bit | 547 | 250 |

La inteligencia artificial y la arquitectura Volta

Las GPUs de Nvidia son muy utilizadas en los campos relacionados con el deep learning, la inteligencia artificial y el análisis acelerado de grandes cantidades de datos. La compañía desarrolló el aprendizaje profundo basado en la tecnología de GPU, con la finalidad de utilizar la inteligencia artificial para abordar problemas como la detección del cáncer, la predicción del tiempo y los vehículos que conducen de manera autónoma, como los famosos Tesla.

El objetivo de Nvidia es ayudar a las redes a aprender a «pensar«. Las GPUs de Nvidia funcionan excepcionalmente bien para las tareas de aprendizaje profundo porque están diseñadas para computación paralela, y funcionan bien para manejar las operaciones vectoriales y matriciales que prevalecen en el aprendizaje profundo. Las GPUs de la compañía son utilizadas por investigadores, laboratorios, compañías tecnológicas y empresas empresariales. En el año 2009, Nvidia participó en lo que se llamó el big bang del aprendizaje profundo, ya que las redes neuronales de aprendizaje profundo se combinaron con las unidades de procesamiento de gráficos de la compañía. Ese mismo año, Google Brain utilizó las GPUs de Nvidia para crear redes neuronales profundas capaces de aprendizaje automático, donde Andrew Ng determinó que podrían aumentar la velocidad de los sistemas de aprendizaje profundo unas 100 veces.

El objetivo de Nvidia es ayudar a las redes a aprender a «pensar«. Las GPUs de Nvidia funcionan excepcionalmente bien para las tareas de aprendizaje profundo porque están diseñadas para computación paralela, y funcionan bien para manejar las operaciones vectoriales y matriciales que prevalecen en el aprendizaje profundo. Las GPUs de la compañía son utilizadas por investigadores, laboratorios, compañías tecnológicas y empresas empresariales. En el año 2009, Nvidia participó en lo que se llamó el big bang del aprendizaje profundo, ya que las redes neuronales de aprendizaje profundo se combinaron con las unidades de procesamiento de gráficos de la compañía. Ese mismo año, Google Brain utilizó las GPUs de Nvidia para crear redes neuronales profundas capaces de aprendizaje automático, donde Andrew Ng determinó que podrían aumentar la velocidad de los sistemas de aprendizaje profundo unas 100 veces.

En abril de 2016, Nvidia introdujo el superordenador DGX-1 basado en un clúster de 8 GPUs para mejorar la capacidad de los usuarios de utilizar el aprendizaje profundo mediante la combinación de GPU con software específicamente diseñado. Nvidia también desarrolló las máquinas virtuales Nvidia Tesla K80 y P100 basadas en GPU, disponibles a través de Google Cloud, que Google instaló en noviembre de 2016. Microsoft agregó servidores basados en la tecnología de GPU de Nvidia en una presentación preliminar de su serie N, basada en la tarjeta Tesla K80. Nvidia también se asoció con IBM para crear un kit de software que aumenta las capacidades de IA de sus GPUs. En 2017, las GPUs de Nvidia también se pusieron en línea en el Centro RIKEN para el Proyecto de Inteligencia Avanzada para Fujitsu.

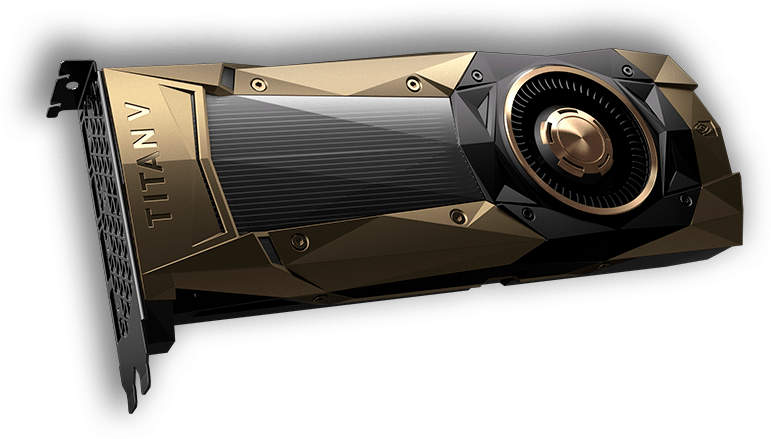

Volta es el nombre en clave de la microarquitectura de GPU más avanzada que ha desarrollado Nvidia, es la arquitectura sucesora de Pascal y se anunció como parte de una ambición de hoja de ruta futura en marzo de 2013. La arquitectura lleva el nombre de Alessandro Volta, el físico, químico e inventor de la batería eléctrica. La arquitectura Volta no ha llegado al sector del gaming, aunque si lo ha hecho con la tarjeta gráfica Nvidia Titan V, enfocada al sector de consumo y que también puede ser usada en equipos para jugar.

Esta Nvidia Titan V es una tarjeta gráfica basada en el núcleo GV100 y tres stacks de memoria HBM2, todo en un mismo paquete. La tarjeta cuenta con un total de 12 GB de memoria HBM2 que funciona a través de una interfaz de memoria de 3072 bits. Su GPU contiene más de 21 millones de transistores, 5120 núcleos CUDA y 640 núcleos Tensor para ofrecer un rendimiento de 110 TeraFLOPS en aprendizaje profundo. Sus frecuencias de funcionamiento son de 1200 MHz de base y 1455 MHz en modo turbo, mientras que la memoria funciona a 850 MHz, ofreciendo un ancho de banda de 652.8 GB/s. Recientemente se ha anunciado una versión CEO Edition que aumenta la memoria hasta 32 GB.

La primera tarjeta gráfica fabricada por Nvidia con la arquitectura Volta fue la Tesla V100, la cual forma parte del sistema Nvidia DGX-1. La Tesla V100 hace uso del núcleo GV100 que fue lanzado el 21 de junio de 2017. La GPU Volta GV100 está construida en un proceso de fabricación a 12 nm FinFET, con 32 GB de memoria HBM2 que son capaces de ofrecer hasta 900 GB/s de ancho de banda.

La primera tarjeta gráfica fabricada por Nvidia con la arquitectura Volta fue la Tesla V100, la cual forma parte del sistema Nvidia DGX-1. La Tesla V100 hace uso del núcleo GV100 que fue lanzado el 21 de junio de 2017. La GPU Volta GV100 está construida en un proceso de fabricación a 12 nm FinFET, con 32 GB de memoria HBM2 que son capaces de ofrecer hasta 900 GB/s de ancho de banda.

La arquitectura Volta se caracteriza por ser la primera en incluir los Tensor Core, unos núcleos especialmente diseñados para ofrecer un rendimiento muy superior en tareas de aprendizaje profundo respecto a los núcleos CUDA regulares. Un Tensor Core es una unidad que multiplica dos matrices FP16 4 × 4 y luego agrega una tercera matriz FP16 o FP32 al resultado, utilizando operaciones fusionadas de suma y multiplicación, obteniendo un resultado FP32 que podría degradarse opcionalmente a un resultado FP16. Los núcleos Tensor están destinados a acelerar el entrenamiento de redes neuronales.

Volta también destaca por incluir la avanzada interfaz propietaria NVLink, la cual es un protocolo de comunicaciones desarrollado por Nvidia como sucesor de SLI, que se puede usar para transferencias de códigos de datos y control en sistemas de procesadores basados en CPU y GPU y en aquellos basados únicamente en GPU. NVLink especifica una conexión punto a punto con velocidades de datos de 20 y 25 Gb/s por carril de datos y por dirección en sus versiones primera y segunda. Las tasas de datos totales en los sistemas del mundo real son 160 y 300 GB/s para la suma total del sistema de flujos de datos de entrada y salida. Los productos NVLink introducidos hasta la fecha se centran en el espacio de aplicaciones de alto rendimiento, y pese a que se introdujeron en las gráficas gaming su uso está quedando cada vez más restringido.

La siguiente tabla resume las características más importantes de las tarjetas basadas en Volta:

|

TARJETAS GRÁFICAS NVIDIA VOLTA |

||||||||

| CUDA Cores | Tensor Core | Frecuencias (MHz) | Memoria | Interfaz de la memoria | Ancho de banda de la memoria (GB/s) |

TDP (W) |

||

| Tesla V100 | 5120 | 640 | 1465 | 32 GB HBM2 | 4.096 bit | 900 | 250 | |

| GeForce Titan V | 5120 | 640 | 1200/1455 | 12 GB HBM2 | 3.072 bit | 652 | 250 | |

| GeForce Titan V CEO Edition | 5120 | 640 | 1200/1455 | 32 GB HBM2 | 4.096 bit | 900 | 250 | |

NVIDIA Turing y la apertura a un mercado totalmente nuevo con RTX

Tras el éxito de Pascal, en 2018 NVIDIA lanzó Turing, una nueva arquitectura gráfica que básicamente revolucionó todo el panorama de las tarjetas gráficas, gracias a la introducción de RTX. Básicamente, NVIDIA trajo al mercado por primera vez las tecnologías de trazado de rayos en tiempo real, y lo han combinado con tecnologías realmente interesantes y rompedoras que te detallaremos a continuación.

El ray tracing es una técnica de iluminación fundamental en el mundo de la animación 3D, prácticamente cualquier imagen generada por ordenador que quiera ser ultrarrealista debería usar esta tecnología, que se basa simplemente en el trazado de una gran cantidad de rayos desde las fuentes de luz, analizando el rebote de cada uno hacia el observador, y pudiendo así dar unas luces, reflejos y sombras acordes con la realidad.

Como te decimos, esta técnica lleva años usándose, y de hecho apareció en los 70. ¿Entonces qué tiene de especial RTX? Muy sencillo: el ray tracing requiere de un gran esfuerzo a nivel de cómputo, y por ello hasta el momento no veíamos implementaciones complejas en tiempo real. Es decir, allí donde se usaba el ray tracing era en películas, vídeos, etc… vamos, contenidos renderizados de antemano. Un videojuego se renderiza en tiempo real, y ahí el trazado de rayos era inviable. Hasta que llegó NVIDIA RTX, que habilitó características de hardware específicas para empezar a soportarlo en juegos.

En vez del ray tracing, los juegos usaban y siguen usando técnicas de rasterización. NVIDIA marcó una revolución introduciéndolo y tanto las gráficas AMD como las consolas de nueva generación la han seguido.

Te recomendamos la lectura de nuestro artículo sobre qué es el ray tracing.

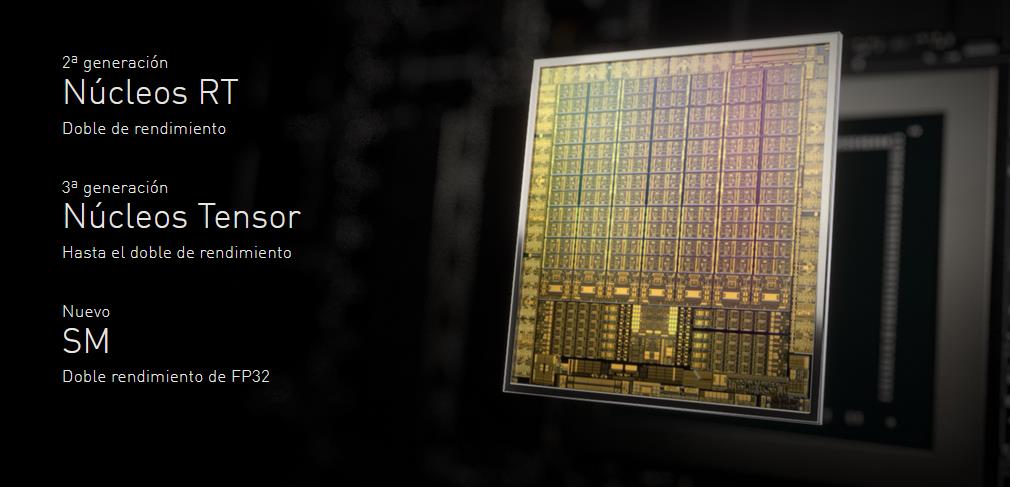

Los dos grandes protagonistas de Turing son los nuevos tipos de núcleos que se incluyen. A los tradicionales CUDA Cores se le añaden dos fundamentales:

- RT Cores: allí ocurre toda la magia del ray tracing en tiempo real, pues son los que aceleran este proceso. Básicamente, implementan de manera eficiente las operaciones necesarias para calcular los reflejos e iluminaciones del ray tracing. Son totalmente nuevos, y por ende constituyen la primera generación de este tipo de núcleo.

- Tensor Cores: en este caso estamos hablando de una segunda generación respecto a los incluidos en Volta.

Pero estos dos tipos de núcleos no se hacen relevantes por arte de magia, sino que tienen que estar debidamente aprovechados en el desarrollo de las aplicaciones y videojuegos. ¿Lo han conseguido?

Ray Tracing y DLSS, dos de las innovaciones más importantes de los últimos años

Con la llegada de NVIDIA Turing, la compañía pasó a aprovechar muy bien las posibilidades de los nuevos RT Cores y los Tensor Cores introducidos, con la llegada de su implementación del ray tracing y la tecnología DLSS.

Mayormente, el nuevo ray tracing en tiempo real para los juegos funciona bajo la API DirectX Ray Tracing (DXR), lanzada por Microsoft como fruto de una colaboración con Nvidia. De esta forma, todos los juegos que ya ejecutaban dicha API (es decir, la mayoría de títulos) podían adaptarse con cierta facilidad e integrar esta tecnología, que desde el principio dio buenos frutos en realismo:

Algunos de los títulos destacados que soportan RTX actualmente son los siguientes:

- Cyberpunk 2077

- Fortnite

- Minecraft para Windows 10 (a algunos os sorprenderá, pero es una de las implementaciones de Ray Tracing más impresionantes que hay)

- Watch Dogs: Legion.

- Call of Duty: Modern Warfare

- Control

- Wolfenstein: Youngblood

- Vampire: The Masquerade – Bloodlines 2

- Synced Off-Planet

- Dying Light 2

- Quake 2 RTX

- Mechwarrior 5: Mercenaries

- Deliver Us The Moon

- Justice

- Atomic Heart

- Battlefield V

- Metro Exodus

- Shadow of the Tomb Raider

- Final Fantasy XV

La cuestión es que, por mucho que se acelere con RT Cores, las técnicas de trazado de rayos no dejan de ser tremendamente demandantes. Por este motivo, cuando hablamos de RTX no solo nos referimos a ray tracing, sino que incluimos también a la nueva tecnología DLSS.

Deep Learning Super Sampling o DLSS es también una innovación impresionante en el mercado de las tarjetas gráficas y el gaming. Básicamente, es una tecnología de reescalado inteligente que permite que la gráfica renderice a una resolución inferior a la que luego se muestra por pantalla, pero sin apenas pérdidas de calidad visual.

A diferencia de un reescalado normal, DLSS aprovecha los tensor cores para ejecutar algoritmos de inteligencia artificial que son capaces de «rellenar» todos los píxeles que faltan con precisión. Esto se consigue gracias a que cada juego que soporta DLSS se entrena específicamente mediante algoritmos de deep learning en superordenadores. Así, nosotros podríamos estar viendo a 4K sin apenas notar diferencias un juego que en realidad se está renderizando a 1440p o 1080p.

Con DLSS, el rendimiento no solo aumenta de manera tremenda, sino que a veces puede llegar a sacar imágenes incluso mejores. Muchas veces, con este tipo de cosas tenemos que lidiar con conceptos de márketing poco importantes en la práctica. Pero el DLSS es realmente una innovación brutal, y un apoyo fundamental para que el ray tracing funcione bien en juegos, ya que por mucho que se usen RT Cores el lastre al rendimiento es muy grande cuando lo activamos.

NVIDIA Ampere, un paso más allá

Dos años después del lanzamiento inicial de RTX, NVIDIA anunció la segunda arquitectura con esta tecnología, denominada Ampere. Esta supuso básicamente un gran aumento del rendimiento ofrecido, tanto de los CUDA Cores normales como de los Tensor Cores y los RT Cores.

Dos años después del lanzamiento inicial de RTX, NVIDIA anunció la segunda arquitectura con esta tecnología, denominada Ampere. Esta supuso básicamente un gran aumento del rendimiento ofrecido, tanto de los CUDA Cores normales como de los Tensor Cores y los RT Cores.

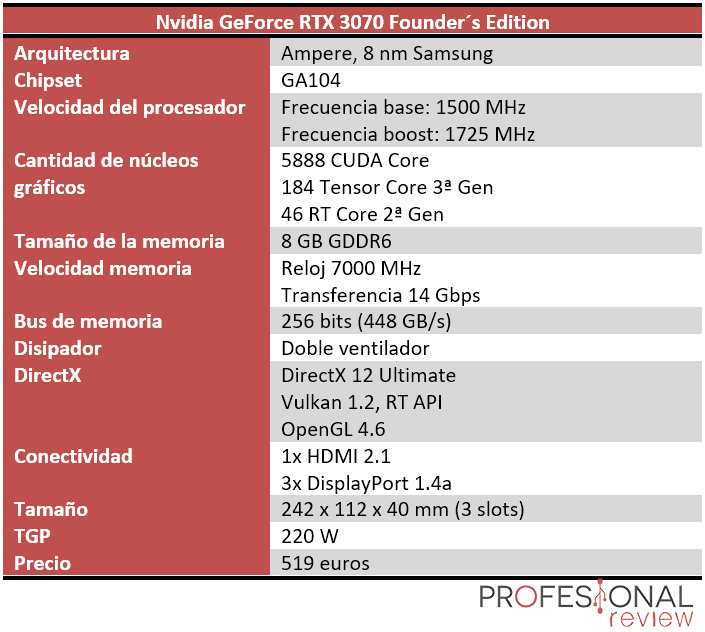

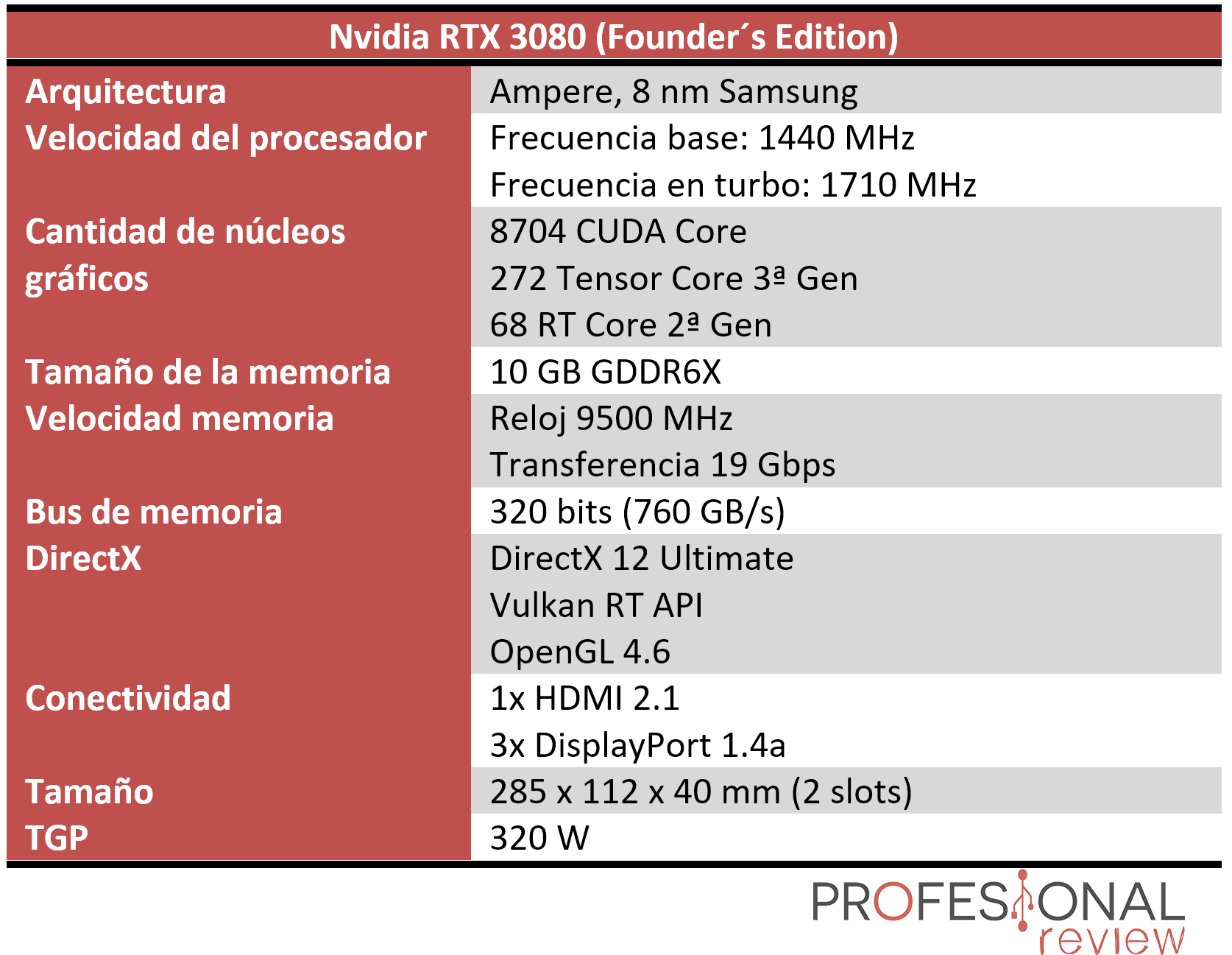

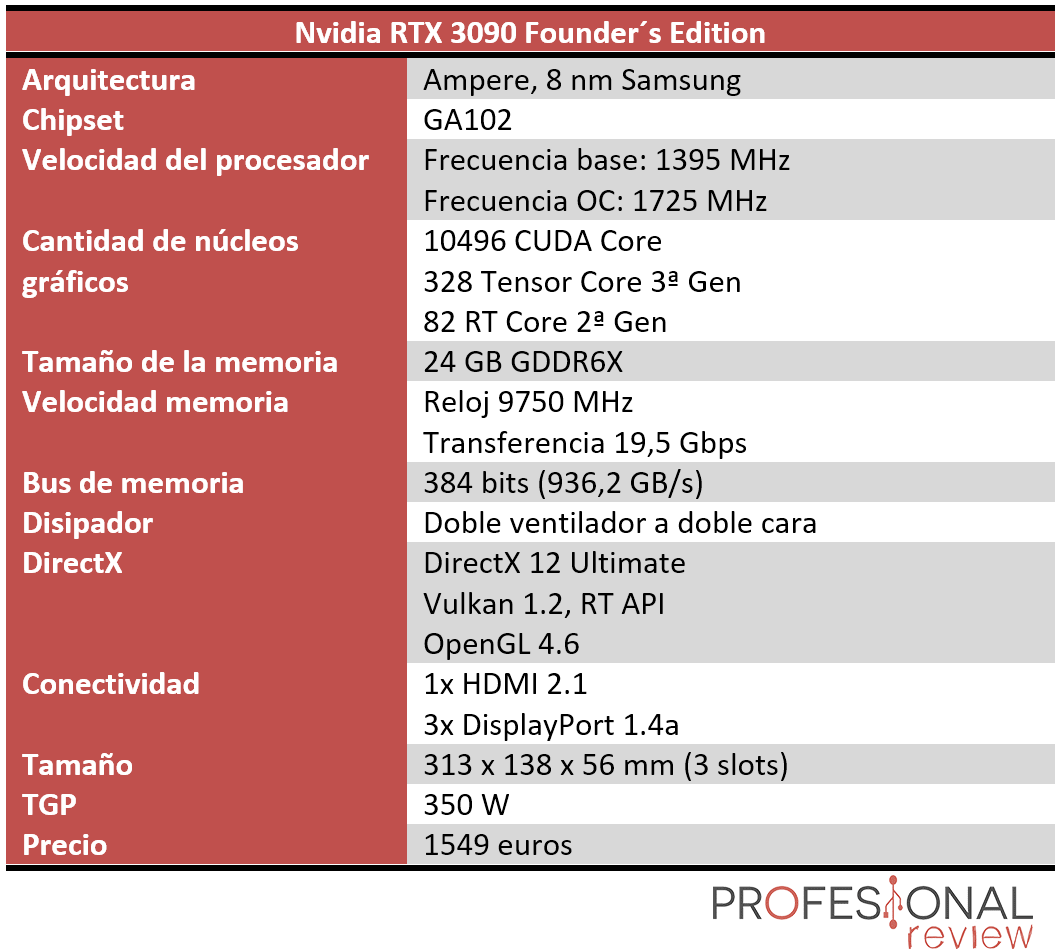

La nueva generación trajo tres grandes bestias, como son las RTX 3090, 3080 y 3070, de las que os dejamos sus especificaciones técnicas:

La nueva generación trajo tres grandes bestias, como son las RTX 3090, 3080 y 3070, de las que os dejamos sus especificaciones técnicas:

Estas marcaron nuevos estándares de lo que es el alto rendimiento, y supusieron conseguir por fin que el gaming a 4K 60fps Ultra fuese una realidad palpable, con la RTX 3080 haciendo posible un gran rendimiento a esta resolución, algo que también ocurre con la 3070, aunque esta última es más bien la reina del 1440p 144fps.

Respecto a la 3090, su aumento de precio es mucho mayor que el de características frente a la 3080, pero se convirtió rápidamente en una excelente referencia para usuarios que necesitaban aprovechar su potencia bruta y cantidad de memoria en, por ejemplo, trabajos de inteligencia artificial.

NVIDIA Ada Lovelace, la propuesta para 2023 y 2024

A finales de 2022 llega Ada Lovelace, la arquitectura que marcará su hoja de ruta para 2023 y 2024, pues no se espera un sucesor hasta Ada Lovelace Next en 2025. Y es que con ella llega la RTX 4090, una tarjeta gráfica prácticamente imposible de batir para AMD y que viene acompañada de más y mejores tecnologías.

Échale un ojo a nuestras reviews y comparativas de dicha generación:

- RTX 4090 vs 3090 vs 3080 Ti ¿Merece la pena el cambio?

- RTX 4080 vs RTX 4090 vs RTX 3080 Ti: Comparativa definitiva

- Nvidia RTX 4090 Review en Español (Análisis completo)

- Nvidia RTX 4080 Review en Español (Análisis completo)

- Nvidia RTX 4060 Ti 16GB Review en Español (Análisis completo)

Y descubre las tecnologías como DLSS 3 y Frame Generation que tanto sorprenden.

Otras tecnologías fundamentales de NVIDIA

Vamos a ver más tecnologías de software que, al igual que DLSS, son o han sido fundamentales en el avance de la compañía en los últimos años, y que atraen a tantos jugadores.

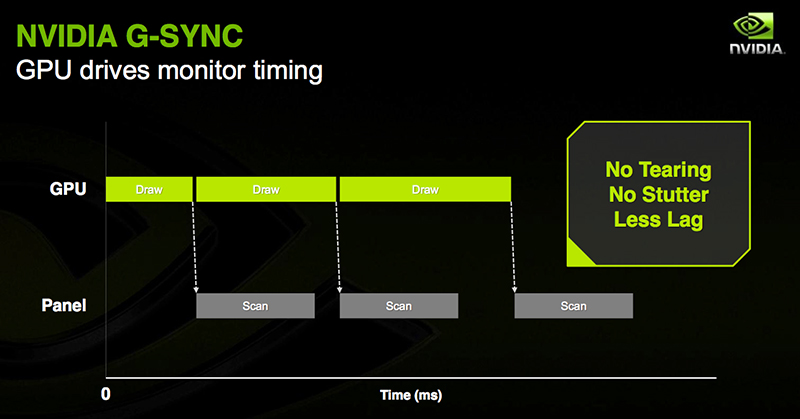

NVIDIA G-Sync, acabando con los problemas de sincronización de imagen

G-Sync es una tecnología patentada de sincronización adaptativa desarrollada por Nvidia, cuyo objetivo principal es eliminar el tearing de la pantalla y la necesidad de alternativas en forma de software como Vsync. G-Sync elimina el tearing de la pantalla al forzar que esta que se adapte al framerate del dispositivo de salida, la tarjeta gráfica, en lugar de que el dispositivo de salida se adapte a la pantalla, lo que resulta en rotura de la imagen en la pantalla.

Para que un monitor sea compatible con G-Sync, debe contener un módulo de hardware vendido por Nvidia. AMD ha lanzado una tecnología similar para pantallas, llamada FreeSync, que tiene la misma función que G-Sync pero no requiere de ningún hardware específico.

G-Sync se ha enfrentado a algunas críticas debido a su naturaleza patentada, y al hecho de que todavía se promueve cuando existen alternativas libres, como el estándar VESA Adaptive-Sync, que es una característica opcional de DisplayPort 1.2a. Mientras que FreeSync de AMD se basa en DisplayPort 1.2a, G-Sync requiere un módulo hecho en Nvidia en lugar del escalador habitual en la pantalla para que funcione correctamente las tarjetas gráficas Nvidia GeForce, siendo compatible con las microarquitecturas Kepler, Maxwell, Pascal y Volta.

G-Sync se ha enfrentado a algunas críticas debido a su naturaleza patentada, y al hecho de que todavía se promueve cuando existen alternativas libres, como el estándar VESA Adaptive-Sync, que es una característica opcional de DisplayPort 1.2a. Mientras que FreeSync de AMD se basa en DisplayPort 1.2a, G-Sync requiere un módulo hecho en Nvidia en lugar del escalador habitual en la pantalla para que funcione correctamente las tarjetas gráficas Nvidia GeForce, siendo compatible con las microarquitecturas Kepler, Maxwell, Pascal y Volta.

Como resultado de estas críticas, NVIDIA dio un nuevo enfoque a G-Sync, empezando a dar soporte al mismo estándar de VESA que empleaba la tecnología abierta AMD FreeSync, dejando así de requerir la cara implementación por hardware del G-Sync tradicional.

Así, el G-Sync tal y como lo conocíamos pasó a ser G-Sync Ultimate, y el nuevo y más barato se llama G-Sync Compatible. Aprende sus diferencias aquí.

NVIDIA NVENC, el codificador propio de la compañía

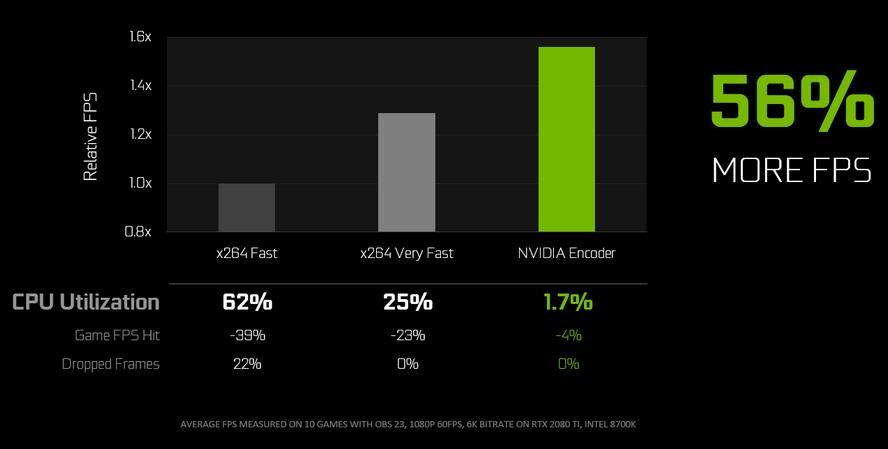

Cuando estamos hablando de renderización de vídeo o streaming de videojuegos, hay un aspecto clave: el encoder o codificador que usemos, que será básicamente lo que produzca la salida en un formato de vídeo reproducible, o permita que veamos un vídeo en directo, con los códecs y formatos adecuados.

Dentro de este contexto, podemos usar encoders por software que usan toda la potencia de nuestra CPU para ello, algo que ha sido la apuesta más habitual en los últimos años, o emplear un encoder por hardware, que aproveche la aceleración por GPU. NVENC es la solución de NVIDIA a esta cuestión.

Dentro de este contexto, podemos usar encoders por software que usan toda la potencia de nuestra CPU para ello, algo que ha sido la apuesta más habitual en los últimos años, o emplear un encoder por hardware, que aproveche la aceleración por GPU. NVENC es la solución de NVIDIA a esta cuestión.

NVIDIA NVENC es un avance impresionante en las tecnologías de codificación.

Por ejemplo, si hablamos de renderización y exportación de vídeo, tenemos que el uso de NVENC supone hasta 3 veces mejor rendimiento y rapidez respecto a la aceleración por software. A esto le hay que sumar que este encoder propietario es bastante mejor que otras alternativas abiertas como el uso de OpenCL, básicamente gracias a que aprovechan toda la tecnología CUDA de NVIDIA al máximo.

Esto es tan importante o más en streaming de videojuegos, por un motivo muy sencillo: cuando retransmites un juego con encoding por software tienes que lidiar con un gran aumento de la carga de la CPU. Esto no es un problema al renderizar un vídeo, pero es que aquí estás generando el propio contenido al tiempo que lo retransmites, y un gran estrés de la CPU puede afectar gravemente a la fluidez. El interés de NVENC está en que su impacto en el rendimiento de los juegos es realmente pequeño.

Según datos de la propia compañía, medidos en 10 juegos distintos, NVENC reduce al mínimo la carga de la CPU a la vez que consigue dar un 56% menos de FPS, sin suponer una mala calidad del streaming.

Según datos de la propia compañía, medidos en 10 juegos distintos, NVENC reduce al mínimo la carga de la CPU a la vez que consigue dar un 56% menos de FPS, sin suponer una mala calidad del streaming.

Reflex, Studio y Omniverse Machinima

Lo último de NVIDIA en cuanto a tecnologías propias ha sido Reflex, enfocada en la reducción del retardo existente entre que clicamos el ratón y vemos los cambios en la pantalla (fundamental en juegos), Omniverse Machinima, una poderosa herramienta para crear historias animadas de juegos, o su suite NVIDIA Broadcast, que incluye innovaciones realmente interesantes en el ámbito de la cancelación de ruido:

Finalmente, podríamos mencionar a RTX I/O, pero no es más que una implementación de DirecStorage de Microsoft.

Otra tecnología muy especial es sin duda NVIDIA GeForce NOW, que te permite jugar en la nube sin necesidad de una tarjeta gráfica potente y se ha demostrado muy capaz.

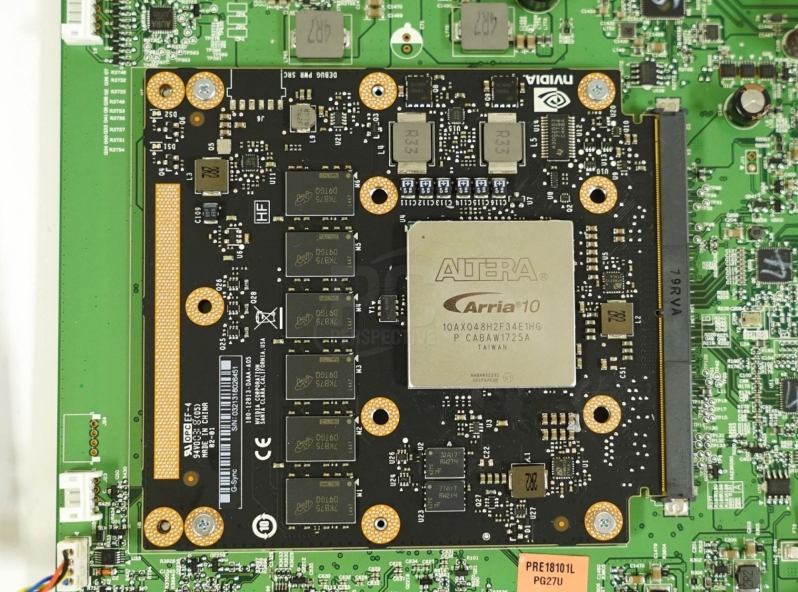

NVIDIA Mellanox, su entrada en el mercado de las redes

En 2019, NVIDIA compró Mellanox, una importante compañía desarrolladora de productos de red, cuyas soluciones de conectividad son realmente especiales para centros de datos: sobre todo de cara a la interconexión entre servidores que tienen que transferirse una gran cantidad de información, y sobre todo hacerlo lo suficientemente rápido para no resultar en un lastre o cuello de botella, y es que van a pasar entre distintos procesos de procesamiento entre todas esas máquinas.

En 2019, NVIDIA compró Mellanox, una importante compañía desarrolladora de productos de red, cuyas soluciones de conectividad son realmente especiales para centros de datos: sobre todo de cara a la interconexión entre servidores que tienen que transferirse una gran cantidad de información, y sobre todo hacerlo lo suficientemente rápido para no resultar en un lastre o cuello de botella, y es que van a pasar entre distintos procesos de procesamiento entre todas esas máquinas.

La adquisición de esta compañía le ha salido muy rentable a NVIDIA, pues sus productos suponen casi un tercio de los ingresos que reciben en el segmento de los centros de datos.

‘Boom’ económico tras la llegada de la pandemia

Con la llegada de la pandemia de coronavirus, muchas empresas se vieron fuertemente impactadas, pero en el segmento tecnológico ha habido casos totalmente contrarios. Para NVIDIA supuso que sus ingresos se viesen disparados: ante los retos computacionales que ha traído, el aumento del uso de servicios de trabajo remoto y el mayor uso en general tanto de internet como de los PCs en sí ha provocado un notable aumento en la demanda de GPU para servidores y ordenadores.

Concretamente, mientras que NVIDIA llevaba desde el tercer trimestre de 2019 rondando los 3000 millones de dólares en ingresos, en el segundo trimestre de 2020 pasaron a más de 3800, y más de 4700 en el tercero. Esto deja claras las dimensiones de su boom empresarial.

Concretamente, mientras que NVIDIA llevaba desde el tercer trimestre de 2019 rondando los 3000 millones de dólares en ingresos, en el segundo trimestre de 2020 pasaron a más de 3800, y más de 4700 en el tercero. Esto deja claras las dimensiones de su boom empresarial.

Los usuarios domésticos han demandado muchas GPUs para jugar, los profesionales para teletrabajar, y todos ellos se han conectado muchísimo más a Internet, así que se necesitaron muchas más GPU en servidores. ¡Qué chollo para NVIDIA!

NVIDIA también domina con la inteligencia artificial

Primero vino la pandemia, luego vino otro boom de la minería de criptomonedas… y cuando parecía que NVIDIA volvería a una situación de normalidad, llegó el boom de la inteligencia artificial. Al final nos quedó una moraleja clara: para esta compañía, la normalidad es seguir aumentando ingresos y beneficios sin parar.

| Resultados financieros de NVIDIA en el Q2 2023 | |||||

| Q2 2023 | Q1 2023 | Q2 2022 | intertrimestral | interanual | |

| Ingresos | $13.5B | $7.2B | $6.7B | 88% | 101% |

| Margen bruto | 70.1% | 64.6% | 43.5% | +5.5ppt | +26.6ppt |

| Margen de explotación | $6.8B | $2.1B | $499M | 218% | 1263% |

| Beneficio neto | $6.1B | $2.0B | $656M | 203% | 843% |

| Beneficios por acción | $2.48 | $0.82 | $0.26 | 202% | 854% |

Así, los beneficios de NVIDIA gracias a la IA se dispararon en 2023, multiplicándose por 8, al igual que sus ingresos, que se duplicaron. Alcanzaron en un trimestre tanto beneficio neto como ingresos totales en el mismo período de 2022. ¡Brutal!

| Ingresos por plataformas en el Q2 2023 | |||||

| Q2 2023 | Q1 2023 | Q2 2022 | intertrimestral | interanual | |

| Centros de datos | $10,323M | $4,284M | $3,806M | 141% | 171% |

| Gaming | $2,486M | $2,240M | $2,042M | 11% | 21% |

| Visualización profesional | $379M | $295M | $496M | 28% | -24% |

| Automoción | $253M | $296M | $220M | -15% | 15% |

| OEM & IP | $66M | $77M | $140M | -14% | -53% |

Precisamente, todo viene de la necesidad de millones de tarjetas gráficas para alimentar todas las necesidades con modelos de lenguaje natural y procesamiento de imágenes como los que encontramos en ChatGPT, Bing Chat o Google Bard, y en los que todas las empresas se interesan.

El camino de avance hacia las DPU

NVIDIA en el mundo de la nube también está avanzando hacia las DPU o Data Processing Unit, chips que entre otras cosas integrarán una CPU basada en Arm. Se trata básicamente de soluciones que integran conectividad avanzada (volvemos a hablar de Mellanox), almacenamiento y servicios de seguridad pensadas con claridad y específicamente en los servidores.

NVIDIA en el mundo de la nube también está avanzando hacia las DPU o Data Processing Unit, chips que entre otras cosas integrarán una CPU basada en Arm. Se trata básicamente de soluciones que integran conectividad avanzada (volvemos a hablar de Mellanox), almacenamiento y servicios de seguridad pensadas con claridad y específicamente en los servidores.

Este invento de NVIDIA está fuertemente destinado a la computación cloud, donde la combinación tradicional de CPU x86 y GPU se queda algo corta, y con la inteligencia artificial, el machine learning y el big data, que son mucho más que conceptos de márketing, llegan nuevas necesidades de procesamiento cruciales.

Una compañía con un futuro sólido y potente

En vista de todo lo expuesto, queda claro que NVIDIA tiene un futuro claro, sólido, potente e interesante en el mercado de la computación. Lleva tiempo demostrando que la competencia de Intel y AMD les hace poco daño, y no para de sorprender a todos en el mercado de las GPU y sus demás áreas de negocio.

Pero no todo han sido rosas en este camino: por el medio se quedó la fallida compra de Arm, bloqueada por los reguladores para evitar la formación de una corporación tan grande que se convierta en un peligroso monopolio.

Aquí finaliza nuestro post sobre todo lo que tiene que saber de Nvidia. Recuerda que puedes compartirlo en las redes sociales para que llegue a más usuarios. También puedes dejar un comentario si tienes alguna sugerencia o algo que añadir.