La memoria HBM surgió como una alternativa a la RAM en algunos casos, especialmente para la GDDR. Poco a poco ha ido progresando con nuevas generaciones, y ahora todos estamos pendientes de lo que será la futura HBM4, con grandes mejoras que te mostraremos aquí, tanto lo que se conoce como lo que se espera de ella.

Índice de contenidos

HBM4 lista para producción en masa

Samsung busca liderar el mercado de la próxima generación de memorias HBM4 al finalizar el diseño de esta tecnología de vanguardia para finales de 2025. Una memoria que ya estaba estandarizada por JEDEC y que ahora son los fabricantes como Micron Technology, SK Hynix y la propia Samsung las encargadas de evolucionar estos productos.

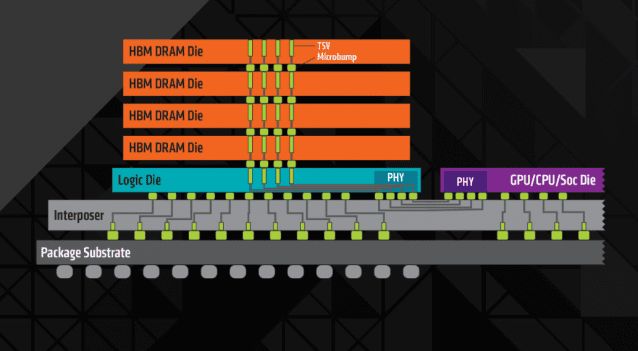

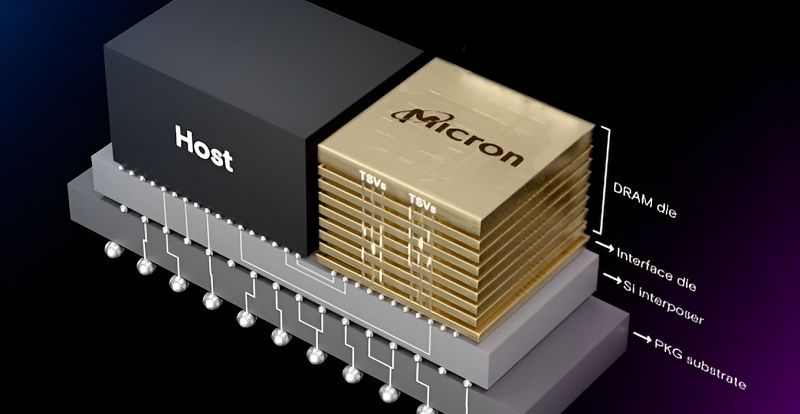

A principios de este año, SK hynix y TSMC anunciaron una colaboración para desarrollar dies base HBM4. Más tarde, en el European Technology Symposium 2024, TSMC confirmó que utilizaría sus tecnologías de proceso 12FFC+ (12 nm) y N5 (5 nm) para fabricar estos dies. El proceso N5 de TSMC permite una lógica más integrada y características con distancias de interconexión de 9 a 6 micras, lo que es crucial para la integración en el chip. El proceso 12FFC+, derivado de la tecnología 16nm FinFET de TSMC, permitirá la producción de dies base rentables que conectan la memoria con los procesadores host mediante interposers de silicio.

Unos chips de memoria que serán fundamentales para los futuros aceleradores para IA, como el AMD Instinct MI400 o el NVIDIA Rubin, ya que el amplio ancho de banda que ofrecen estas memorias es vital para este tipo de cargas de trabajo, ya que la inteligencia artificial necesita gran cantidad de accesos de forma simultánea, y la HBM los puede satisfacer mejor que otras memorias como las DDR.

Por tanto, podemos esperar un buen salto en el rendimiento de las aplicaciones de IA basadas en la nube, que serán las que se nutran de estas mejoras de hardware, no solo de las mejoras de las nuevas arquitecturas de los aceleradores, también de esta nueva HBM4. Así que, será una vuelta de tuerca más para servicios como Copilot, Gemini, ChatGPT, etc.

También te puede interesar conocer los mejores módulos de RAM actuales

Especificaciones de la HBM4

JEDEC ya publicó las especificaciones para la cuarta generación de memoria DRAM de alto ancho de banda (HBM4). Lo que sabemos por ahora es:

- Admite una interfaz de 2048 bits por pila a pesar de una tasa de transferencia de datos más baja que HBM3E.

- HBM4 soporta más amplia de capas de memoria para que la nueva memoria pueda conseguir mayores capacidades. El nuevo estándar HBM4 especificará chips de 24 Gb y 32 Gb y ofrecerá configuraciones para pilas TSV de 4, 8, 12 y 16 capas.

- Se han acordado velocidades iniciales de hasta 6.4 GT/s, con discusiones en curso sobre la posibilidad de alcanzar una tasa de transferencia de datos aún más alta.

- Una pila de 16 capas basada en capas de 32 Gb ofrecerá una capacidad de 64 GB, lo que significa que un procesador con cuatro módulos de memoria puede admitir 256 GB de memoria con un ancho de banda máximo de 6.56 TB/s utilizando una interfaz de 8192 bits.

- Aunque HBM4 contará con un doble número de canales por pila en comparación con HBM3 y una huella física más grande para garantizar la compatibilidad, un solo controlador puede funcionar con HBM3 y HBM4. Sin embargo, se necesitarán diferentes interposers para acomodar las diferentes especificaciones.

- Por el momento, JEDEC ha comunicado nada sobre la integración directa de la memoria HBM4 en los mismos empaquetados de los procesadores (Single HBM-GPU chip), y esa es quizás la parte más intrigante de este nuevo tipo de memoria, aunque seguramente se permita.

HBM4 está diseñado principalmente para satisfacer las demandas de la inteligencia artificial generativa y la computación de alto rendimiento, que requieren manejar grandes conjuntos de datos y realizar cálculos complejos de manera eficiente. Por lo tanto, es poco probable que veamos HBM4 en aplicaciones para clientes, como tarjetas gráficas.

¿Qué esperar?

Dada la mejora en cuanto a capacidades, y al ancho de banda duplicado por primera vez de los 1024-bit de la HBM-HBM3E, a los 2048-bit en la HBM4, esto permitirá un enorme salto en el rendimiento para cargas de trabajo donde se necesiten gran cantidad de accesos simultáneos, como es el caso de la IA. En definitiva, mayor capacidad y escalabilidad, menor latencia, mejor eficiencia energética y mayor velocidad se traducen en:

- Acelera el entrenamiento de modelos: los modelos de IA requieren procesar grandes cantidades de datos durante el entrenamiento. Un mayor ancho de banda permite alimentar los modelos con datos más rápidamente, reduciendo significativamente el tiempo de entrenamiento. Eso es modelos más inteligentes y maduros en menor tiempo.

- Mejora la inferencia: la inferencia, es decir, el proceso de usar un modelo entrenado para hacer predicciones, también se beneficia del alto ancho de banda. Al poder acceder a los datos del modelo y los datos de entrada de manera más rápida, se obtienen resultados más rápidos.

- Facilita el procesamiento de datos de gran tamaño: las aplicaciones de IA a menudo trabajan con conjuntos de datos masivos. Un ancho de banda elevado permite cargar y procesar estos grandes conjuntos de datos de forma más eficiente, evitando cuellos de botella.

- Admite modelos más grandes y complejos: los modelos de IA cada vez son más grandes y complejos. Un mayor ancho de banda es esencial para manejar las demandas de memoria de estos modelos y garantizar un rendimiento óptimo.

No lo olvides, puedes dejar tus comentarios.