Analizamos porqué la GPU es el componente TOP para IA, mientras que la CPU parece algo más rezagada en este ámbito.

Desde que NVIDIA empezó con sus Volta y Tesla en datacenters, parece que solo la GPU sirve para la inteligencia artificial. Dicho por el mismo Raja Koduri, Jefe de GPU en Intel, quien manda en la IA es NVIDIA, y solo hay que ver todo lo que ha ocurrido con las H100. De momento, fueron los primeros en introducir Tensor Cores, viendo que AMD lleva AI Accelerators e Intel más de lo mismo.

Índice de contenidos

Porqué las GPU son indicadas para IA

Crees que la IA está de moda por ChatGPT, DALL-E, Bing AI o Google Gemini, pero eso solo es la punta del iceberg. Detrás de la IA generativa tan relevante hoy día, tenemos el famoso Machine Learning y una serie de modelos (LLM) que han cambiado el juego.

Toda esta IA generativa ha desatado una demanda de tarjetas gráficas de alto rendimiento HPC o para servidores que ha llevado a EE.UU a prohibir la exportación de tarjetas gráficas IA para China. Y la razón no es más que un poder conlleva una gran responsabilidad.

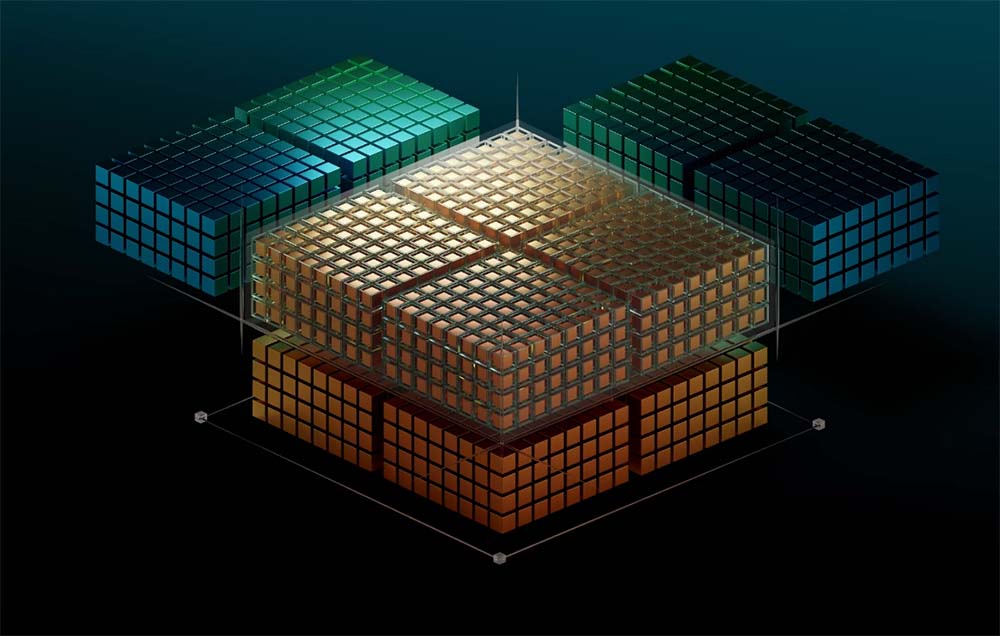

Pero, ¿por qué GPUs y no CPUs? Pues tenemos 3 razones principales de porqué las GPU son TOP para IA:

- El procesamiento paralelo.

- La plataforma software de GPU para IA, hace nada hablamos de CUDA.

- Mayor rapidez y eficiencia energética que las CPUs para realizar cálculos.

Además, hasta hace bien poco, los procesadores no llevaban motores IA dedicados para todas las tareas que se realizan en ese ámbito. En cambio, las tarjetas gráficas llevan incorporando núcleos dedicados para ello desde hace tiempo.

¿Desde cuándo? Desde el 21 de junio de 2017, la primera GPU en llevar Tensor Cores fue la NVIDIA Tesla V100 de 16 GB HBM2. A partir de ahí, vino Turing, Ampere, Hopper y el resto es historia. Aunque los Tensor Cores nos los vendieron para funcionar con DLSS, debo decir que la primera GPU para data center con este hardware fue una de la familia Volta, y no hacía uso de dicha tecnología.

Dentro de los centros de datos, NVIDIA menciona a los Tensor Cores porque «permiten la computación de precisión mixta, permitiendo adaptar dinámicamente los cálculos con el fin de acelerar el rendimiento sin perder precisión«.

Una cosa está clara, los modelos IA se están dificultando más y hay nuevos desafíos que encarar. Quienes entrenáis modelos LLM gigantes, sabéis que se necesitan meses, pero los aceleradores IA como los AI Accelerators o los Tensor Cores pueden acortar el proceso.

No es algo matemático, pero depende de muchos factores, siendo uno de ellos la plataforma IA que tenga la GPU en cuestión. Sabéis que AMD tiene una política «open source» con OpenAI, mientras que NVIDIA cierra todo a sus propios productos.

Qué tarjetas gráficas son más interesantes para IA

No hay duda de que las NVIDIA, pero vamos a profundizar en las razones. En este ámbito se suele usar MLPerf, que es una especie de benchmark que mide el rendimiento de IA a través del Machine Learning.

Concretamente, las tarjetas gráficas interesantes para IA son las que AMD y NVIDIA ofrecen en el campo profesional. En pleno 2024, se puede hablar de la AMD Instinct MI300 o la NVIDIA H100 como los ejemplos más plausibles.

Te va a sorprender que te diga que la GPU más buscada es una Tesla P40 de 24 GB GDDR5 para ejecutar modelos de forma local. Más que nada porque usa PCI-Express como interfaz y tienes 24 GB por menos de 200 euros en eBay. Sin embargo, si te dedicas profesionalmente a ello, te recomiendo otras opciones.

El tema de esta Tesla P40 es que no está tan actualizada como lo están las GPUs más actuales, especialmente con los famosos Tensor Cores, ni en cuestión de arquitectura, ¡es una GPU de 2016!

¿Tengo qué gastarme más de 2000€ para tener una GPU con la que entrenar modelos de forma local? Lo que se suele requerir es una VRAM grande(+12 GB), una CPU con bastantes núcleos (mira un Ryzen 9) y mucha memoria RAM (32 GB en adelante).

Visto esto, con una RTX 4060 Ti de 16 GB podrías trabajar en ciertos modelos LLM, pero ya os adelanto que no es lo óptimo. Dentro de la gama GeForce, que es lo que puedes comprar en retail, iría a la RTX 3090 o 4090.

Mucha gente decide alquilar GPUs en la nube para funcionar porque es tan sumamente cara una tarjeta gráfica de este tipo que no puedes sacarle rentabilidad. Dicho esto, hay gente que usa RTX 3090 duales con NVLink, pero encontrar modelos por eBay a un precio potable (unos 850€) y sin estar destrozadas… es complicado.

De esta manera, tendrías 24 + 24 GB por menos de lo que cuesta una RTX 4090. ¡No está mal pensado! Con todo esto, siempre es mejor optar por las GPUs más recientes. No solo importa la VRAM, sino también que opere con tipos de datos INT8, es decir de 8 bits. Lamentablemente, este es otro filtro más.

Por último, NVIDIA gana por goleada a AMD en todo lo que sea software, más aún en inteligencia artificial. Así que, si buscas una GPU para IA, debo decirte que toda la plataforma NVIDIA AI Enterprise o NVIDIA NeMo… son de otro nivel.

Con todo esto, debo deciros que existe un calculador de memoria VRAM según el modelo que vas a entrenar. Está en Hugging Face y te permite elegir la precisión, librería y API. Esto te ayudará a elegir con precisión qué GPU comprar.

¿Se acabará esta moda por la IA?

Mi opinión es que no, siendo uno de los mayores avances tecnológicos de este siglo XXI. No hablo de la IA como tal, sino del tipo Machine Learning y los modelos Deep Learning que han incubado la famosa IA generativa. Aunque estaban más o menos planteados con anterioridad, su aplicación ha supuesto todo un avance en muchos campos, especialmente en el de los datos.

Por ahora, la GPU predomina más en aplicaciones IA que la CPU, pero nadie niega lo contrario en un futuro próximo. Además, NVIDIA ha estado apostando mucho por RISC-V en sus sistemas, y ahora se le ha sumado Intel… solo queda AMD por unirse a la lista. Una de las claves de esa eficiencia energética está en los diseños de Arm, y parece que el «Red Team» se ha empezado a animar con los portátiles.

Esperamos que haya sido de ayuda esta información. Si tienes alguna duda, solo tienes que comentar abajo para poder ayudarte.

Te recomendamos las mejores tarjetas gráficas del mercado

¿Usáis GPU para IA? ¿Tenéis pensado en pasaros a entrenar de modo local?