NVIDIA no ha dejado de acaparar titulares tras el evento que dieron ayer. En esta ocasión, entre las novedades presentadas, hemos visto que la compañía Graphzilla ha introducido una variante nueva de su GPU Hopper especialmente diseñada para modelos de lenguas grandes o LLM, como Chat GPT o similares. Pero la noticia no es esta, sino que esta H100 NVL es una GPU Dual. Algo que llevamos mucho tiempo sin ver en el mercado…

Quizás también te puede interesar:

NVIDIA H100 NVL GPU Dual: características

La nueva GPU H100 basada en la arquitectura de GPU Hopper se basa en un sistema GPU dual, con NVL, es decir, NVLink. Concretamente usará dos tarjetas gráficas PCIe conectadas a través de un triple bus NVLink Gen4 para comunicación entre ellas.

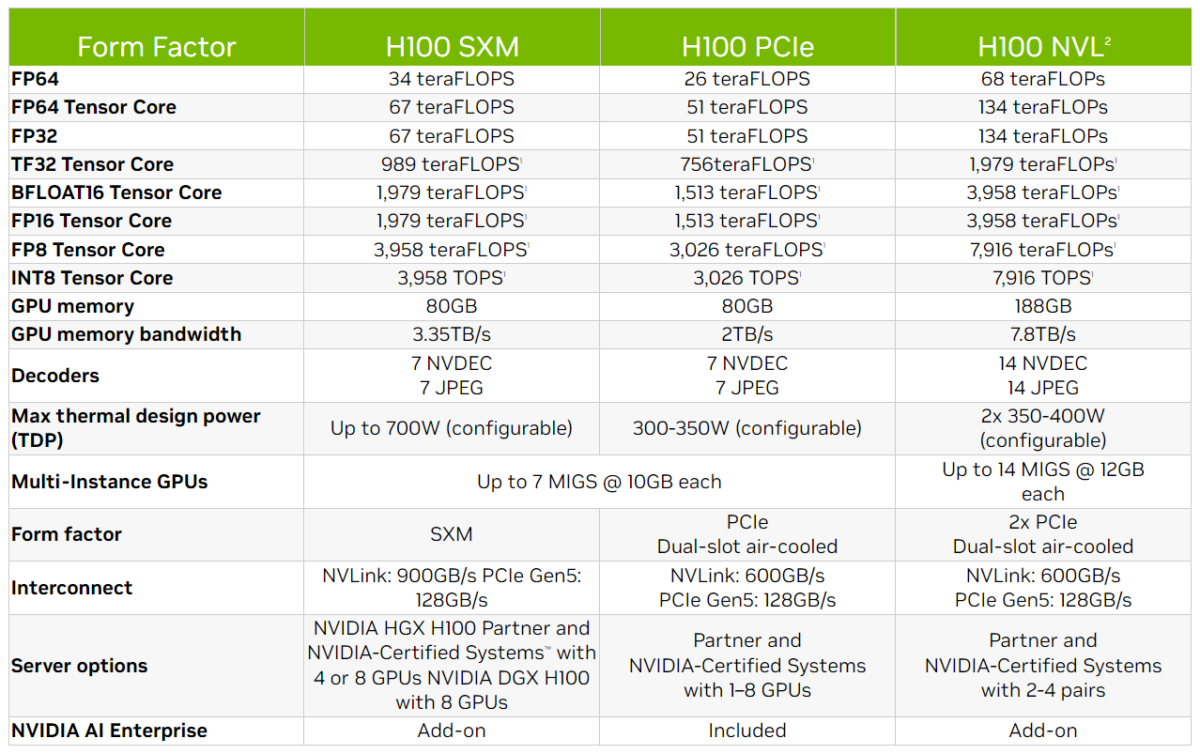

Esta nueva variante NVL de la H100 existentes, también tiene otra clara ventaja, y está en su memoria. Y es que estas tarjetas gráficas especialmente diseñadas para acelerar la IA están basadas en una pila de 6 chips HBM3, lo cual ofrece un total de 188 GB de buffer de alta velocidad (aunque tendrá disponible 94 GB).

Por otro lado, la nueva tarjeta gráfica H100 NVL vendrá con una interfaz de memoria con un ancho realmente impresionante, de 6144-bit. Esto es así dado que las aplicaciones para modelos de lenguaje LLM requieren grandes cantidades de memoria y un ancho de banda elevado para funcionar de forma fluida.

Los chips de memoria HBM3 que rodearán al chip de la GPU tienen 1024-bit por cada una de las 6 pilas. Esto deja un total de hasta 5.1 Gbps de velocidad. En cuanto al ancho de banda, tenemos un total de 7.8 GB/s. Teniendo en cuenta las velocidades de la H100 SXM anterior, significa que el rendimiento de la memoria se ha duplicado.

NVIDIA H100 NVL for Large Language Model Deployment es ideal para implementar LLM masivos como ChatGPT a escala. El nuevo H100 NVL con 94 GB de memoria con aceleración de Transformer Engine ofrece un rendimiento de inferencia hasta 12 veces más rápido en GPT-3 en comparación con la generación anterior A100 a escala de centro de datos.

Cuándo y cuánto costará

Además, en cuanto a fechas, NVIDIA espera que la GPU H100 NVL se lance en la segunda mitad de este año. Por otro lado, la compañía no ha dado más detalles en su evento, ni de precios ni fechas exactas…