Nunca os habéis preguntado ¿Qué procesadores usan los satélites? En las películas estamos acostumbrados a ver naves espaciales, satélites y robots rovers con supercomputadoras e inteligencia artificial. Pero la realidad es bien distinta. Todos los equipos que se lanzan al espacio utilizan CPUs bastante primitivas y lentas, algunas de ellas diseñadas en los años 80s. Nada que ver con los nuevos AMD Ryzen o Intel Core… ¿Quieres saber por qué?

Índice de contenidos

Quizás también te interese:

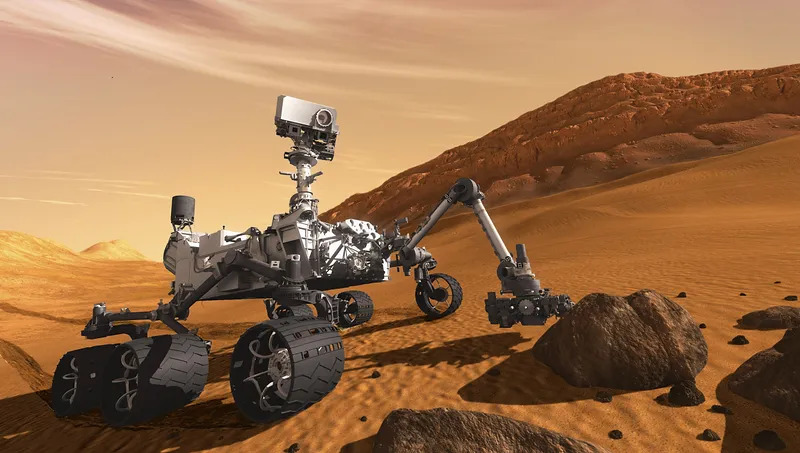

Ten en cuenta que los rovers o los satélites necesitan procesar datos y enviarlos a la Tierra, como registrar imágenes y comprimirlas, o vídeo, etc. Por tanto, necesitan un ordenador a bordo.

¿Por qué se usan microprocesadores lentos en los satélites y rovers?

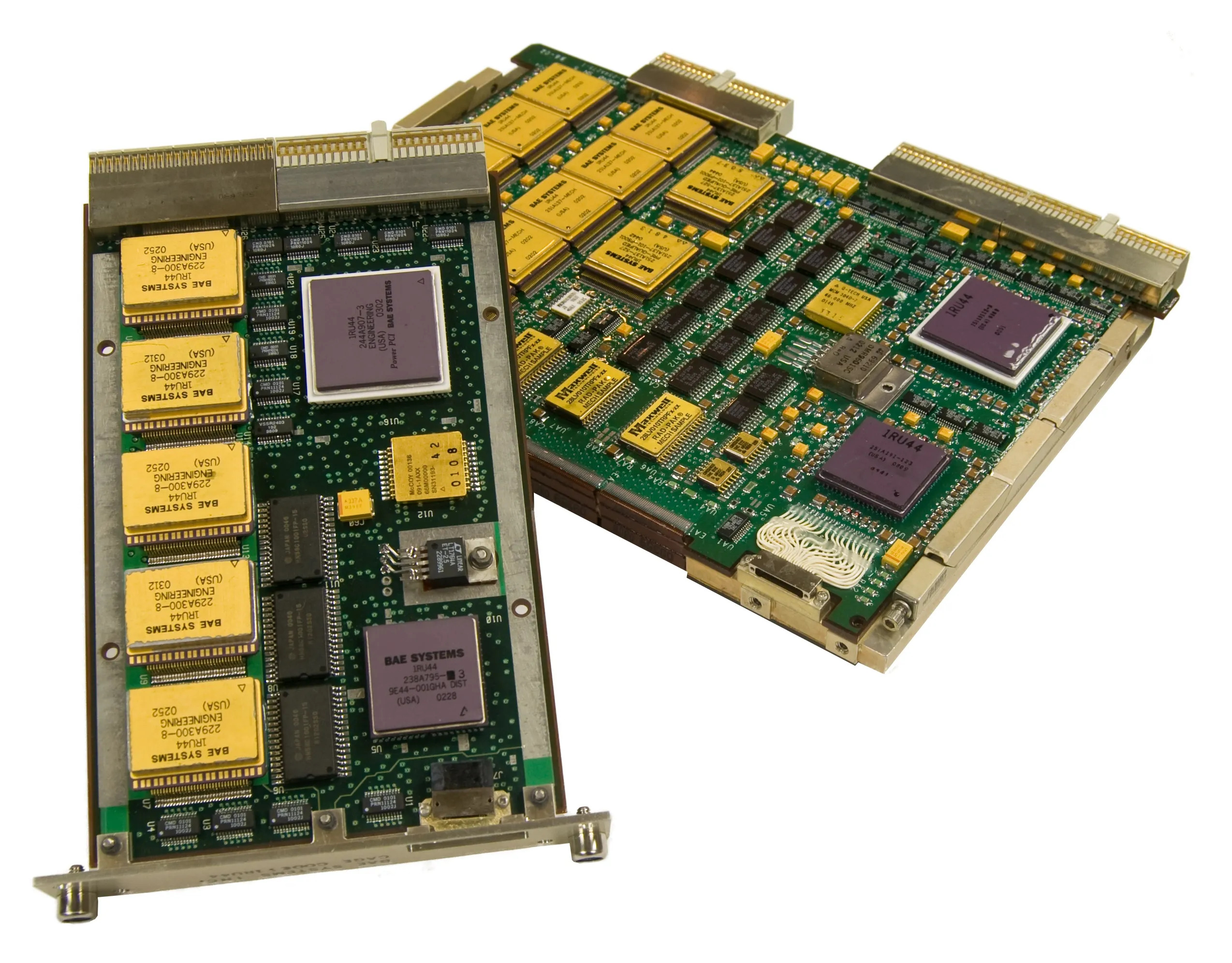

Por ejemplo, el famoso Curiosity, el explorador de Marte, funciona con dos procesadores BAE RAD750 a 200 MHz, es decir, dos procesadores basados en el PowerPC 750, similares a los que se usaron en el Apple PowerBook G3 de finales de los 90. Además de eso, tiene 256 MB de RAM y 2 GB de memoria flash para almacenamiento de datos.

Comparado con cualquier smartphone que llevemos en el bolsillo, el rendimiento del RAD750 es muy inferior. El diseño se basa en el procesador creado por IBM y Motorola que introdujeron a finales de 1997 para competir con el Pentium II de Intel. Esto significa que el hardware espacial más avanzado tecnológicamente es bastante más lento y primitivo que lo que actualmente usamos todos en cualquier dispositivo móvil o PC.

Aun así, el precio del RAD750 ronda los 200.000 dólares. ¿Por qué no ponerle uno actual que tiene mayor rendimiento y cuesta menos? Pues muy sencillo, las dos causas principales son:

- Los procesadores de generaciones anteriores están probados y requete probados, por lo que se sabe que carecen de posibles errores que pudieran afectar a una misión espacial que cuesta millones de dólares. De hecho, la NASA estuvo comprando procesadores Zilog Z80 como los que había en una Gameboy para sus misiones espaciales, ya que este chip era bastante estable.

- Por otro lado está el problema de la radiación para los equipos que van a salir de la atmósfera terrestre y se exponen a la radiación espacial. Esta radiación es muy dañina para los chips y puede neutralizarlos. Por tanto, se necesitan modelos protegidos contra las partículas de radiación ionizante.

Cuando no se tenía en cuenta la radiación

Un ejemplo lo tenemos en la misión rusa Phobos-Grunt, que llevó un chip SRAM de memoria que fue golpeado con una partícula muy cargada. El chip que llevaba este equipo era bien conocido y utilizado en la industria espacial, ya que se había estado probando anteriormente en el acelerador de partículas exponiéndolo a radiación para ver cómo de vulnerable era. Y lo cierto es que no lo fue tanto como para el espacio. Ten en cuenta que estos chips de memoria habían sido construidos para aviones de agrado militar, para soportar cierta radiación, pero no para el espacio. No obstante, aún así, los rusos de Phobos-Grunt optaron por ellos porque eran más baratas que las memorias de grado espacial.

Aquello supuso un punto de inflexión en las misiones espaciales. Se descubrió que la radiación del espacio era mucho más agresiva, con fuentes como los rayos cósmicos, los eventos de partículas solares y los cinturones de protones y electrones que dan vueltas en el borde del campo magnético de la Tierra, conocidos como cinturones de Van Allen. Las partículas que impactan en la atmósfera terrestre están compuestas aproximadamente por un 89% de protones, un 9% de partículas alfa, un 1% de núcleos más pesados y un 1% de electrones solitarios. Pueden alcanzar energías de hasta 10^19 eV. Utilizar los chips no calificados para el espacio en una sonda que pretendía viajar por el espacio profundo durante varios años era un desastre garantizado. De hecho, Krasnaya Zvezda, un periódico militar ruso, informó en aquel momento de que el 62% de los microchips utilizados en la Phobos-Grunt no estaban cualificados para el vuelo espacial.

Ahora todos sabemos cómo terminó esta misión rusa. Una vez lanzado este satélite que pretendía ir a Marte para su exploración, terminó fallando y quedó atrapado en la órbita terrestre…

Otro ejemplo lo tenemos en otra misión de la NASA de no tener en cuenta la radiación. Hoy en día, la radiación es uno de los factores clave que los diseñadores tienen en cuenta a la hora de construir ordenadores de uso espacial. Pero no siempre ha sido así. El primer ordenador llegó al espacio a bordo de una nave espacial Gemini en la década de 1960. La máquina tuvo que someterse a más de cien pruebas diferentes para obtener la autorización de vuelo. Los ingenieros comprobaron su comportamiento ante las vibraciones, el vacío, las temperaturas extremas, etc. Pero ninguna de esas pruebas incluía la exposición a la radiación. Aun así, el ordenador de a bordo del Gemini se las arregló para funcionar muy bien, sin ningún problema. Eso fue así porque el ordenador de a bordo del Gemini era demasiado grande para fallar. Literalmente. Su enorme memoria de 19,5 KB estaba alojada en una caja muy grande y densa de de unos 11.7 kg. Todo el ordenador pesaba unos 26 kg.

Transistores más grandes y menor frecuencia de reloj en procesadores satélites

En general, en el ámbito de la informática, el avance de la tecnología de los procesadores siempre se ha realizado principalmente reduciendo el tamaño de los transistores. Los transistores se han hecho cada vez más pequeños, pasando de los 240 nm a los 65 nm, a los 14 nm y a los 7 nm, etc. Cuanto más pequeño es el transistor, menor es el voltaje necesario para encenderlo y apagarlo. Por eso, los procesadores más antiguos con características de mayor tamaño no se veían afectados por la radiación, o, para ser más exactos, no se veían afectados por los llamados «single event upsets» (SEU). La tensión creada por los impactos de partículas era demasiado baja para afectar realmente al funcionamiento de ordenadores suficientemente grandes. Es decir, mientras mayor sea el transistor, más voltaje se necesita para alterar su estado, y por tanto mayor energía, por lo que los impactos de las partículas radiactivas no serían suficientes para conmutar el transistor.

Otra cosa que suelen hacer los ingenieros y desarrolladores para mejorar las CPUs es aumentar su frecuencia de reloj. El Intel 386SX que hacía funcionar los transbordadores espaciales tenía una frecuencia aproximada de 20 MHz. Los procesadores modernos pueden llegar hasta los 5GHz. La velocidad de reloj determina cuántos ciclos de procesamiento puede realizar un procesador en un tiempo determinado. El problema de la radiación es que un impacto de partículas puede corromper los datos almacenados en una memoria de la CPU (como la caché L1 o L2) sólo durante un momento extremadamente breve llamado ventana de enganche. Esto significa que en cada segundo hay un número limitado de oportunidades para que una partícula cargada cause daños.

En los procesadores de baja velocidad como el 386SX, este número era relativamente bajo. Pero cuando las velocidades de reloj aumentaron, el número de ventanas de enganche por segundo también se incrementó, haciendo que los procesadores fueran más vulnerables a la radiación. Por ello, los procesadores endurecidos por la radiación casi siempre tienen una velocidad de reloj mucho menor que la de sus homólogos comerciales.

La lucha contra la radiación: un cambio drástico

Antiguamente los efectos de la radiación de los chips se solían solventar modificando el proceso de fabricación de los semiconductores. Bastaba con tomar un núcleo de procesamiento disponible en el mercado, e implementarlo con un proceso de endurecimiento contra la radiación (Radiation Hardened).

Esta técnica consistía en usar materiales como el zafiro o el arseniuro de galio que eran menos susceptibles a la radiación que el silicio. De este modo, los chips fabricados así trabajaban muy bien en entornos con mucha radiación sin fallar. Por supuesto, también se aplicaban las técnicas descritas anteriormente, es decir, frecuencias de reloj bajas y nodos de fabricación más antiguos.

Sin embargo, para aumentar el rendimiento en los ordenadores de abordo de las misiones espaciales, los costes para estas modificaciones en procesadores más avanzados se dispararon y dejaron de ser viables. Entonces se comenzaron a recurrir a técnicas de endurecimiento por radiación por diseño.

El proceso RHBD (radiation hardening by design) permitió a los fabricantes utilizar un proceso de fabricación CMOS (Complementary metal-oxide-semiconductor) estándar. De este modo, los procesadores de grado espacial pudieron fabricarse exactamente igual que los comerciales, lo que redujo los precios y permitió a los diseñadores de misiones espaciales ponerse un poco al día con el rendimiento de los procesadores comerciales. La radiación se solucionó con el ingenio de la ingeniería más que con la pura física del material.

Estas nuevas técnicas RHBD se basan en otras técnicas como la Redundancia Modular Triple o TMR, que consiste en almacenar tres copias idénticas de cada bit en la memoria. Durante la fase de lectura se leerán tres copias y se elige la correcta, que será la predominante. Es decir, si un evento de radiación alteró alguno de los bits, habrá dos no alterados que serían los correctos. En caso de que las tres copias sean idénticas, entonces también se declara correcto. Y cuando las tres copias son diferentes, el sistema lo declara como un error.

La idea que subyace a la TMR es que las copias se almacenan en diferentes direcciones de la memoria que están situadas en diferentes puntos del chip. Para corromper los datos, dos partículas tendrían que impactar simultáneamente exactamente en el lugar donde se almacenan las dos copias del mismo bit, y eso es extremadamente improbable. Sin embargo, el inconveniente de la TMR es que este enfoque conlleva una gran sobrecarga. Un procesador tiene que realizar cada operación tres veces, lo que significa que sólo puede alcanzar un tercio de su rendimiento.

Por eso, la última idea en este campo es conseguir que los procesadores de grado espacial se acerquen aún más a sus homólogos comerciales. En lugar de diseñar todo un sistema en chip con componentes resistentes a la radiación, los ingenieros eligen dónde es realmente necesaria la dureza a la radiación y dónde se puede prescindir de ella con seguridad. Se trata de un cambio significativo en las prioridades de diseño. Los procesadores espaciales de antaño se construían para ser inmunes a la radiación. Los procesadores modernos ya no son inmunes, pero están diseñados para hacer frente automáticamente a todo tipo de errores que pueda provocar la radiación.

El LEON, por ejemplo, es el último procesador europeo de grado espacial usado por la ESA. Se calcula que experimenta la asombrosa cifra de 9 SEU al día en una órbita terrestre geoestacionaria. El truco está en que todos esos SEUs son mitigados por el sistema y no dan lugar a errores de funcionamiento. El modelo LEON GR740 (250 Mhz y nodo 65nm) está construido para experimentar un error funcional cada 300 años aproximadamente. E incluso si eso ocurre, puede recuperarse simplemente reiniciando.

Dos enfoques Europa (código abierto) vs USA (código propietario)

Los procesadores LEON europeos de grado espacial están basados en la ISA SPARC, aunque actualmente está siendo sustituida por la ISA RISC-V. Según los diseñadores de estos chips, las razones clave para pasarse a SPARC fueron el soporte de software existente y la apertura. Al ser una ISA de código abierto se podía usar sin licencias y esto abarata los costes de forma drástica. No obstante, la microarquitectura sí que era propietaria.

Por otro lado está Estados Unidos, cuyos desarrollos de CPU para el espacio están basados en diseños propietarios, como el PowerPC de la misión Gmini y que era propiedad de Apple-IBM-Motorola. Por otro lado, los procesadores de los transbordadores espaciales y el telescopio espacial Hubble se fabricaron con la arquitectura x86 introducida por Intel, también propietaria. Así que, siguiendo la tradición, el último diseño estadounidense en este campo también es propietario. Denominado High Performance Spaceflight Computing (HPSC), este último basado en la arquitectura ARM.

El HPSC ha sido diseñado por la NASA, el Laboratorio de Investigación de la Fuerza Aérea y Boeing, que se encarga de fabricar los chips. El HPSC se basa en los procesadores de cuatro núcleos ARM Cortex A53 a 500 Mhz. Tendrá dos de estos procesadores conectados por un bus AMBA, lo que lo convierte en un sistema de ocho núcleos. Esto debería situar su rendimiento similar al de los smartphones de 2018 (no obstante, tras las prácticas RHBD el rendimiento se reducirá a casi la mitad).

El RAD5545 de BAE es probablemente el procesador reforzado contra la radiación más potente que existe en la actualidad. Fabricado en el proceso de 45 nm, es una máquina de cuatro núcleos de 64 bits a 466 MHz con una disipación de energía de hasta 20 vatios. Esta potencia disipada es bastante elevada, y hay que tener en cuenta que en el espacio los sistemas de refrigeración con ventiladores no harían completamente nada, ya que no hay aire. La única forma posible de sacar el calor de una nave espacial es a través de un disipador y heatpipes.

Además, algunas misiones tienen presupuestos de energía muy ajustados y no pueden utilizar procesadores potentes como el RAD5545 con estas restricciones. Por eso el LEON GR740 europeo tiene una disipación de energía de sólo 1,5 vatios. No es el más rápido de todos, pero sí el más eficiente. Simplemente, ofrece el mayor rendimiento computacional por vatio. El HPSC, con una disipación de energía de 10 vatios, queda en un segundo lugar.

Linux es el sistema operativo favorito para el espacio. En la ISS o la estación espacial internacional se empleaba un equipo con Windows XP que fue reemplazado por Debian. Y en otros satélites, rovers y naves también se emplea Linux y proyectos de código abierto. Por ejemplo, para comprimir las imágenes tomadas por el rover de Marte se emplea ffmpeg. El motivo de usar estos proyectos es por ser confiables, robustos, estables y seguros.

La ciencia ficción es solo ciencia ficción

Te recomendamos la lectura de los mejores procesadores del mercado.

Como ves, las películas de ciencia ficción donde los ordenadores de abordo son extremadamente avanzados y donde hay sistemas de IA no son reales. La verdad es mucho menos sorprendente, ya que algunas de las misiones espaciales usan pueden ser infinitamente menos potentes que tu PC actual o que tu smartphone.