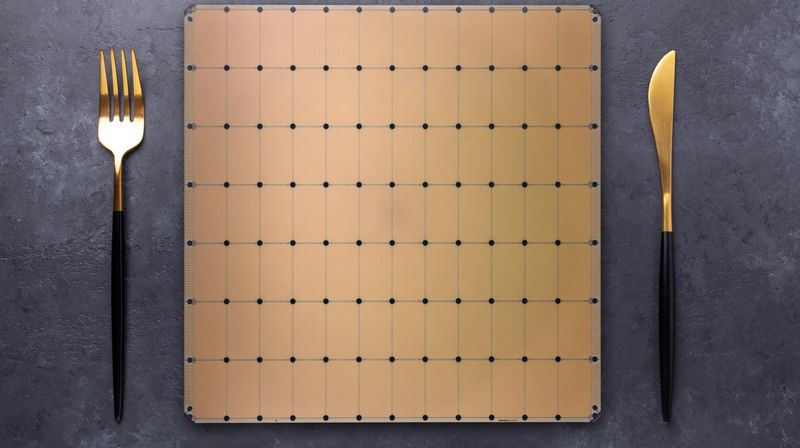

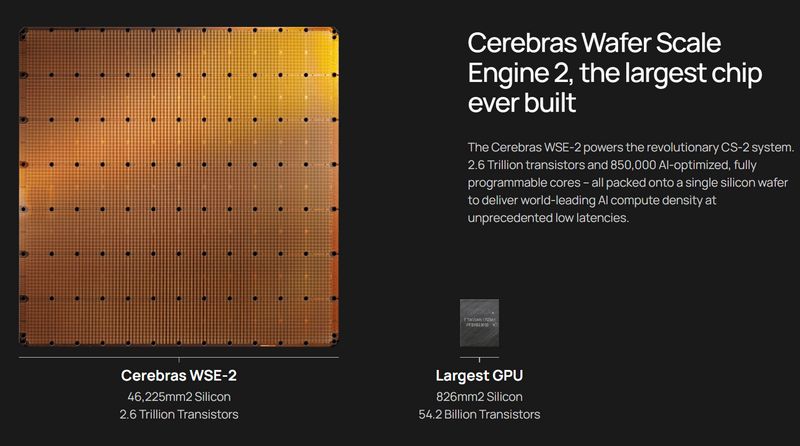

El CS-2 Wafer Scale Engine se proclama como el chip acelerador más grande del mundo. Este chip supera a todas las GPU batiendo el récord del mayor modelo de IA entrenado en un solo dispositivo, embebiendo más de 850.000 núcleos.

Cerebras CS-2 bate el récord del mayor modelo de IA entrenado en un solo dispositivo

El modelo de inteligencia artificial entrenado por Cerebras alcanzó una cifra de 20.000 millones de parámetros, que fue completado sin tener que escalar la carga de trabajo en numerosos aceleradores. Este chip se encarga de operaciones de aprendizaje automático, lo que es fundamental para el desarrollo de muchas operaciones pensando en el presente y el futuro de la informática.

El chip Wafer Scale Engine-2 fue diseñado con un nodo de 7 nm, contando con 2.6 trillones de transistores. Junto con la oblea y los transistores, el Wafer Scale Engine-2 incorpora 850.000 núcleos y 40 GB de caché integrada con un consumo de energía de 15kW, lo que vendría a ser como un ‘super-ordenador’ compactado en un solo chip.

Te recomendamos nuestra guía sobre el armado de un PC entusiasta

El CS-2 permite unas 20.000 millones de parámetros en un solo chip, lo que permite ahorrar tiempo y costes en el entrenamiento de miles de GPU, el hardware y los requisitos de escalado.

»En NLP, los modelos más grandes han demostrado ser más precisos. Pero tradicionalmente, sólo unas pocas empresas selectas disponían de los recursos y la experiencia necesarios para realizar el minucioso trabajo de dividir estos grandes modelos y repartirlos entre cientos o miles de unidades de procesamiento gráfico. En consecuencia, pocas empresas podían entrenar grandes modelos de PNL, ya que era demasiado caro, lento e inaccesible para el resto de la industria. Hoy nos sentimos orgullosos de democratizar el acceso a la GPT-3XL 1.3B, la GPT-J 6B, la GPT-3 13B y la GPT-NeoX 20B, lo que permite a todo el ecosistema de la IA configurar grandes modelos en cuestión de minutos y entrenarlos en un solo CS-2″.

– Andrew Feldman, director general y cofundador de Cerebras Systems

Cerebras habla también de la democratización al acceso de sistema de IA, que va a reducir costes a las organizaciones que requieran experimentar con esta tecnología.

‘’Será interesante ver las nuevas aplicaciones y los descubrimientos que hagan los clientes de CS-2 cuando entrenen los modelos de clase GPT-3 y GPT-J en conjuntos de datos masivos».

– Dan Olds, director de investigación, Intersect360 Research