Durante el keynote inaugural, NVIDIA ha anunciado un modelo de alquiler DGX SuperPOD para entornos empresariales y de investigación. Además, han presentado el sistema «NVIDIA Certified» para aceleradores de computación basados en BlueField-2, un kit de desarrollo y una solución basada en procesadores ARM que llegara en el futuro.

NVIDIA anuncia el nuevo sistema DGX SuperPOD que contara con hasta 1120 tarjetas DGX A100

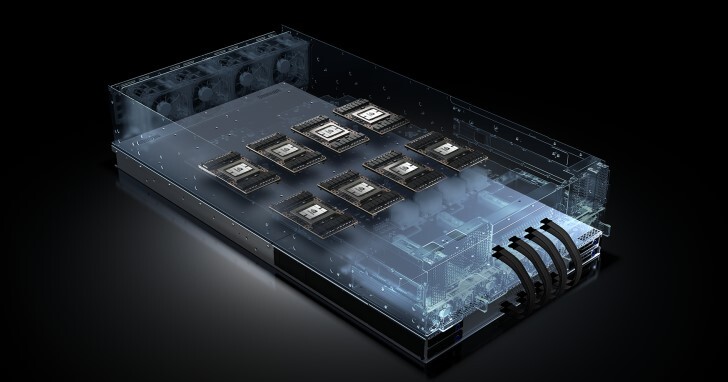

Hace unos meses, durante el GTC 2020, por parte de NVIDIA se presentó el sistema DGX SuperPOD que albergaba hasta 140 tarjetas DGX A100, los cuales tienen un precio de venta al público de 199.000 dólares más impuestos. Estos sistemas SuperPOD contienen ocho módulos SXM4 con cada uno una GPU A100 interconectados mediante NVLink. Estos sistemas ofrecen una potencia de 5 PetaFLOPS para Inteligencia Artificial basados en FP16. Mediante INT8 puede ofrecer 10 PetaOPS, mientras que con TF32 pueden ofrecer 2.5 PetaFLOPS y con FP64 pueden ofrecer hasta 156 TFLOPS.

Estos sistemas DGX SuperPOD cuentan con dos procesadores AMD EPYC 7742 con 64 núcleos y 128 hilos de procesamiento. Se acompañan también de 1TB de memoria RAM y hasta 15TB de almacenamiento en formato M.2 PCIe 4.0. Cuenta también con seis NVSwitches de tercera generación y nueve interfaces de red Mellanox ConnectX-6 VPI con un ancho de banda de 200 Gbit/s.

Según la hoja de datos de los nuevos DGX SuperPOD, se pueden establecer configuraciones de 20 hasta los 140 DGX A100. Esto quiere decir que los sistemas ofrecen entre 160 y 1120 tarjetas A100 para la Inteligencia Artificial. Estos sistemas ya estaban disponibles para su compra o alquiler con un tiempo de construcción de tres semanas.

Alquiler de cuatro nodos DGX SuperPOD o más

Los sistemas de NVIDIA no son precisamente económicos, costando el más sencillo unos 7 millones de dólares hasta los 60 millones de dólares de los DGX A100. Esto impedía que empresas y centros de investigación pudieran acceder a estos sistemas de alto rendimiento. Durante el Computex 2021, NVIDIA ha anunciado la posibilidad de alquilar configuraciones más simples, facilitando así el acceso a estos sistemas.

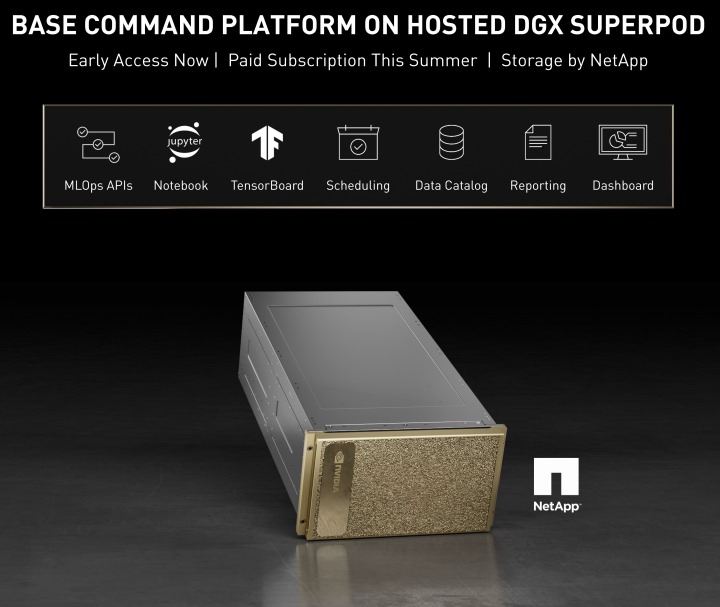

NVIDIA se ha unido con NetApp para ofrecer una configuración básica de 4 nodos DGX SuperPOD y un máximo de 20 nodos. Esto supone una potencia de entre 20 y 100 PetaFLOPS, que para investigación esta muy bien. NVIDIA ve esto como una solución y oportunidad para que los desarrolladores de soluciones IA en fase de prototipo tengan una oportunidad de probar sus soluciones de manera ágil y económica. Desde la compañía destaca que quienes necesiten mayor potencia y durante largos periodos de tiempo, es mejor que adquieran un DGX SuperPOD.

El sistema de cuatro nodos DGX SuperPOD tiene un precio con impuestos de 90.000 dólares mensuales. Aunque pueda parecer bastante caro, realmente es mucho más económico que pagar varios millones por un sistema que igual necesitas solo unos meses.

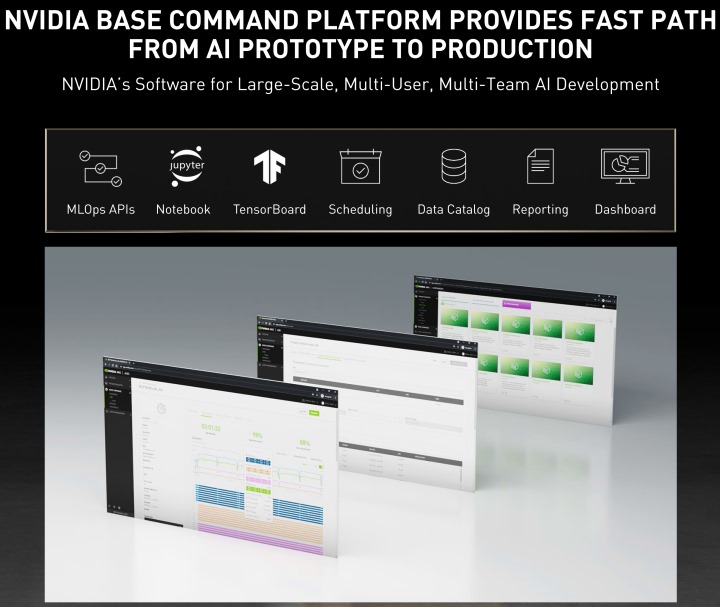

Además, el precio incluye una suscripción a NVIDIA Base Command, un software de coordinación de captación de IA y de cargas de trabajo en la infraestructura. Se ha diseñado esta plataforma para proyectos de gran escala que incluyen múltiples usuarios y equipos de desarrollo para IA, y que se pueden ejecutar en servidores físicos o en la nube. NetApp por su parte ofrecerá en breve AWS para cargas de trabajo de Machine Learning en Amazon SageMaker y de Google en Google Cloud Marketplace.

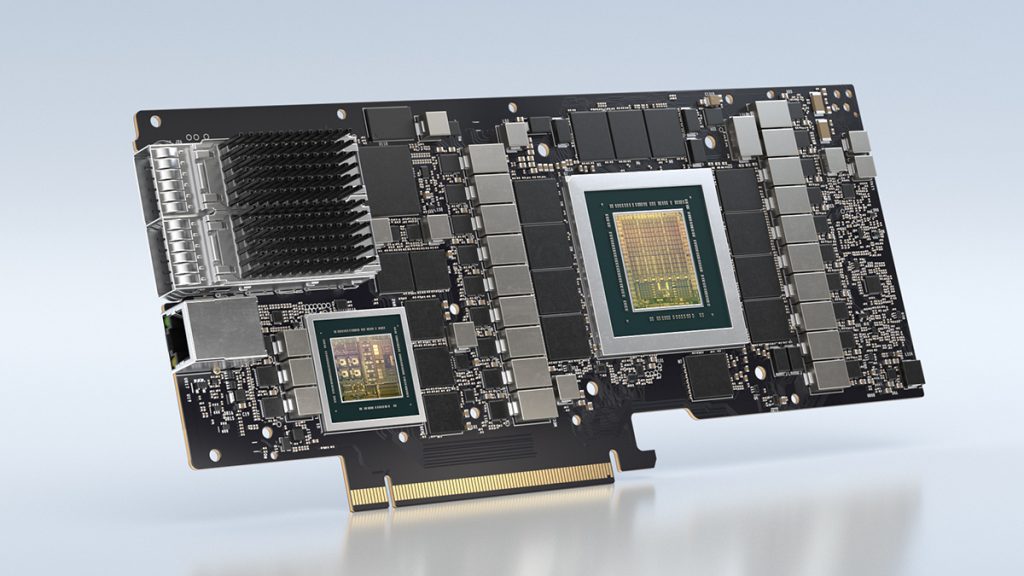

BlueField-2 DPU de terceros certificada por NVIDIA

NVIDIA durante el Computex ha anunciado junto a sus socios que está ampliando las soluciones con «NVIDIA Certfied». Lo que hace NVIDIA es ofrecer planos a sus socios y que estos puedan adaptarlos a diferentes cargas de trabajo y recibir certificación por la propia NVIDIA. Los HGX y EGX son sistemas desarrollados por terceros en base a las gráficas NVIDIA A100 y que son validados por la propia NVIDIA. Como ejemplo en sistema que añade un co-procesador ARM BlueField-2. ASUS, Dell, Gigabyte, QCT y Supermicro han sido los primeros en recibir certificaciones de este tipo para sistemas con DPU.

Las Unidades de Procesamiento de Datos (DPU) son chips complementarios que reducen la carga del procesador. Una CPU debe, entre otras cosas, gestionar la memoria y la seguridad de la red, aspectos críticos para evitar brechas de seguridad. Los DPU se encargan ahora de estas tareas, permitiendo a la CPU reducir su carga un 30% que se puede destinar a tareas de computación más importantes.

Durante el GTC de este año NVIDIA presento BlueField-3, una DPU con 16 núcleos ARM Cortex-A78 que no estará disponible hasta el Q1 2022. Antes de esto llegarán los servidores con BlueField-2 diseñados pro terceros, disponibles a partir de otoño.

Kits de desarrollo ARM con soluciones Ampere Altra Q80-30m

Como es lógico NVIDIA quiere empezar a sacar réditos de la adquisición de ARM (proceso que aún esta pendiente de aprobación por organismos anti-monopolio internacionales). Ya durante el GTC de este año NVIDIA nos presentó Grace, una CPU de arquitectura ARM para el mercado HPC que llegara en 2023. NVIDIA además se encuentra trabajando en su sucesor denominado «Grace Next» y donde se utilizara la arquitectura «Ampere Next», que en 2024 será reemplazada por la arquitectura «Ampere Next Next».

Te recomendamos nuestro artículo sobre qué es la inteligencia artíficial

Los primeros servidores basados en chips ARM de arquitectura Neoverse con aceleradores Ampere y/o BlueField-2 certificados por NVIDIA llegarán de la mano de Gigabyte y Wiwynn. Gigabyte trabaja en un kit de desarrollo de soluciones IA para ARM junto con NVIDIA. Este sistema será el servidor 2U Gigabyte G242-P32 con un procesador ARM Ampere Altra Q80-30m, dos NVIDIA A100, 512GB de memoria RAM DDR4, 6TB de almacenamiento SATA/SAS y dos BlueField-2. De momento no hay datos de precio de estos sistemas.