Te has decantado por el 4K para tu monitor, pero no sabes la diferencia entre HDR y SDR. Dentro, comparamos ambas tecnologías para ayudarte.

Cuando parece que ya hemos solucionado la elección de resolución, aparece otro problema: su tecnología. Justo ésta es compleja y requiere varias lecturas para comprender ciertos conceptos. Dentro de los monitores 4K, encontramos el HDR y el SDR. Cada uno tiene sus virtudes y sus defectos, pero vamos a ayudaros a elegir el monitor adecuado para vosotros. Si os hayáis en esta cruzada, atentos a lo viene a continuación.

Índice de contenidos

HDR

Como la resolución es la misma con ambas tecnologías, lo que nos interesa es saber cómo funciona cada una. Empezando por el HDR (High Dynamic Range), se trata de una tecnología de imagen que procesa todo su contenido, aumentando todos los detalles: sombras, luces, colores, etc.

Se empezó utilizando esta tecnología con el tratado de imagenes, es decir, en fotografía. Sin embargo, se ha extendido por todos los dispositivos multimedia: smartphones, monitores, etc.

Dicho de forma resumida, el HDR ilustra la misma imagen, pero con más información: colores, sombras, texturas, etc. Por ello, se dice que es una tecnología que se aproxima a reproducir lo que ve el ojo humano.

Por otro lado, el HDR es un aspecto inteligente porque calcula las necesidades de reproducción en función de los metadatos (HDR Dinámico). Es decir, el monitor recibe la información del vídeo, o de la imagen, y la reproduce con el mayor detalle posible. De este modo, el objetivo es ofrecer una reproducción de las imágenes más realista.

SDR

En contraposición nos encontramos al SDR (Standard Dynamic Range), que es el estándar que hay en las pantallas que no tienen HDR. A priori, presenta la primera limitación frente al HDR: sólo representa una fracción de rango dinámico. Mientras que el HDR ofrece más detalle adaptándose a la escena, el SDR no cuenta con esta posibilidad.

Por este motivo, se dice que el SDR es más limitado que el HDR. Dicho esto, parece que el ganador es el HDR ¿Verdad? Cuidado con ello, ya que todo va a depender del dinero que queramos gastarnos, como de la calidad del panel.

Es cierto que el HDR es una tecnología buenísima, pero para que ésta funcione bien tiene que disponer de un panel con ciertos requisitos. Así que, no os extrañéis cuando vayáis a una tienda y veáis una pantalla 4K SDR que luce mejor que otra 4K HDR. Esto es porque en la tecnología hay gamas, por lo que hay que comparar modelos que jueguen en la misma liga.

Variables clave para elegir un monitor HDR 4K

Aquellos/as que hayáis optado por un panel con tecnología HDR, deberéis saber que no basta con que tenga HDR. Esta tecnología es muy «exquisita«, lo que significa que requiere de un panel con ciertas características.

Al fin y al cabo, es una tecnología más, por lo que seguiremos diciendo que el panel del monitor es clave para acertar. A continuación, os decimos las claves para elegir un monitor HDR sin morir en el intento.

El brillo

Nos hemos puesto a ver muchos modelos de televisión y hemos concluido que el HDR es una tecnología que debe tener como apoyo un panel con buenas prestaciones. Así que, para empezar vamos a atender al brillo que tenga el panel, independientemente de que disponga de HDR.

No obstante, lo primero que debemos hacer es ir a la fecha técnica del monitor y ver qué pico de brillo tiene. Éste se expresa en cd/m² o nits: cuanto más, mejor. Si comparamos un monitor 4K HDR con otro 4K SDR, nos podemos llevar una sorpresa: el monitor SDR tiene más brillo, por lo que el HDR del otro monitor no ofrece las virtudes necesarias para proporcionar una imagen de mayor calidad.

Por otro lado, en igualdad de brillo, el monitor HDR se llevará la victoria.

Profundidad de color

Normalmente, expresada en 12-bit, 10-bit u 8-bit, la profundidad de color se refiere a la cantidad de colores que un panel puede reproducir. Por el contrario, la gama de colores se refiere al nivel de saturación que un panel puede reproducir. Ambos conceptos se suelen confundir, y con razón.

En el caso de que la profundidad de color del monitor sea de 8-bit, supondrá que puede reproducir 16.7 millones de colores. Si ésta es de 10-bit, significará que puede reproducir 1.07 mil millones de colores.

¿La profundidad de color sólo afecta a la cantidad de colores mostrados? Sí, pero dicha limitación se presenta en forma de gradiente; véase, una escena de un atardecer. Aquí, hasta los HDR de gama baja responden bien, cosa que no pueden decir lo mismo los SDR.

Gama de colores

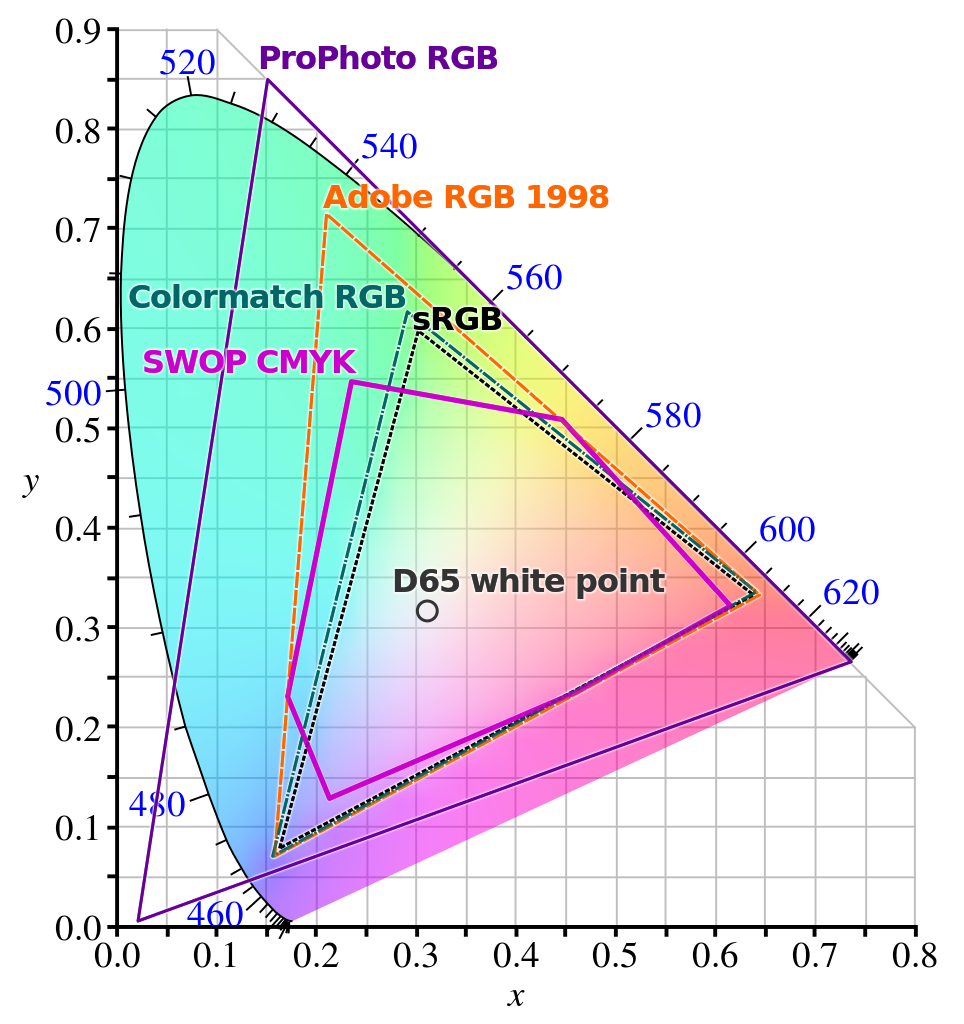

Haciendo hincapié en la gama de colores, recordar que sirve para la saturación del color. Para saber la gama de colores o saturación del monitor, buscad las siglas DCI-P3, sRGB o Rec.2020, las cuales representan el porcentaje de saturación. Cuanto más alto, mucho mejor.

Lo que nos interesa es que tengamos una amplia gama de colores para aprovechar al 100% ese HDR. Si, por ejemplo, tenemos un monitor 4K HDR con la saturación DCI-P3 del 73%, puede que otro 4K SDR con mayor saturación lo derrote.

Tecnologías

En mi humilde opinión, esto puede marcar mucho la diferencia. Dentro del HDR, encontramos varios tipos, pero destacamos sobre todo: HDR10, HDR10+, multi-HDR y Dolby Vision.

- HDR10. Se trata de un estándar muy extendido, ya que no hay que pagar derechos de licencia. Exige un panel con una profundidad de 10 bits.

- Dolby Vision. Se considera uno de los más avanzados porque el panel debe contener un chip para usarlo. Por otro lado, el fabricante debe pagar por usarlo. Es un estándar que sólo se ve en monitores de alta gama, ya que requiere 12 bits.

- HDR10+. Por último, este HDR fue desarrollado por Amazon y Samsung. Esta licencia también es libre, por lo que se irá usando cada vez más. De momento, Netflix y Prime Video ofrecen su contenido para HDR10+

- Multi-HDR. Es un formato que incluye el HDR10 y el HLG, que es un estándar desarrollado por la BBC y la NHK. Se diferencia del resto porque está preparado para funcionar en canales de televisión, como en las retransmisiones en directo. De todos modos, podemos ver el HLG por separado en algún panel.

¿Por qué os decimos esto? Principalmente, porque una de las claves del HDR es que podamos disfrutar de contenido optimizado para el estándar que tenga nuestro monitor 4K. El HDR normal suele estar presente en todo el material audiovisual nuevo que vaya saliendo, pero siempre es mejor tener uno de los 3 estándares mencionados.

Lo esencial

Para ir terminando, un aspecto importantísimo para aquellos que estéis pensando en comprar un monitor 4K HDR10 o HDR10+. Existe una peculiaridad que hay que tener en cuenta: el puerto HDMI. Para aprovechar el HDR10, el monitor debe tener un puerto HDMI 2.0a.

Cuidado con esto porque HDMI 2.0a puede reproducir 1080p a 144 Hz y 4K a 60 Hz, únicamente. Igualmente, sacar 144 Hz 4K en los últimos videojuegos es algo casi imposible. Si os preocupan los cables, deciros que necesitaréis un cable HDMI de alta velocidad para formatos de vídeo a 2160p («4K»).

Conclusión ¿Cuál es el ganador?

En mi opinión, un panel HDR ofrece mayores beneficios. Si comparamos un monitor 4K SDR con otro 4K HDR, el ganador va a ser, casi siempre, el último. Sin embargo, siempre hay que observar las peculiaridades de las que hemos hablado: profundidad de color, gama de colores, brillo, conexiones y estándar.

Si compramos un monitor 4K HDR a ciegas, sin mirar nada más, podemos equivocarnos. El HDR es una tecnología que tiene sus propios requisitos para poder funcionar adecuadamente. No basta con que tengamos HDR10 o HDR10+, sino que es necesario mirar detalladamente en la ficha técnica.

Igualmente, un monitor 4K HDR tiene un precio que no es apto para todos los bolsillos, por lo que estamos seguros de que estudiaréis a fondo la compra.

Te recomendamos los mejores monitores del mercado

Esperamos que os haya sido de ayuda esta información. Si tenéis alguna duda, podéis consultarnos comentando más abajo. ¿Tenéis algún monitor 4K? ¿Preferís el SDR o HDR?