Seguramente muchos de los que tienen una conexión a Internet y no sepan aún qué es la latencia, o, mejor dicho, el concepto de latencia. La latencia se encuentra presente en todos y cada uno de los componentes que forman un sistema informático, y no solamente en una red de Internet. Por eso hoy trataremos de definir qué es la latencia y en que dispositivos se encuentra. También veremos cómo podemos medirla para según qué casos.

Índice de contenidos

En informática existen gran cantidad de parámetros que se deben de tener muy en cuenta a la hora de adquirir determinados componentes. Uno de ellos es precisamente la latencia, aunque no en todos los casos tenemos una medida explícita, debido, precisamente a que se conoce de su existencia, y puede ser muy similar en todos los dispositivos, por ejemplo, en discos duros.

En cambio, otros sí que disponen de estas medidas, y además son muy importantes, por ejemplo, router, en algunos casos, y sobre todo memorias RAM. Sin más palabrerío, vamos a ver que es la latencia y cómo podemos medirla en nuestro ordenador.

Latencia, significado general

Antes de nada, lo que tendremos que hacer es definir el concepto de latencia en términos genéricos, porque de esta forma podremos imaginarnos muchos mejor en donde puede existir la latencia.

La latencia, en términos informáticos la podemos definir como el tiempo que transcurre entre una orden y la respuesta que se produce a esa orden concreta. Entonces, como podremos suponer la latencia se mide en unidad de tiempo, concretamente en milisegundos o microsegundos, ya que el segundo sería una medida demasiado alta como para aplicarla a sistemas microinformáticos.

Con la latencia estamos midiendo el tiempo que estamos esperando desde que damos una orden hasta que recibimos la respuesta que esperamos, bien en forma de información en un ordenador o en movimiento o sonido en la vida real.

Cada elemento informático funciona a través de estímulos eléctricos, por lo que podríamos decir que es el tiempo que tardan en realizarse todas las conmutaciones eléctricas y lógicas necesarias desde el comienzo de la acción a través de un periférico, hasta que el ordenador ejecuta la acción y muestra los resultados.

Latencia en Internet

Cuando hablamos de latencia en informática, la gran mayoría de las veces, nos estamos refiriendo a la latencia de una red de conexión a Internet. La interconexión entre nodos de una red, se basa en la interacción de señales eléctricas, las cuales viajan por un medio, bien físico, como cables o por el aire, en forma de ondas. Además, es necesario utilizar una serie de protocolos que nos permitan compatibilizar unos medios con otros y establecer, de alguna forma, un orden en la información que enviamos y recibimos.

La latencia en redes, mide la suma de retados que se producen desde que solicitamos una información (o la enviamos) y el nodo remoto nos responde. Dicho de otra forma, mide el tiempo que tarda un paquete de datos en llegar de un lugar a otro. Este tiempo, por supuesto, también se mide en milisegundos. Si por ejemplo tenemos una latencia de 30 milisegundos, significará que, desde que nosotros hemos enviado una petición desde nuestro navegador, hasta que el servidor lo ha recibido y a su vez nos ha respondido con lo que queremos, habrá transcurrido un tiempo de 30 milisegundos. Parece poco, pero a veces lo notamos mucho, ya veremos en qué situaciones.

Este término también es muy conocido con el nombre de Lag, especialmente en el mundo de los videojuegos, pero ambos términos expresan exactamente lo mismo.

Qué influye en la latencia

Esta medida es una de las más importantes y que siempre debemos tener en cuenta en nuestra conexión, para según qué tipo de aplicaciones vayamos a utilizar. Generalmente tenemos una serie de factores que influyen en la latencia:

El tamaño del paquete y los protocolos que se estén utilizando

Si el paquete de transmisión es pequeño, será más sencillo de transmitir y viajar que uno pesado, ya que no habrá necesidad de fraccionarlo y luego unirlo. En este sentido, también influye el el hardware de los equipos, por lo que, con routers o tarjetas de red antiguas, más tiempo de procesamiento necesitarán para realizar una acción. Esto es especialmente crítico en equipos con baja capacidad de procesamiento.

También debemos tener en cuenta los protocolos de transmisión de datos. Estos protocolos, nos permiten que un paquete llegue en buenas condiciones y por la vía correcta, desde un nodo a otro, introduciendo información extra sobre cómo debe ser tratado, qué tipo de cifrado lleva, y otros aspectos importantes para su identificación y enrutamiento. Como te podrás imaginar, extraer toda la información que está dentro de estos paquetes también costará tiempo y esto se traduce en latencia.

Existen gran cantidad de protocolos de transmisión en redes, pero los más conocidos sin duda son el TCP (Protocolo de control de transmisión) e IP (protocolo de Internet) y su combinación. Estos protocolos se utilizan para varias funciones, principalmente para el correcto enrutamiento de los paquetes (protocolo IP) y para el control de errores y asegurar que la infoamcion llegue correctamente (protocolo TCP).

El medio físico de transmisión, latencia fibra óptica

De igual forma, transmitir por un medio físico, en la mayoría de ocasiones, será más rápido que hacerlo mediante ondas, aunque la implementación de las frecuencias de 5 GHz a dotado de mayor velocidad de transmisión este tipo de redes.

El medio más rápido actualmente es, sin duda, la fibra óptica, ya que prácticamente no introduce latencia o Lag en la conexión. La transmisión de datos a través de impulsos fotoeléctricos es hoy por hoy el de mayor capacidad, tanto en ancho de banda como en velocidad de conmutación.

De la cantidad de conmutaciones que se deban producir hasta llegar al destino.

También tendrá mucho que ver los saltos que deba dar el paquete antes de llegar al destino, no es lo mismo tener un cable directo entre un nodo y otro, que pasar por 200 nodos distintos hasta llegar. Cada uno de ellos estará perdiendo tiempo mientras se encarga de trasladar el paquete desde una puerta a otra, debemos tener en cuenta que Un paquete nunca llega directamente al destino, antes viajará por multitud de servidores que necesitarán procesarlo, e incluso añadirle información extra para reenviarlo al destino. Y a lo mejor este destino está en la Conchinchina y más allá.

En este punto, te habrás fijado que no hemos hablado demasiado de ancho de banda de una conexión, y es precisamente lo que más miramos a la hora de contratar una un proveedor de Internet.

Diferencia entre Ancho de banda y Latencia ¿Cuándo es importante cada una de ellas?

Cuando hablamos de ancho de banda de una conexión, nos estamos refiriendo a la cantidad de información que somos capaces de transmitir desde un punto a otro por unidad de tiempo. Mientras más ancho de banda tengamos, más cantidad de paquetes podremos descargar de forma simultánea. La unidad de medida es la de bits por segundo b/s, aunque actualmente la medida casi siempre es la de Megabits por segundo (Mb/s). Si hablamos en términos de almacenamiento serán Megabytes por segundo (MB/s) en donde un byte equivale a 8 bits.

Si nos fijamos estamos cometiendo un error, hablamos de velocidad de Internet cuando hablamos de ancho de banda, y esto debería ser la latencia. Sin embargo, todos estamos habituados a esto, y no tenemos dudas acerca de ello, por lo que hablaremos de latencia para referirnos a ésta y de velocidad para referirnos al ancho de banda.

Ahora tenemos que saber cuándo debemos de tener en consideración ambas medidas según a lo que destinemos nuestra conexión.

Ancho de banda

Si queremos utilizar nuestra conexión para descargar contenido situado de forma estática en un servidor (imágenes, videos, juegos) entonces el ancho de banda será esencial. No nos importa si la conexión tarda en establecerse 10 segundos, lo importante es que el fichero tarde el menor tiempo posible en descargarse. Si un fichero ocupa 1000 MB y tenemos una conexión de 100 MB/s, tardaremos 10 segundos en descárgalo. Si tenemos una conexión de 200 MB/s, tardaremos 5 segundos, fácil.

Latencia

Será fundamental cuando queremos utilizar nuestra conexión para reproducir contenido en tiempo real como ver streaming o para jugar partidas online masivas. Si nos damos cuenta, en este caso necesitamos que lo que se transmite y recibimos, se haga de forma simultánea, sin congelamientos de imagen y búferes de carga. Cuando jugamos y vemos que un avatar de jugador aparece y desaparece mágicamente y da saltos, significa que o él o nosotros tenemos Lag o alta latencia. Lo que vemos, aunque se esté produciendo en ese instante, solamente vemos trozos sin continuidad porque el tiempo que tarda en enviarse la información a nuestro equipo es mucho mayor que lo que está ocurriendo en la realidad.

Si hablamos de juegos FPS shooter y tenemos una latencia muy alta, ni nos vamos a enterar cuando nos matan, ni vamos a saber la posición exacta de un contrincante. Por supuesto será importante el ancho de banda, pero la latencia cobra un papel fundamental.

Cómo medir la latencia de nuestra conexión

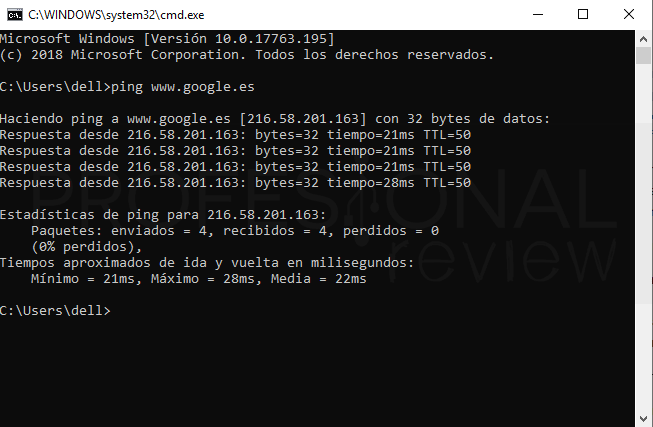

Para medir la latencia de nuestra conexión, podremos utilizar una herramienta que está implementada en Windows desde sus inicios, se llama Ping. Para utilizarla tendremos que abrir una ventana de comandos, dirigiéndonos al menú inicio y escribiendo «CMD«. Se abrirá una ventana en negro en donde tenemos que colocar el siguiente comando:

ping <direccion ip o web>

Por ejemplo, si queremos ver la latencia entre Profesional Review y nuestro equipo, colocaremos «ping www.Profesionalreview.com«.

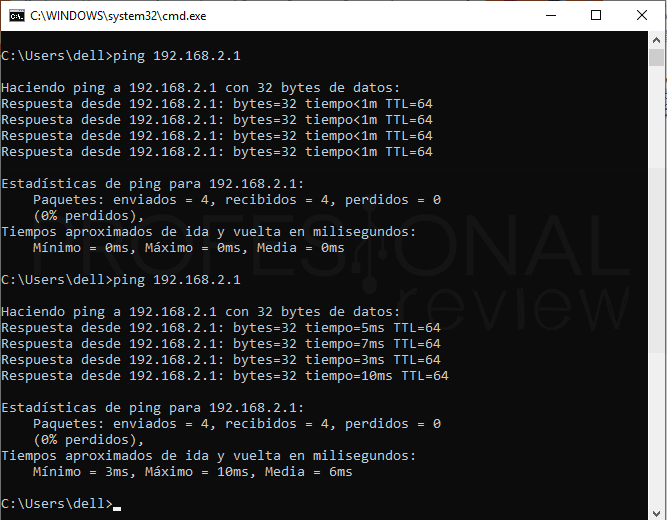

Nos debemos fijar en la parte de «tiempo=XXms«, esa será nuestra latencia. Veamos cómo afecta el tipo de conexión a la latencia. Para ello, vamos a ver la diferencia entre una conexión por cable y una conexión Wi-Fi desde lejos en el mismo equipo haciendo un ping a nuestro propio router.

Vemos que, mediante cable la latencia es prácticamente nula, menor a 1 milisegundo, en cambio mediante Wi-Fi ya estamos introduciendo del orden de 7 milisegundos. Es precisamente por este motivo por lo que los jugadores siempre quieren utilizan una conexión física a una Wi-Fi. Estos 7 ms se traducirán en congelamientos de imágenes y tirones si los sumamos al lag propio que meterá la conexión remota.

Visita nuestro tutorial para más información sobre el comando ping y como saber la IP externa

Pues bien, ya nos habrá quedado claro más o menos que es la latencia en Internet y como debemos de tenerla en cuenta. Ahora vamos a ver dónde más aparece la latencia.

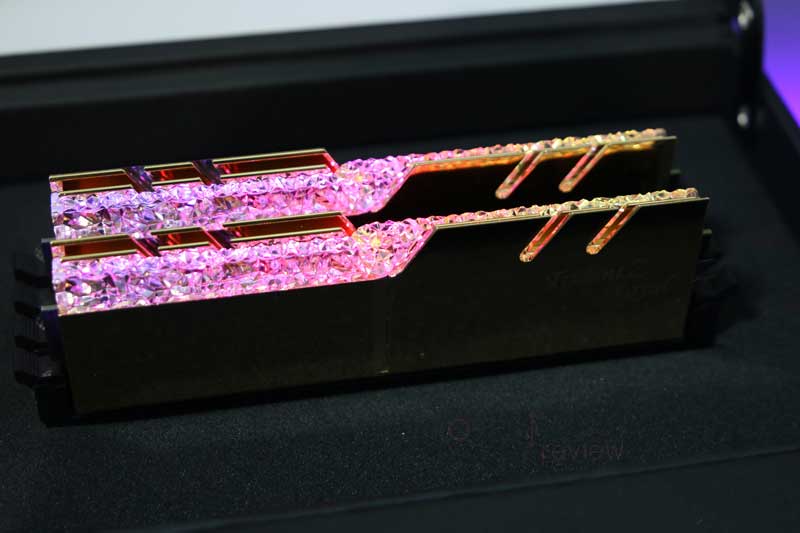

Latencia en memoria RAM

Seguramente este será el segundo apartado más importante en el que debemos de tener en cuenta la latencia de un elemento de nuestro equipo, o al menos el que ha obtenido más fama en los últimos años con las memorias RAM DDR3 y DDR4.

Para el caso de la memoria RAM la definición es un poco distinta a lo que hemos entendido en redes. En este caso entra en juego un elemento tan importante como los ciclos de reloj a los que trabaja nuestro procesador (frecuencia). En cualquier caso, estamos siempre hablando de una medida de TIEMPO, y no de algo distinto.

La latencia real en memoria RAM se denomina CAS o CL, y no es más que el número de ciclos de reloj que transcurren desde que se realiza una petición por la CPU y la memoria RAM tiene la información disponible. Estamos midiendo el tiempo que transcurre entre la petición y la respuesta.

Visita este completo artículo hablando sobre la latencia de la memoria RAM para saberlo todo acerca de ella.

Latencia en disco duro

Otro dispositivo en donde podremos encontrar unos tiempos de latencia de gran importancia, es en los discos duros, especialmente en los basados en elementos mecánicos. En este caso, la latencia se traduce en varios términos distintos y enfocados en funciones concretas:

Tiempo de acceso

Básicamente es el tiempo que tarda la unidad de almacenamiento en estar preparada para transmitir los datos. Un disco duro, está formado por unos platos giratorios en los que físicamente se graban los datos, a su vez estos datos deberán ser leídos por un cabezal mecánico que se mueve de forma perpendicular barriendo toda la superficie del disco.

El tiempo de acceso es que el tiempo que se toma el disco duro en leer nuestra petición de información y situar el cabezal mecánico justamente en el cilindro y sector concreto en donde está esta información para ser leída. Simultáneamente a esto, el disco duro gira a gran velocidad, por lo que el cabezal una vez situado en el sector, tendrá que esperar a que la pista llegue a este. Solamente en este momento la información estará preparada para ser leída y transmitida.

El tiempo de acceso se puede dividir en varias funciones la cuales hemos descrito en estos párrafos:

Tiempo de búsqueda

Es precisamente el tiempo que tarda el cabezal en situarse sobre el cilindro, sector y pista que contienen los datos. Este tiempo de búsqueda, puede varía entre los 4 milisegundos de las unidades más veloces, hasta los 15 ms. Lo más común para los discos duros de escritorio son de 9 ms.

En las unidades SSD no existen parte mecánicas, por lo que el tiempo de búsqueda se sitúa entre los 0,08 y 0,16 ms. Enormemente menor que los mecánicos.

Latencia por rotación:

Este concepto mide el tiempo que tarda el cabezal en alcanzar la pista de datos debido a la propia rotación del disco duro. Los discos duros están continuamente en rotación, por lo que durante ciertos intervalos de tiempo el cabezal se encontrará con pistas de datos intermitentes. A mayor número de revoluciones (giros) más rápido se podrá acceder a los datos de una pista concreta. Para un disco duro promedio de 7.200 RPM obtendremos una latencia de 4,17 ms.

Otros retrasos que añaden latencia

Entre otros retrasos propios de una transmisión de información, está el tiempo de procesamiento comandos y el tiempo de estabilización del cabezal. El primero será el tiempo que el hardware tarde en leer, procesar y transmitir los datos al bus, que normalmente son unos 0,003 ms. El segundo es el tiempo que tarda en estabilizarse el cabezal tras moverse, por el hecho de ser mecánico, esto llevará un cierto tiempo de unos 0,1 ms.

Luego también podremos sumar otros tiempos al tiempo de transmisión de datos como los siguientes:

- Tiempo de sector: tiempo que tarda el sector del disco duro en validarse y ser localizado física y lógicamente.

- Tiempo de salto de cabezal: tiempo que trascurre entre la conmutación de un cabezal a otro para leer la información. Ya que debemos tener presente que los discos duros tienen dos cabezales por cada plato que tengan. Normalmente está en 1 y 2 ms.

- Tiempo de cambio de cilindro: lógicamente el tiempo que transcurre entre que cambiados de un cilindro a otro. Esto normalmente son unos 2 o 3 ms.

¿En qué se traduce esto? Pues en que un disco duro mecánico es endemoniadamente lento frente a una unidad SSD. Es por esto por lo que los SSD suben de forma sustancial el rendimiento de cualquier equipo, incluso los antiguos.

Latencia en ratones y headsets inalámbricos

Tampoco nos podemos olvidar de los ratones inalámbricos en el campo de la latencia. Ya hemos comprobado empíricamente que la latencia en un medio de radiofrecuencia sube respecto a las conexiones físicas, y esto no es una excepción en los ratones inalámbricos.

Los ratones inalámbricos operan en su mayoría, en un rango de frecuencia de 2,4 GHz, podemos imaginar que esta es muy rápida, sobre todo si el receptor lo tenemos cerca, pero no va a tener una latencia inferior que un ratón de cable, incluso de modelos interiores en gama. Es precisamente por este motivo por el que la mayoría de ratones gaming tienen conectividad alámbrica y no inalámbrica, excepto modelos de muy alta gama con un coste elevado.

Exactamente lo mismo ocurre con los headset, sin embargo, en este caso concreto, se trata de sonido, en donde nosotros biológicamente ya tenemos una cierta latencia para reaccionar a los sonidos que se producen en nuestro ambiente. Es por esto que las prestaciones de un headset inalámbrico (bueno) y uno alámbrico será muy similar, en nuestro oído y a efectos de uso. No será, por tanto, tan importante como un ratón u otro componente.

Conclusión sobre la latencia en nuestro ordenador

Pues estas son las principales medidas de latencia que debemos tener en cuenta en nuestro equipo informático. Sin duda, la más importante de todas seguramente será la de la conexión a Internet, ya que es la que más vamos a notar en nuestro uso diario de la red, especialmente si nos dedicamos a jugar online. Y también por supuesto la de un disco duro si nuestro sistema está instalado en uno mecánico.

En los demás casos, prácticamente no podremos hacer mucho para mejorar las prestaciones de los componentes, ya que es una característica inherente de ellos, especialmente de los discos duros. Si hemos comprado un SSD viniendo de usar un HDD seguramente notaremos que la diferencia de rendimiento es abismal.

En el caso de la memoria RAM, si has visto nuestro artículo especialmente dedicado a ella, sabrás cómo la podemos medir, pero poco podremos hacer para mejorarla, de hecho, es algo prácticamente imperceptible para nosotros, teniendo en cuenta las altas frecuencias a las que trabajan los módulos y toda la placa base. Además, esta carencia se suple con la alta frecuencia a las que trabajan.

La latencia es algo que absolutamente siempre va a formar parte de la arquitectura de un ordenador o de cualquier otro elemento. Siempre existirá un lapso de tiempo entre una petición y una ejecución sea cual sea el medio utilizado y el elemento conectado. Nosotros mismos y nuestros estímulos, son la mayor fuente de LAG o latencia.

También te recomendamos:

¿Crees que la latencia es realmente importante en un ordenador o una red? Déjanos comentarios sobre tu opinión acerca de este tema. ¿Se te ocurre algún otro componente en el que la latencia se deba tener en cuenta?